IBM DB2数据复制和迁移那些事儿,淘宝级别操作其实没那么难

- 问答

- 2025-12-31 04:42:09

- 3

说到IBM DB2的数据复制和迁移,尤其是要达到淘宝那种海量数据和高并发访问的级别,很多人一听就觉得是顶级专家才能碰的领域,心里先打了退堂鼓,但其实啊,这事儿就像搭乐高,只要理解了核心的几块积木,再大的工程也能一步步拆解完成,今天咱们就抛开那些让人头晕的专业术语,用大白话聊聊淘宝级别的DB2数据操作,核心到底是什么。

你得明白淘宝这类系统面临的根本问题,想象一下双十一零点,每秒有几十万上百万人同时抢购、下单、查询,如果所有这些操作都直接压到一台主DB2数据库上,就算它是顶级服务器,也瞬间就被压垮了,这就像只有一个收银台的超市,逢年过节肯定排长龙到崩溃。

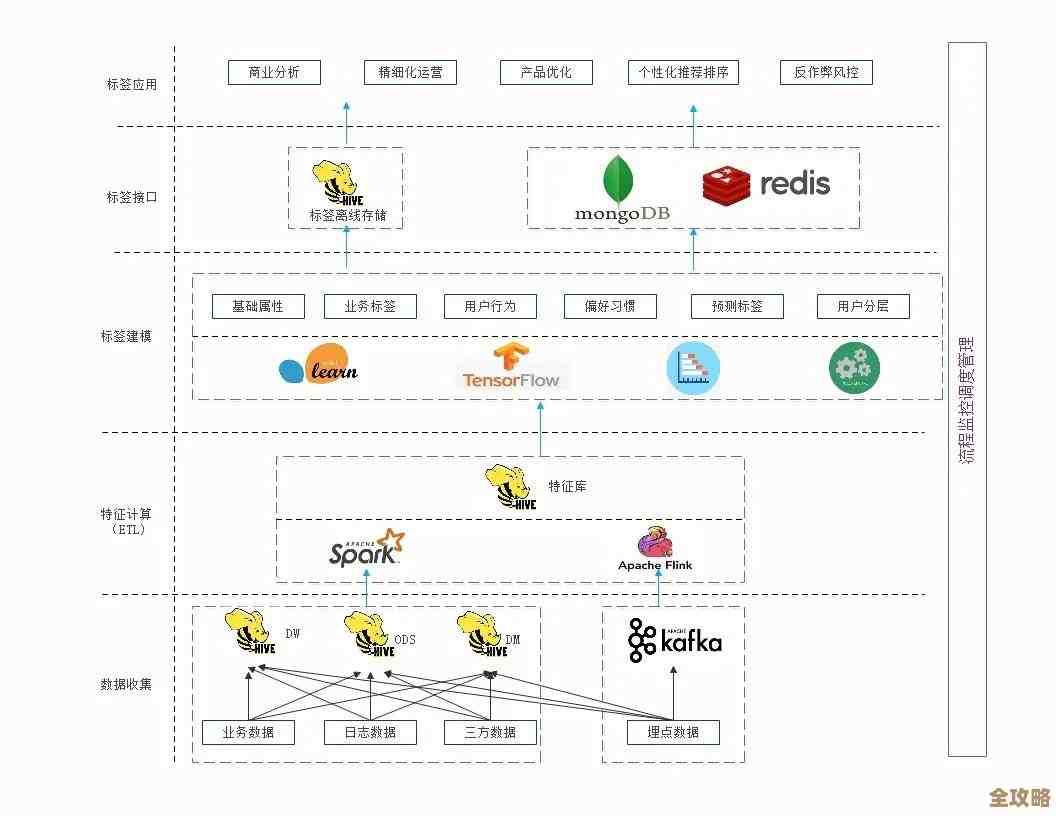

那怎么办呢?淘宝的工程师们很早就用了两个核心的法宝:读写分离和数据分库分表,这两个词听起来专业,其实道理很简单。

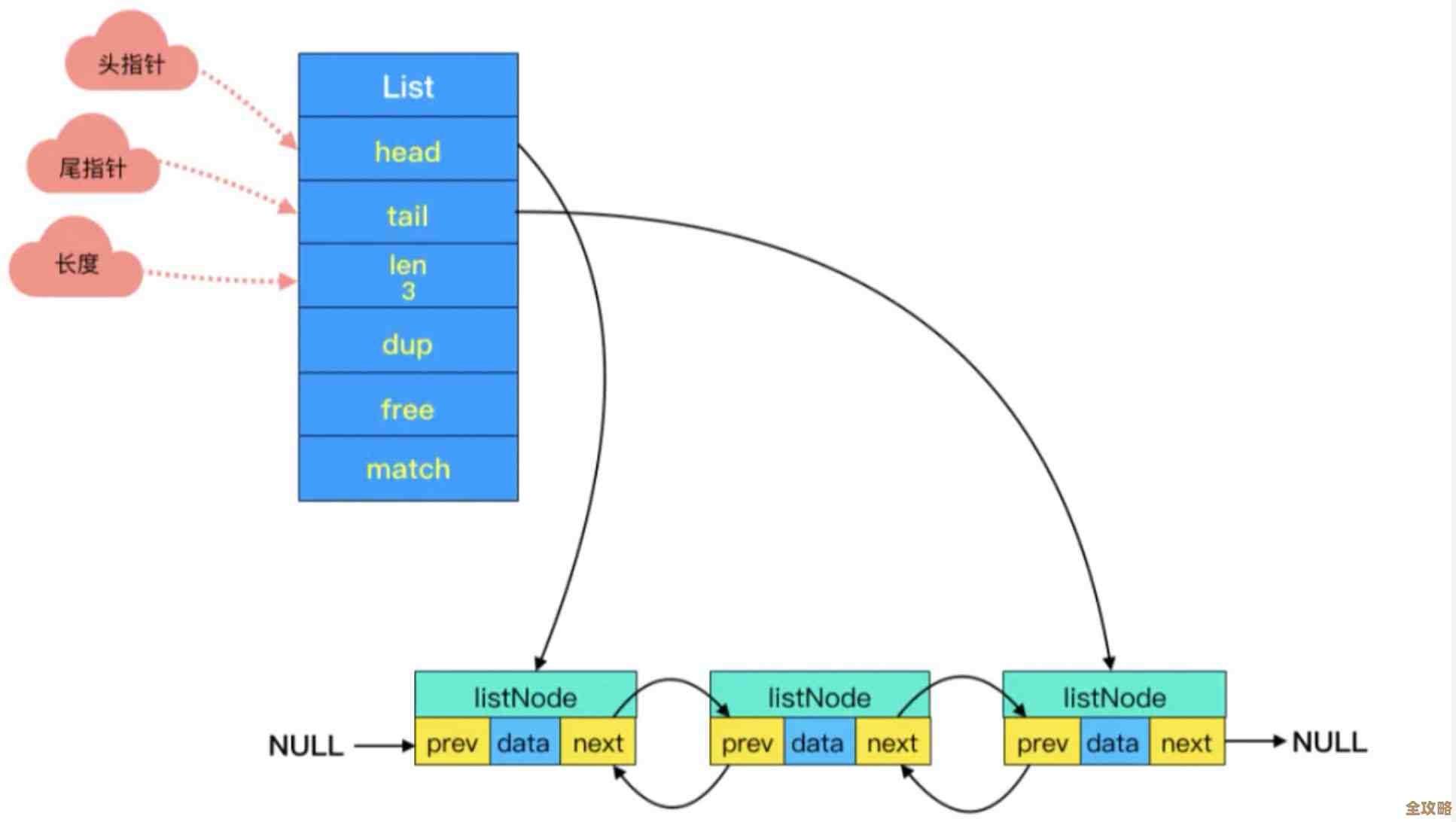

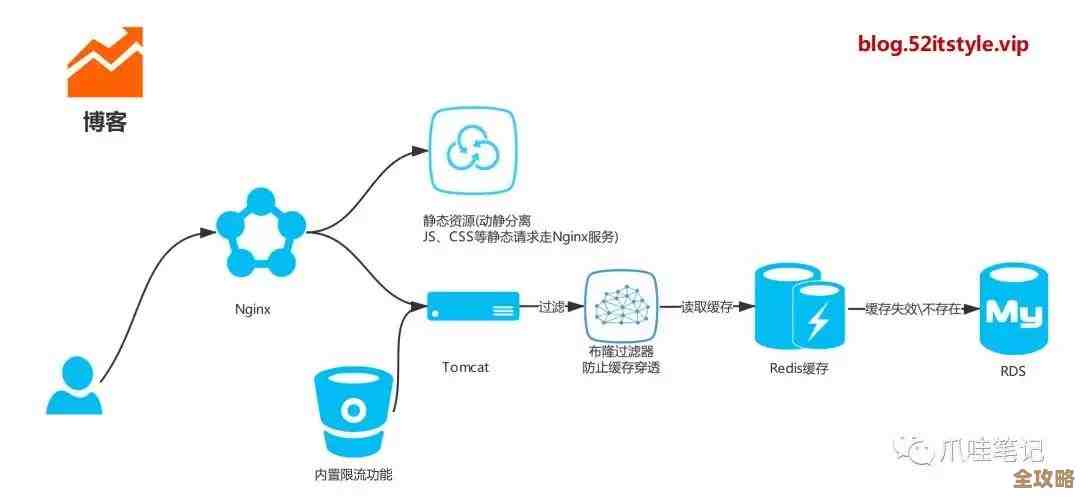

先说读写分离。 这就像一家餐馆,炒菜的厨师(写数据)在后厨,而给你端菜、介绍菜单的服务员(读数据)在大堂,你不能让每个顾客都跑进后厨去问今天有什么菜,那样后厨就乱套了,对应到DB2,就是搞一个主数据库(Master),专门负责处理“写”操作,比如下单、扣减库存,把这个主数据库的数据,“复制”到好几个从数据库(Slave)上去,这些从数据库就只负责“读”操作,比如用户查询商品、查看订单,这样一来,写压力由主库扛着,大量的读请求就被分摊到多个从库上了,系统处理能力成倍增长。

关键问题来了:怎么把主库的数据“复制”到从库,并且保证数据是基本一致的?在DB2世界里,这主要靠它自带的Q复制(Q Replication) 和 SQL复制(SQL Replication) 这两种技术。

根据IBM官方技术文档的介绍,SQL复制的工作原理有点像“拍照+传递”,它会在主数据库上给要复制的表拍一张快照(这个快照点叫做“一致点”),然后持续监视这张表的数据变化日志(DB2里叫日志),把这些变化抓取出来,转换成标准的SQL语句(比如INSERT, UPDATE, DELETE),再应用到从数据库上,这种方式比较稳健,对网络短暂中断的容忍度稍高,因为它有重试机制,但延迟可能会稍微高一点点,通常是秒级。

而Q复制就更高级一点,它追求的是极致的速度和低延迟,它不像SQL复制那样转换成SQL语句,而是直接把数据变化日志里的数据块,通过一个高效的消息队列(比如IBM MQ)几乎是实时地“扔”给从数据库,从数据库那边有个程序接着这些数据块,直接应用到本地,这种方式速度非常快,能达到毫秒级的延迟,非常适合对实时性要求极高的金融交易等场景,淘宝在处理核心交易链路时,很可能就采用了类似Q复制这种高性能方案来保证数据同步的即时性。

再说说数据分库分表。 光有读写分离还不够,比如淘宝的商品数据有几十亿条,用户好几个亿,都放在一个数据库里,就算只读不写,查询起来也像在图书馆里找一本没有编号的书,慢得可怕,分库分表就是解决这个问题的,简单说,拆”,可以按用户ID的尾数拆,把尾数是0-3的用户数据放到一个数据库集群,4-7的放到另一个,8-9的再放到一个,也可以按商品类目拆,家电一个库,服装一个库,这样,一次查询就不用扫描整个巨大的数据库,而只需要在某个小的分库里去查找,速度自然就上去了。

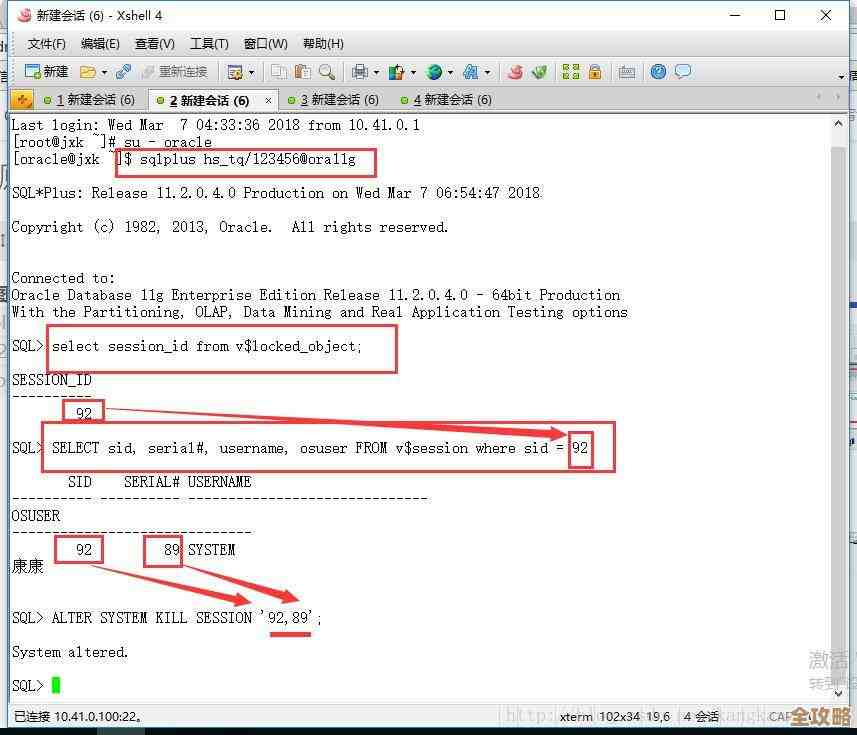

迁移工作也一样,核心思想是“平滑”二字,你不能在双十一晚上把数据库停了再搬数据,业内标准的做法是:先通过上面说的复制技术,让新库和旧库实时同步着;然后在某个访问低峰期,比如凌晨两三点,短暂暂停一下写入,确保两边数据完全追平后,把流量切换到新库上,这就像给飞驰的汽车换轮胎,得先让新旧轮子一起转一会儿,再瞬间把车身重量从旧轮子转移到新轮子上。

所以你看,淘宝级别的操作,背后的核心逻辑并不神秘,它就是把这些基础技术——读写分离、数据复制(SQL复制/Q复制)、分库分表——根据自己业务的规模和创新地组合运用到了极致,IBM DB2提供的这些复制工具,本身就是为应对企业级关键任务而设计的,具备了处理海量数据和高并发的潜力,真正的难点不在于工具本身,而在于如何根据业务特点去规划分库分表的策略,如何设计平滑的迁移方案,以及如何在运维中监控和保障这套复杂系统的稳定运行,这些才是体现技术团队功力的地方,而这些东西,是通过不断的实践和学习可以掌握的。

本文由酒紫萱于2025-12-31发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/71678.html