想快速上手Apache Kafka?这篇指南帮你轻松搞定基础和实操技巧

- 问答

- 2026-01-17 04:57:50

- 2

想快速上手Apache Kafka?这篇指南帮你轻松搞定基础和实操技巧 综合参考自Apache Kafka官方文档、Confluent博客以及《Kafka权威指南》等常见学习资源)

你是不是经常听到“Kafka”这个名字,感觉它很厉害,是大数据领域离不开的消息系统,但一看到那些专业术语就觉得头大?别担心,这篇文章的目的就是剥开Kafka复杂的外壳,用最直白的方式带你理解它到底是什么,以及怎么亲手把它跑起来。

Kafka到底是什么?我们可以打个比方

想象一下,你所在的城市有一个超级高效、从不出错的邮政系统,这个系统就是Kafka。

- 主题(Topic):就像是你想寄送的“邮件种类”,有专门寄送“用户注册通知”的邮路,有寄送“订单下单信息”的邮路,还有寄送“网站点击日志”的邮路,在Kafka里,这些不同的邮路就叫做“主题”,你把不同类别的信息放到不同的主题里,方便管理。

- 生产者(Producer):就是寄信的人,你的网站程序每当有一个新用户注册时,它就会产生一封写着“新用户张三注册了”的信,然后把它丢进“用户注册通知”这个邮筒(主题)里,这个网站程序就是生产者。

- 消费者(Consumer):就是收信的人,有一个数据分析程序,它专门守在“用户注册通知”这个邮路的尽头,每当有新的信送来,它就立刻拿走去分析,比如统计今天注册了多少人,这个数据分析程序就是消费者。

- 消息(Message):就是信本身,里面装着具体的内容,比如那段“新用户张三注册了”的JSON数据。

Kafka的核心就是一个高吞吐量的消息中转站,生产者不停地往里面扔消息,消费者根据自己的需要去取消息,双方不用直接联系,通过Kafka这个中间人解耦了。

两个关键设计:为什么Kafka这么牛?

光有邮政系统还不够,Kafka的厉害之处在于它的两个独特设计:

-

日志(Log)存储:消息是“追加”的,不是“覆盖”的 你可以把每个主题(用户注册通知”)想象成一个只能追加写、不能修改的账本,新的消息来了,就写在账本的最后一页,这样做的好处是速度极快,因为磁盘的顺序读写远比随机读写快得多,这也是Kafka能处理海量数据的秘诀之一。

-

分区(Partition)和消费者组(Consumer Group):实现“多人协作”

- 分区:如果一个主题的消息量非常大,一个账本(分区)可能记不过来,Kafka允许你把一个主题拆分成多个账本(分区),这些分区可以放在不同的服务器上,这样,就可以并行处理了。

- 消费者组:如果一个主题的消息非常多,一个消费者处理不过来怎么办?我们可以组建一个“消费者小组”,小组里的多个消费者可以一起工作,共同消费一个主题的消息,Kafka会智能地将不同分区的消息分配给小组内的不同消费者,主题有3个分区,消费者小组有3个成员,那么很可能是每人负责处理一个分区的消息,效率提升了3倍。

动手实操:用Docker快速搭一个Kafka环境

理论说再多不如动手试一试,用Docker是最快、最干净的方式,不会弄乱你的本地环境。

-

安装Docker 如果你还没安装Docker,请先去Docker官网下载并安装Docker Desktop。

-

一键启动Kafka Kafka运行需要依赖ZooKeeper(你可以理解为Kafka的“管理员”,负责管理元数据),我们可以用

docker-compose来一键启动所有服务,创建一个名为docker-compose.yml的文件,内容如下:version: '3' services: zookeeper: image: wurstmeister/zookeeper ports: - "2181:2181" kafka: image: wurstmeister/kafka ports: - "9092:9092" environment: KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://localhost:9092 KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181 depends_on: - zookeeper(此Docker Compose配置参考自Wurstmeister的Kafka Docker镜像文档)

在终端里进入这个文件所在的目录,运行命令:

docker-compose up -d

看到两个容器都启动成功后,你的单机版Kafka就已经在本地运行了!

-

基本操作:创建主题、发送消息、消费消息 我们现在进入Kafka容器内部,使用它自带的命令行工具来玩一玩。

-

创建主题 执行以下命令,创建一个名为

test-topic的主题,只有一个分区,一个副本。docker exec -it [你的kafka容器名] kafka-topics.sh --create --topic test-topic --bootstrap-server localhost:9092 --partitions 1 --replication-factor 1

-

启动一个控制台生产者(发送消息) 新开一个终端窗口,执行命令启动一个生产者,然后你就可以输入想发送的消息了。

docker exec -it [你的kafka容器名] kafka-console-producer.sh --topic test-topic --bootstrap-server localhost:9092

-

启动一个控制台消费者(接收消息) 再新开一个终端窗口,执行命令启动一个消费者,它会一直等着接收

test-topic里的新消息。docker exec -it [你的kafka容器名] kafka-console-consumer.sh --topic test-topic --bootstrap-server localhost:9092 --from-beginning

--from-beginning参数表示从主题的第一条消息开始消费。

你在生产者的窗口里输入“Hello Kafka”,然后回车,马上就能在消费者的窗口里看到这行字了!恭喜你,完成了Kafka的第一次消息传递。

-

下一步可以学什么?

当你成功运行了上面的例子,就可以继续探索更深入的内容了:

- 用代码操作Kafka:学习如何使用Java、Python、Go等语言的Kafka客户端库,在你的应用程序中扮演生产者和消费者。

- 理解消息可靠性:消息会不会丢?会不会重复?学习Kafka的ACK机制和幂等性。

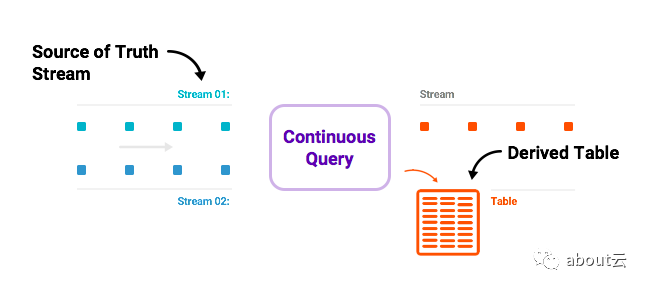

- 探索流处理:了解Kafka Streams或ksqlDB,直接对流动的数据进行实时处理和分析,而不仅仅是简单地搬运。

希望这篇指南能帮你打破对Kafka的畏惧感,它本质上就是一个设计精巧的“消息邮局”,先从理解核心概念和动手实践开始,你就能轻松入门了。

本文由钊智敏于2026-01-17发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/82210.html