从Ceph的角度聊聊分布式系统里那些故障怎么被发现和处理

- 问答

- 2026-01-13 20:28:45

- 7

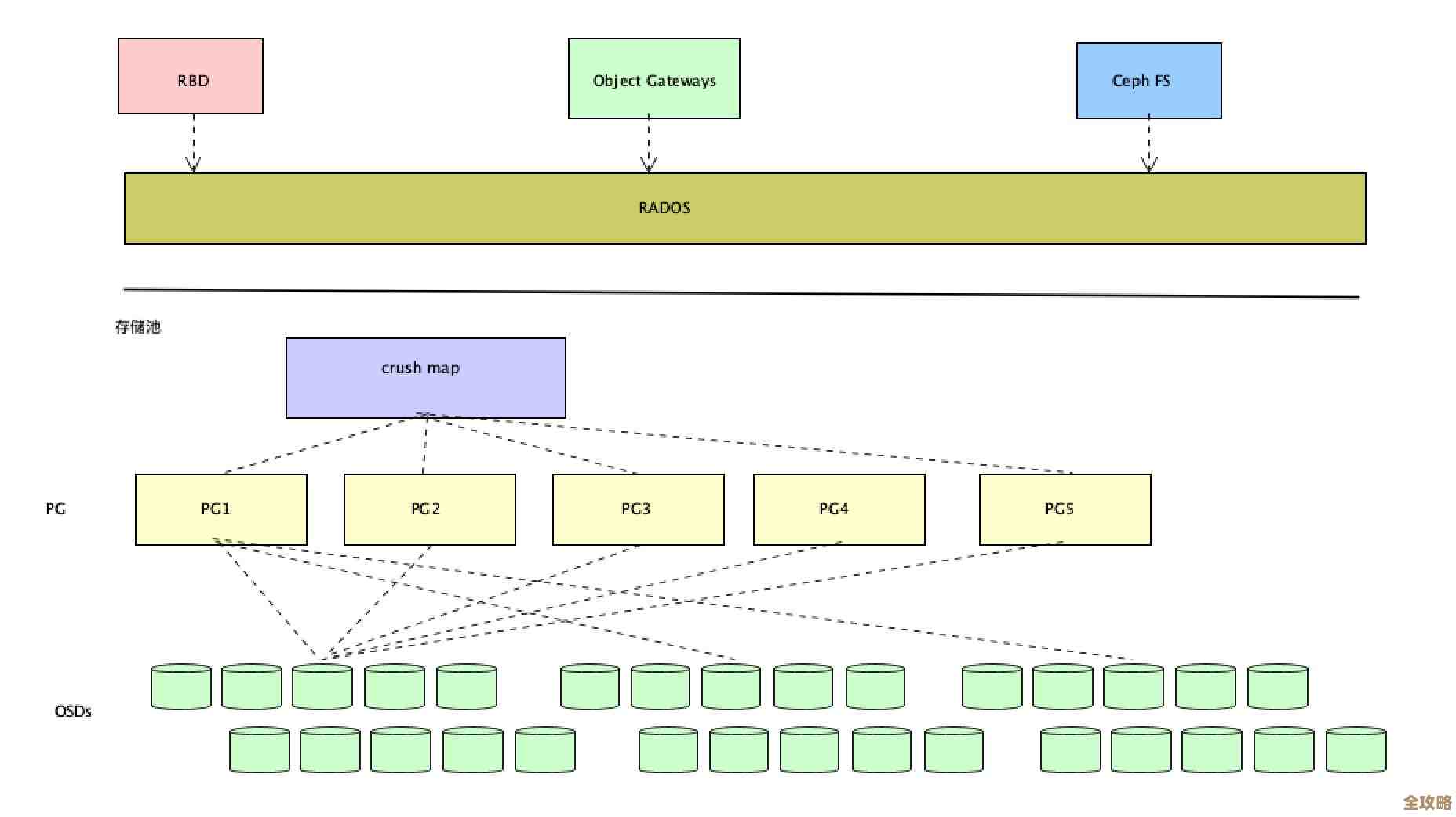

想象一下Ceph就像一个庞大的、自动化的超级仓库,里面不是放货物,而是放数据,这个仓库由很多很多台普通的电脑(我们叫它们节点)组成,这些电脑分工合作,有的负责管理仓库的目录(元数据服务器MDS),有的负责记录数据到底存放在哪个货架上(监控器MON),但数量最多、干活最累的是那些真正存放数据的“货架”本身(对象存储设备OSD),在一个成千上万台电脑组成的系统里,每天都有电脑会出毛病,比如硬盘坏了、网线断了、或者干脆停电了,Ceph的核心本领就是能淡定地处理这些日常故障,保证数据不丢,服务不停。

故障是怎么被发现的?关键在于“心跳”机制。

这就像是在这个庞大的仓库里,每个“货架”(OSD)都必须每隔几秒钟就向“保安队长”(MON)报告一声:“我还活着,一切正常!”(根据Ceph官方文档和架构说明,OSD会定期向Monitors报告其状态),这个报告就是“心跳”。

-

发现单个故障: 如果一个“货架”突然沉默了,比如超过5次(这个时间可配置)都没有报告,保安队长”就会立刻警觉起来,它不会傻等,而是会去问这个沉默“货架”的邻居:“你们还能联系上它吗?”如果邻居们也纷纷表示联系不上,保安队长”就基本断定:“第105号货架掉线了!”它会立刻在仓库的公共公告牌(集群状态图)上更新一条消息:“注意!105号货架故障,上面的货物暂时无法存取。”(这个过程基于Ceph的故障检测和Paxos共识算法,Monitors通过法定人数达成一致后更新集群映射图)

-

发现网络分区(脑裂): 更复杂一点的情况是网络问题,仓库有一半区域的网络交换机坏了,导致这片区域的几十个“货架”虽然自己没坏,但它们和“保安队长”失去了联系,这时候,从“保安队长”的视角看,这几十个“货架”同时失联了,但“保安队长”很聪明,它不会贸然宣布所有这些货架都坏了,因为它自己也可能会想:“是不是我这边网络出问题了?”它会和其他的“保安副队长”(其他MON节点)开会商量,如果多数派的“保安队长”们还能互相联系并达成一致,它们就会宣布:“A区网络中断,A区的所有货架暂时划为不可用状态,由我们B区的货架继续提供服务。”这样就避免了“脑裂”——即两个区域都以为自己是主仓库,同时写入数据造成混乱。

故障被发现后,又是如何处理的?核心是“复制”和“自愈”。

Ceph处理故障的精髓不是防止故障发生(因为故障是必然的),而是在故障发生后能自动、快速地恢复,它的底气来自于数据副本。

-

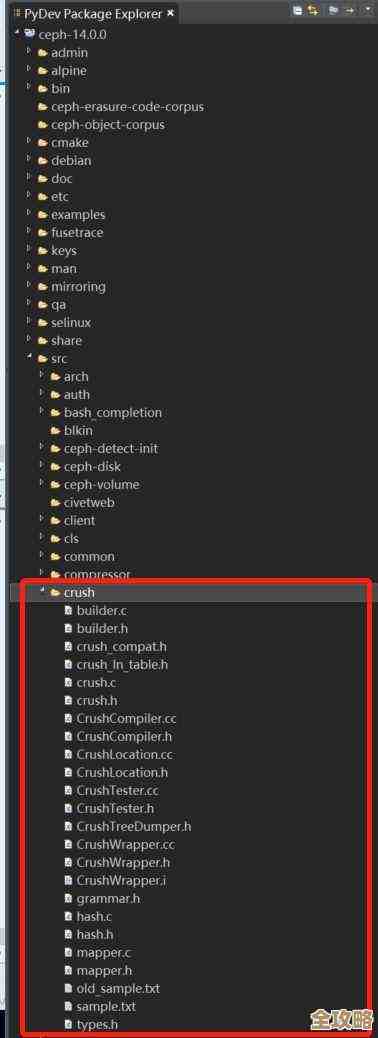

数据冗余是基础: 在Ceph这个仓库里,任何一件货物(数据对象)都不是只放在一个“货架”上的,默认情况下,每件货物都会复制成3个完全一样的副本,然后由CRUSH算法智能地、均匀地分散到不同的机架、不同服务器的不同硬盘上(CRUSH算法是Ceph数据分布的核心),这样做的目的是:即使坏掉一两个货架,甚至整个机架断电,数据的其他副本仍然安然无恙,服务可以照常进行。

-

触发恢复流程: 当“保安队长”(MON)确认某个OSD故障并更新了集群状态后,整个系统的“自愈”程序就自动启动了,它会立刻做两件事:

- 恢复: 对于那些原本由故障OSD负责的主副本数据,系统需要为它们在其他健康的OSD上指定新的“主副本”,这个过程很快,目的是尽快恢复数据的可写性。

- 回填/修复: 这是更耗时的过程,系统会检查所有因为故障而副本数不足(比如3副本变成了2副本)的数据,然后开始在健康的OSD上创建新的副本,直到恢复成3副本为止,这个过程会占用网络和磁盘资源,但Ceph可以控制其速度,避免影响前台业务,如果一个硬盘坏了,运维人员换上一块新硬盘后,新硬盘加入集群,系统就会自动地把该有的数据副本“回填”到这块新硬盘上,让它重新投入工作(这个过程在Ceph运维文档中有详细描述)。

-

处理更棘手的故障: 如果是负责管理目录的“前台”(元数据服务器MDS)坏了怎么办?Ceph同样有备胎方案,通常会有主备多个MDS,主MDS挂了,监控器MON会迅速从备用的MDS中选举出一个新的主MDS,由于MDS的内存状态其实最终是保存在MON的集群图里的,并且日志会写入到多个OSD上,所以新的MDS能够快速重建内存中的目录结构,继续提供服务。

Ceph面对故障的策略非常务实:它承认故障是常态,所以把精力花在了快速发现和自动恢复上,通过简单却极其可靠的“心跳”机制发现故障,再依靠数据多副本和智能的CRUSH分布算法作为安全垫,最后启动高效的数据迁移和复制来完成自愈,这一切都是为了实现分布式系统的一个终极目标:即使系统的组成部分不断出现故障,整个系统作为一个整体,依然能够持续、可靠地对外提供服务。

本文由度秀梅于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/80131.html