Redis缓存太大咋整,优化处理方法和注意点分享

- 问答

- 2026-01-07 16:25:41

- 4

Redis缓存变得太大,确实是个让人头疼的问题,它会让服务器内存告急,拖慢整个系统的速度,甚至可能导致Redis服务崩溃,数据丢失,要解决这个问题,咱们不能只想着加内存,那只是治标不治本,关键是要从根儿上优化,下面我就结合一些常见的实践和像“Redis官方文档”、“阿里云开发者社区”等资料中提到的一些思路,来聊聊具体该怎么做以及要注意些什么。

第一招,也是最重要的一招:分析你的数据,搞清楚内存都被谁吃了。

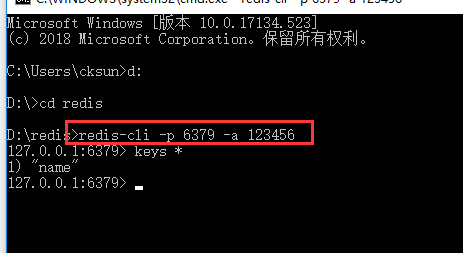

你不能瞎优化,得先知道问题出在哪儿,Redis自带了一个很棒的命令叫 redis-cli --bigkeys(来源:Redis官方文档),这个命令可以快速扫描整个数据库,帮你找出哪些key占用的内存最大,你可能发现某个哈希表(Hash)或者集合(Set)大得离谱,这就是你需要重点关照的对象。

除了找大key,还要用 INFO memory 命令看看内存使用的详细情况,内存消耗大不一定全是业务数据造成的,也可能是Redis自身管理内存的开销,或者客户端连接太多导致的,先诊断,再下药,这是基本原则。

第二招,给数据“瘦身”,能省一点是一点。

-

精简Key的名称:这是个很简单但容易被忽视的点,你别用

user:account:balance:123456789这么长的key,试试缩写成u:ab:123456789,虽然一个key省不了几个字节,但当你的key数量达到百万、千万级别时,节省的内存就非常可观了,缩写得让别人也能看懂,别为了省空间把自己也搞糊涂了。 -

选择合适的底层数据结构:Redis提供了多种数据结构,选对了能大幅节省空间,存储一组数字ID,用集合(Set)可能不如用有序集合(ZSet)或者Redis的HyperLogLog(如果你只需要统计基数,即不重复的元素个数)来得节省。“阿里云开发者社区”有文章专门对比过,在小数据量时差异不大,但数据量一大,优势就明显了,再比如,存储对象信息,如果一个对象有很多字段,你可能会用多个String类型的key,但其实用一个Hash类型来存储会更节省内存,因为Redis会优化Hash的存储。

-

压缩value内容:如果value本身是文本(比如JSON格式的配置信息、长文章内容),在存入Redis之前,可以先使用GZIP、LZ4之类的压缩算法压缩一下,取出来的时候再解压,这相当于用一点CPU时间换取了大量的内存空间,这在value比较大的场景下效果尤其显著。

第三招,管理数据的生命周期,让没用的数据及时“下岗”。

缓存之所以叫缓存,就是因为它不是永久存储,很多数据其实有过期时间,如果忘了设置,它们就会永远赖在内存里。

-

坚决设置TTL(过期时间):给绝大多数缓存数据设置一个合理的过期时间,比如用户登录会话可以设置1小时过期,热点新闻数据可以设置1天过期,这是防止内存无限增长的最有效手段之一。

-

选择合适的过期策略:Redis有几种淘汰策略(由

maxmemory-policy配置项控制),当内存达到上限时,Redis会怎么做?(来源:Redis官方文档),默认策略通常是noeviction(不淘汰,直接报错),这很危险,你应该根据业务情况调整。volatile-lru:从设置了过期时间的key中,淘汰最近最少使用的。allkeys-lru:从所有key中,淘汰最近最少使用的。volatile-ttl:从设置了过期时间的key中,淘汰剩余寿命最短的。 如果你的业务数据重要程度都差不多,可以用allkeys-lru;如果能区分出核心数据和可丢失的缓存数据,可以用volatile-lru并只给缓存数据设置TTL。

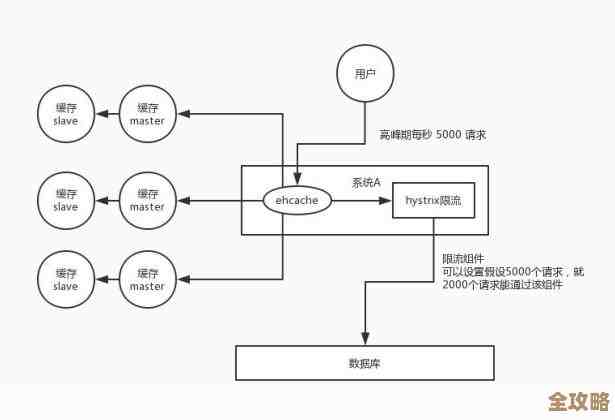

第四招,考虑架构上的调整,分担压力。

如果单台Redis服务器的内存终究还是不够用,那就得从架构层面想办法了。

-

搭建Redis集群(Cluster):这是最正统的解决方案,Redis集群可以把数据分散到多个节点上,每个节点只存储一部分数据,这样就从理论上实现了内存的无限扩容,不过集群的搭建和维护会比单机模式复杂一些。

-

使用分布式缓存方案:除了Redis集群,也可以考虑像Codis这样的代理中间件,或者直接使用云服务商提供的分布式缓存服务,它们帮你处理了分片的复杂性。

-

做业务拆分,分实例存储:不一定非要上集群,如果业务模块清晰,可以把不同业务的数据存到不同的Redis实例里,把用户会话存一个Redis,商品数据存另一个Redis,这样每个实例的内存压力就小多了,也便于管理,这被称为“分片”(Sharding),是一种逻辑上的拆分。

说说需要注意的几个点:

- 监控和报警不能少:一定要有完善的内存监控,别等服务器快撑爆了才发现问题,设置内存使用率的阈值报警,比如达到80%就发出警告,让你有充足的时间去处理。

- 处理大Key要小心:如果你发现了一个几个GB的大Key,直接使用

DEL命令删除可能会因为Redis单线程的特性导致服务短暂卡顿,对于这种大Key,建议使用UNLINK命令(Redis 4.0以上),它是异步删除的,不会阻塞服务,或者,更稳妥的方式是慢慢扫描这个key的一部分一部分地删除。 - 警惕慢查询:一些操作大Key的命令,比如获取一个包含百万成员的集合的所有元素(

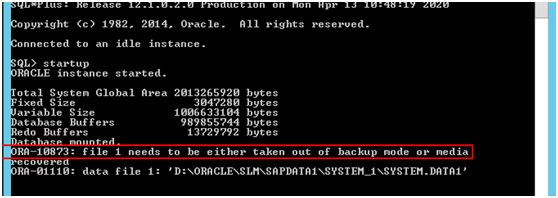

SMEMBERS),可能会非常慢,同样会阻塞其他请求,要避免在生产环境使用这类命令。 - 持久化操作的影响:如果Redis开启了RDB持久化,在生成快照时,如果内存数据量巨大,fork子进程的过程可能会很耗时,导致服务暂停,AOF重写也有类似问题,所以控制内存大小对保障持久化过程的稳定性也很重要。

处理Redis缓存太大的问题,是一个系统工程,它要求你对业务数据有清晰的认识,对Redis的特性有基本的了解,并且要配套完善的监控和运维措施,从设置TTL、优化数据结构这些小事做起,再到架构上的分片集群,一步步来,总能找到适合你当前业务的解决方案。

本文由酒紫萱于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/76295.html