Redis锁机制老出问题,搞得获取锁总失败真让人头大

- 问答

- 2026-01-05 10:54:58

- 12

哎呀,这个Redis锁的问题,可真是说到我心坎里去了,最近这阵子,我们系统里用Redis分布式锁的地方老是出幺蛾子,不是超时就是莫名其妙失败,搞得我头皮发麻,测试那边报障的电话都快被打爆了,静下心来琢磨了好久,也查了不少资料,像Redis的官方文档和一些技术社区像Stack Overflow上的讨论,发现这里面坑还真不少,根本不是简单的set一个key就完事儿的事,我把遇到的这些烦心事和找到的原因捋一捋,你看看是不是也遇到过类似的情况。

首先最让人抓狂的就是锁超时时间设置不当,这大概是新手最容易栽进去的第一个坑了,我们一开始想当然,觉得一个业务操作最多两三秒,那就给锁设个5秒过期时间呗,安全第一,结果呢?有时候碰上数据库压力大一下,或者某个外部接口响应慢了一点点,业务逻辑还没跑完,5秒钟“唰”地一下就过去了,这下好了,锁因为超时被Redis自动释放了,而这时候,第一个请求的业务代码还在那傻乎乎地执行呢,第二个请求一看,诶?没锁了,立马欢天喜地地给自己加上了锁,紧接着,可能第三个请求也来了,好嘛,第一个请求终于执行完了,它开始执行释放锁的删除操作,这一删,直接把第二个请求刚加上的锁给删掉了!导致第三个请求又能拿到锁了,一瞬间,本该互斥执行的代码,两三个实例同时在跑,数据不乱套才怪,这就是网上常说的“锁提前释放”和“误删别人锁”的问题,解决思路也简单,就是设置一个足够长的超时时间,长到能覆盖掉绝大多数业务场景下的正常执行时间,在删除锁的时候,要验证一下这个锁是不是还是自己当初设置的那个,通常的做法是在设置锁的时候,value里存一个唯一的标识,比如UUID,删之前先get一下对比看看,是自己的才删。

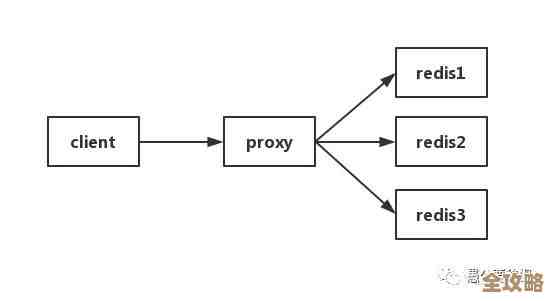

然后另一个头疼的问题是Redis的主从架构带来的坑,为了保证高可用,我们生产环境用的肯定是Redis哨兵或者集群模式,问题就出在这里,客户端A在Master节点上成功加锁了,还没等这个锁的命令同步到Slave节点,Master节点突然宕机了,哨兵机制很快啊,立马选举出一个新的Master(原来的某个Slave),这时候客户端B来加锁,向新的Master申请同一个锁,新Master上压根就没有这个锁的记录(因为旧Master没来得及同步就挂了),所以它很痛快地就给客户端B加锁成功了,这下,客户端A和客户端B同时认为自己持有了锁,互斥性就被破坏了,这个问题就比较棘手了,是Redis异步复制机制本身带来的,单靠普通的set命令很难彻底解决,后来Redis官方推荐了一种叫Redlock的算法,它的核心思想是同时向多个(比如5个)独立的Redis实例尝试加锁,当超过半数的实例都加锁成功,才算真正拿到锁,这样即使个别实例宕机,只要多数存活,锁的安全性就能保证,不过这个算法实现起来复杂一些,而且也有争议,但确实是应对这种场景的一种主流方案。

除了这些大坑,还有一些细节也很磨人。网络延迟和GC停顿,你的应用服务器和Redis服务器之间网络稍微抖一下,一个命令可能就延迟了几百毫秒,这可能会让客户端误判锁的状态,还有,如果你的Java应用突然发生了一次Full GC,整个应用线程都停摆了,可能一停就是好几秒,这期间,锁超时了,应用恢复后还以为自己拿着锁,继续操作共享资源,同样会出问题,再有就是错误地使用相同的锁key,或者忘记释放锁,有时候代码逻辑复杂,在if-else或者异常处理分支里忘了写释放锁的代码,导致锁永远无法释放,形成死锁,后续所有请求都失败,必须得用try-finally语句块把释放锁的逻辑包起来,确保万无一失。

所以你看,一个小小的Redis锁,从设置超时时间,到确保原子性操作(比如判断锁归属和删除要作为一个原子操作执行,可以用Lua脚本),再到应对集群环境下的高可用挑战,每一步都有讲究,搞明白了这些,再回头看之前那些失败,就不是单纯的“运气不好”了,而是背后有深刻的技术原因,解决这些问题,需要我们更细致地配置参数,更严谨地编写代码,甚至在复杂场景下考虑更高级的分布式锁方案,虽然过程挺让人头大的,但把这些坑都踩过一遍之后,自己对分布式协调的理解也确实深了不少。

本文由寇乐童于2026-01-05发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/74908.html