树叶云里用Go搞gRPC开发那些事儿,边学边写边踩坑总结

- 问答

- 2026-01-08 06:48:50

- 9

树叶云里用Go搞gRPC开发那些事儿,边学边写边踩坑总结

这事儿得从头说起,我们团队,也就是“树叶云”,当时决定用Go语言来构建新的微服务,通信协议就选了gRPC,为啥选它?官方说法是性能高、跨语言、IDL定义清晰,说人话就是,感觉挺时髦,而且据说以后跟别的系统对接会省事儿,但这一路下来,可谓是“边学边写边踩坑”,坑还真不少。

第一关:从.proto文件开始就懵了

(来源:团队内部初期讨论记录)一开始,大家对着.proto文件语法发愣,虽然文档说很简单,但定义个消息类型,是该用int32还是int64?字段编号为什么必须从1开始,还不能重复?optional、repeated这些关键字啥时候用?有个同事没注意,把两个字段都标成了编号1,结果编译的时候直接报错,查了半天才找到这个低级错误,这才明白,这文件就像是双方的合同,一点都马虎不得,写错了后面全乱套。

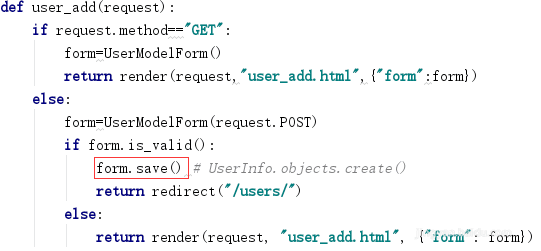

第二关:Go代码生成了,然后呢?

(来源:项目第一个gRPC服务编写过程)用protoc命令加上Go的插件,生成了那一大坨.pb.go文件,看着里面自动生成的struct和接口,感觉成功了一半,但接下来就傻眼了:生成了服务端的接口,需要我们自己去实现具体的业务逻辑,生成了一个UserServiceServer接口,里面有个GetUser方法,我们就得创建一个结构体,然后老老实实把这个方法实现了,在里面去查数据库,然后把查到的数据塞到响应消息里,一开始有人试图直接修改生成的.pb.go文件,立刻被同事喝止了,说这文件是“神圣不可侵犯”的,改了下次一编译就全没了,这才养成只动自己写的实现文件的习惯。

第三关:连接池这个大坑

(来源:压测性能上不去的事故分析)本地测试好好的,一上压测,服务动不动就超时或者报错,排查了好久,才发现是gRPC连接的问题,我们一开始图省事,每次要调用另一个服务时,都临时创建一个新的gRPC连接,结果压测一上来,瞬间建立成百上千个连接,把资源耗尽了,而且频繁创建销毁开销巨大。(来源:后续优化方案文档)后来才知道,gRPC连接是支持多路复用的,一个连接可以同时处理多个请求,必须用连接池来管理,长时间保持一定数量的活跃连接,我们用了开源的一个连接池库,问题才解决,这个坑让我们明白,微服务通信不是简单的调个方法就行,底层的网络资源管理至关重要。

第四关:错误处理不像想得那么简单

(来源:线上错误码混乱的教训)一开始,我们在gRPC的响应消息里自己定义了一个code和msg字段来传递错误,结果发现,每个服务返回的code含义都不一样,非常混乱,后来才深入研究gRPC内置的status包,它提供了一套标准的错误码(比如NotFound、InvalidArgument等),可以通过status.New(codes.NotFound, "user not found").Err()来生成错误,在客户端也能很方便地解析出来,统一之后,错误处理逻辑清晰多了,但这里也有个小坑,Go的gRPC默认会把服务端返回的错误转换成HTTP/2的trailer,有些初级客户端可能没正确处理trailer,导致看不到错误详情,这个在联调时也费了些功夫。

第五关:调试和日志,眼睛要看瞎了

(来源:排查一次数据不一致问题的心得)gRPC通信是二进制的,不像HTTP请求那样可以直接在浏览器开发者工具或者用curl看一眼,出了问题,比如请求参数不对或者返回结果不对,日志打得不够的话,简直抓瞎,我们后来强制要求,在每个gRPC方法的入口和出口,都必须用结构化的方式打印请求和响应的核心字段(注意脱敏),并且记录一个唯一的请求ID,这样整个调用链都能串起来,也尝试过一些拦截器(Interceptor)来自动化记录日志和指标,但拦截器的配置和使用本身又是另一个需要学习的小知识点。

总结一下

在树叶云用Go搞gRPC,就是一个不断学习和填坑的过程,从最初的.proto文件语法,到代码生成、连接管理、错误处理、调试技巧,每一步都有需要注意的细节,它确实带来了性能和维护性上的好处,但前提是你得把这些“坑”都趟平了,没有什么银弹,扎实地理解其原理,加上充分的测试和良好的编程习惯,才是让gRPC真正发挥威力的关键,我们现在也还在继续摸索,比如服务发现、负载均衡、链路追踪这些更高级的话题,估计前面还有新的“惊喜”在等着我们。

本文由太叔访天于2026-01-08发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/76665.html