数据库和Redis怎么一起搞复杂事务,实际操作和注意点分享

- 问答

- 2026-01-24 20:00:30

- 2

关于数据库和Redis一起处理复杂事务的实际操作和注意点,结合多个开发者的实践经验,可以分享以下内容:

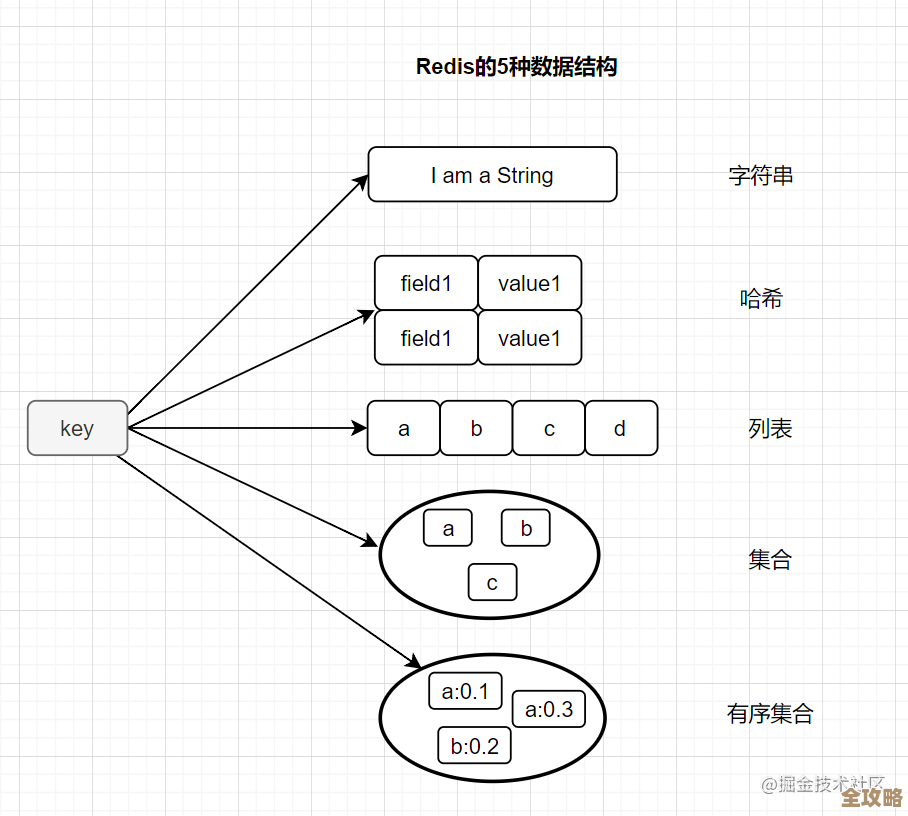

核心思想:Redis通常不作为可靠事务的参与者,而是作为辅助缓存或异步同步的目标。 复杂事务的核心保证必须依赖数据库本身的事务机制,根据知乎多位技术分享者(如“程序员小灰”、“阿里云开发者”)的总结,常见做法和注意点如下:

主要操作模式

-

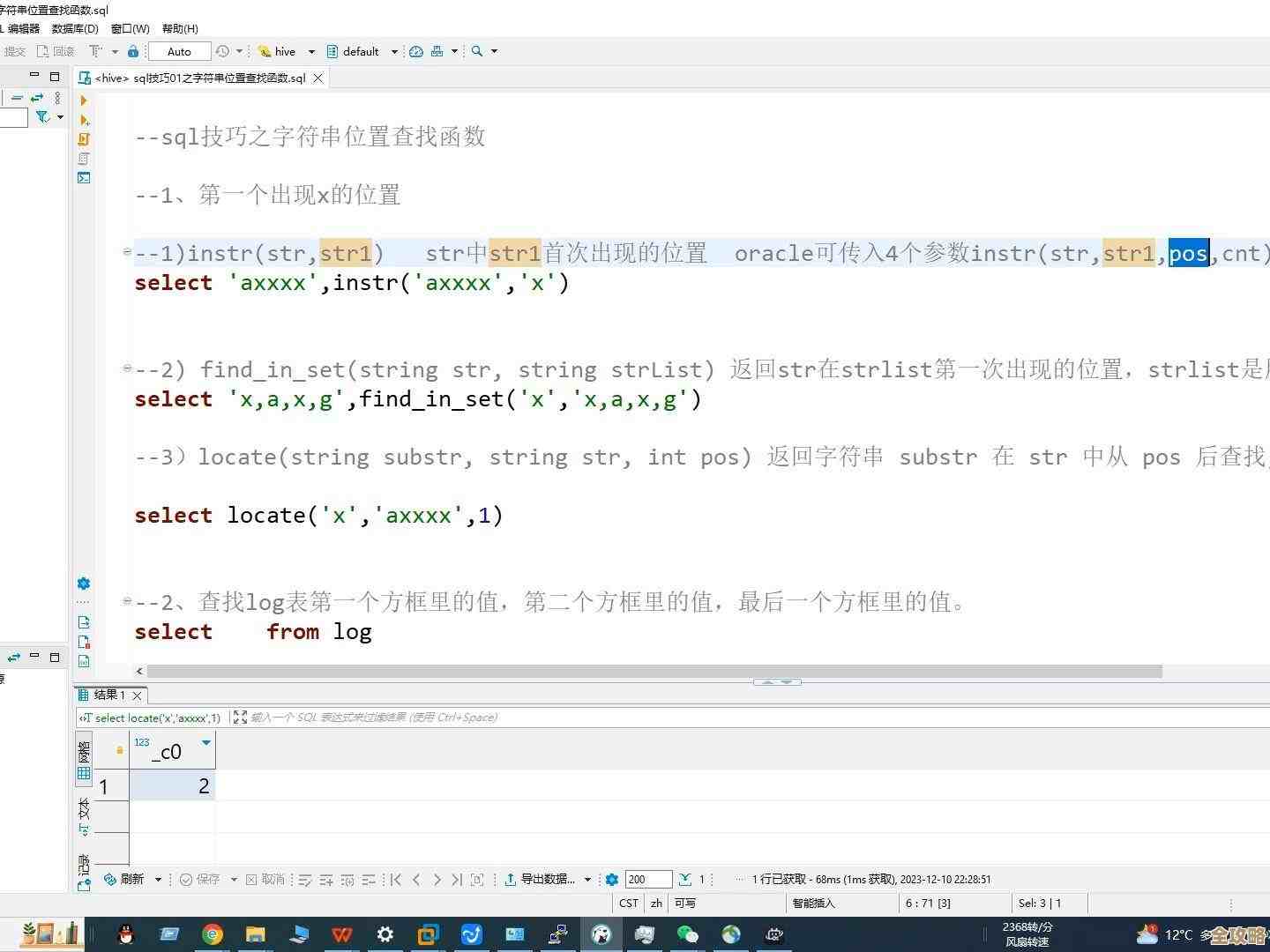

先写数据库,再让缓存失效(最常用):这是被广泛推崇的模式,具体步骤是:首先在数据库事务内完成所有数据变更,提交事务成功后,再执行删除Redis中相关缓存的操作,这样做的好处是,即使缓存删除失败,也只会导致一段时间的缓存数据滞后(下次读取时会从数据库加载最新数据并重新缓存),而不会造成数据库与缓存之间的永久性数据不一致。(来源:多位知乎技术答主在缓存一致性讨论中的共识)

-

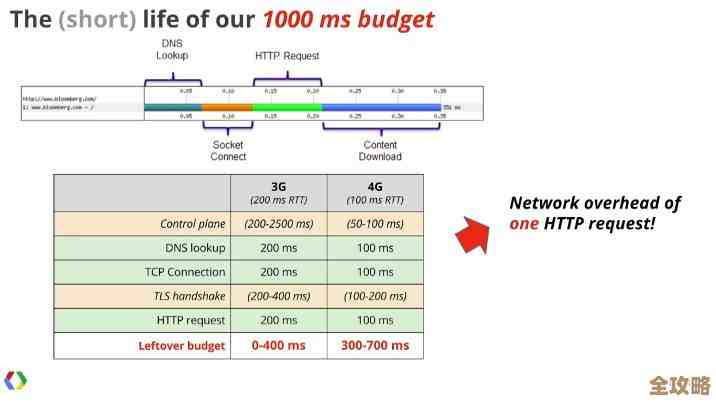

使用消息队列异步更新:对于数据一致性要求允许短暂延迟的场景,可以在数据库事务提交后,发送一个消息到消息队列(如Kafka、RocketMQ),然后由一个独立的消费者服务接收消息,负责更新或失效Redis缓存,这种方式将数据库事务与缓存操作解耦,避免了在业务事务中直接操作Redis失败带来的回滚复杂性,也提升了系统整体的吞吐量。(来源:掘金社区《高并发系统缓存架构设计》系列文章)

-

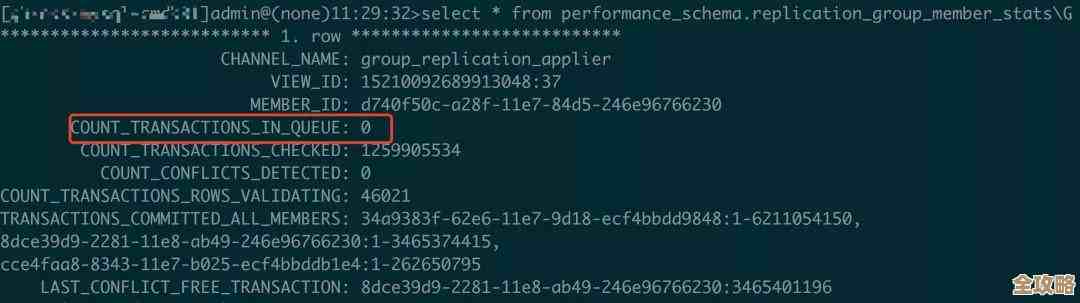

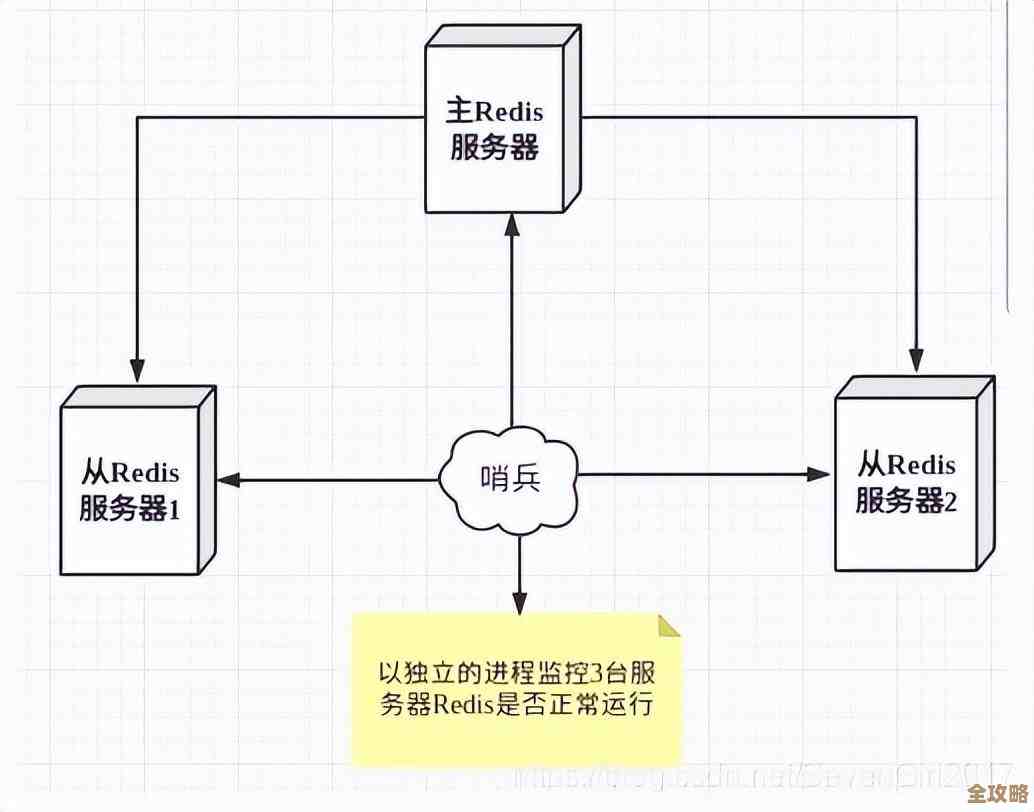

通过数据库事务日志(Binlog)同步:这是实现最终一致性的一种更彻底的方式,使用阿里开源的Canal等工具,伪装成数据库的从库,监听数据库的Binlog变化,当感知到业务事务提交的数据变更后,由Canal客户端解析日志,并更新到Redis,这种方式对业务代码完全无侵入,保证了Redis与数据库的严格最终一致,但架构复杂,延迟稍高。(来源:阿里云开发者社区关于Canal应用的案例分享)

关键注意事项与“坑点”

-

绝对避免“先更新缓存,再写数据库”:这个顺序非常危险,如果缓存更新成功但数据库写入失败,或者数据库主从同步延迟,会导致缓存中是“或错误的数据,且持久化失败,业务逻辑会混乱。

-

“双写”模式下的并发问题:如果你不得不同步写数据库和Redis(非失效模式),在高并发下会面临经典的数据不一致窗口,A线程写数据库(旧值)-> B线程写数据库(新值)-> B线程写缓存(新值)-> A线程写缓存(旧值),最终缓存是脏的旧数据,解决此问题需要引入分布式锁,但会极大降低性能,因此通常不推荐。

-

缓存失效失败的重试与补偿:在“先写库再删缓存”模式中,删除缓存可能因网络问题失败,必须要有重试机制,可以设置一个重试队列,将失败的删除操作放入,由后台任务定期重试,更高级的做法是结合上述的Binlog监听,作为最终的补偿核对机制。

-

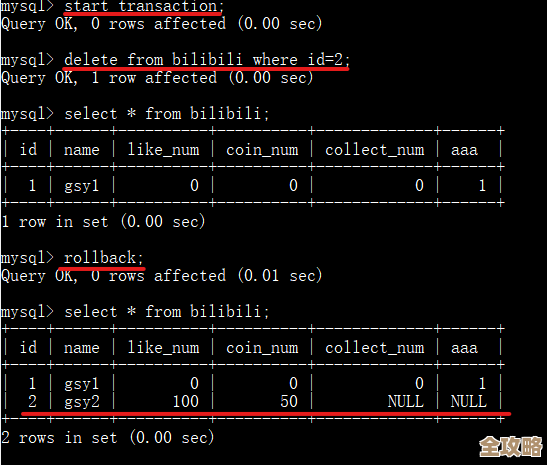

注意事务隔离级别与缓存读取的时机:如果你的数据库事务隔离级别不是“读已提交”或更高,且在事务未提交时就去读取数据并刷新缓存,可能会把未提交的“脏数据”刷入Redis,如果数据库事务回滚,缓存数据就完全错误了。(来源:知乎问题“如何保证数据库和缓存一致性”下某回答的深度讨论)

-

缓存操作不是事务的一部分:务必清醒认识到,除非使用极其复杂的分布式事务框架(如Seata的TCC模式,但性能损耗大),否则Redis操作无法与MySQL等数据库事务真正形成原子性,你的代码设计必须假设“数据库事务成功”和“缓存更新成功”是两个独立的过程,并为此设计好容错和补偿逻辑。

-

为缓存设置合理的过期时间:这是最后一道安全网,即使所有的更新/失效逻辑都失败了,给缓存数据设置一个合理的过期时间(TTL),可以确保在一段时间后自动过期,从而迫使系统从数据库读取最新数据,这是一种保证最终一致性的简单有效手段。

实际操作中,优先选择“先写数据库,再失效缓存”这一简单有效的模式,并配套重试机制,对于一致性要求极高且能接受架构复杂性的场景,可以考虑基于Binlog的同步方案,最关键的是,要在设计上接受缓存与数据库的短暂不一致,并通过技术手段将不一致的窗口期降到最低,而不是强求实时的绝对一致,后者在分布式环境下代价过高。

本文由称怜于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/85284.html