Redis里头那些二进制数据到底咋清理才靠谱,有啥注意的地方没

- 问答

- 2026-01-13 05:49:19

- 4

说到清理Redis里的二进制数据,比如图片、文件切片、序列化后的对象这些,可不能像删普通字符串key那样随手一个DEL就了事,这东西处理不好,轻则服务卡顿,重则直接搞挂Redis,数据还可能删不干净,咱们就掰开揉碎了说说这里头的门道和注意事项。

核心问题:二进制数据为啥“难搞”?

首先得明白,二进制数据通常意味着“大”,一个文本key可能就几KB,但一张图片、一个文档可能动辄几MB甚至几十MB,Redis是单线程模型的,它处理命令是一个接一个来的,当你直接对一个存储了几MB数据的key使用DEL命令时,Redis主线程需要分配一大块连续内存来释放这个对象,这个操作会阻塞住整个服务器,在这期间,其他所有进来的读写命令都得干等着,导致请求延迟飙升,用户体验到的就是“卡死了”,如果同时有多个这种大key被删除,Redis甚至可能因为瞬间内存压力过大而直接宕机。(来源:Redis官方文档关于内存优化的说明)

靠谱的清理方法是什么?

对付大key,尤其是二进制数据这种典型的大key,核心思路就一条:化整为零,异步删除,避免在主线程里进行大规模的内存释放操作。

-

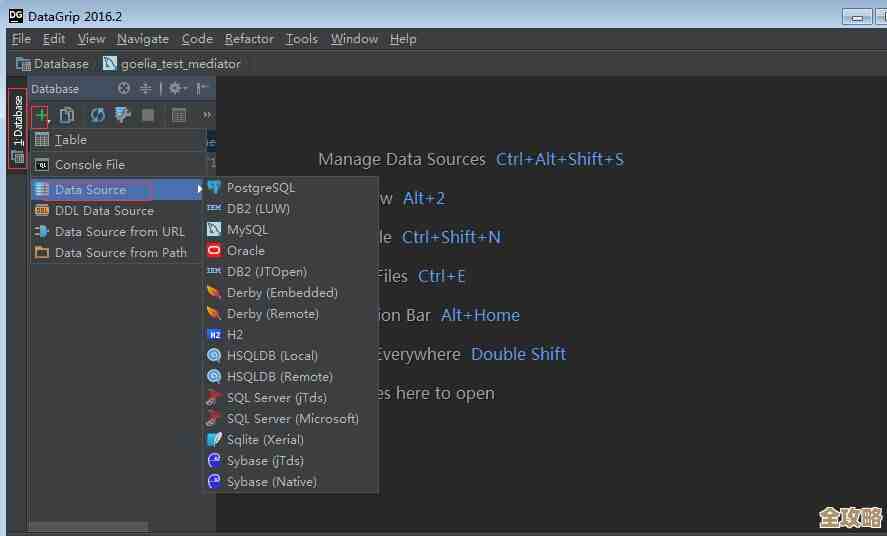

首选方案:UNLINK命令 这是Redis 4.0版本之后提供的“安心”删除命令,你可以把它理解为

DEL的异步友好版,当你执行UNLINK key_name时,Redis并不会立刻、在主线程里释放这个key占用的内存,它只是先把key从键空间里“摘除”,让其他客户端无法再访问到,然后把这个真正的删除释放内存的脏活累活,丢给后台的另一个线程去慢慢处理。(来源:Redis 4.0 release notes中关于UNLINK命令的介绍)这样,主线程就能继续高高兴兴地服务其他请求,几乎不会产生明显的延迟,只要你的Redis版本是4.0以上,清理任何你觉得可能比较大的key,都应该养成习惯用UNLINK代替DEL。

-

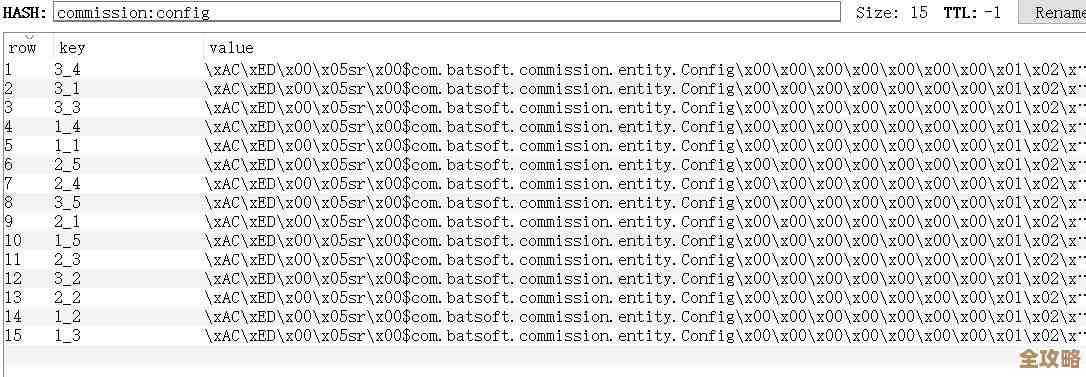

对于超大规模键的扫描与分批删除 情况更复杂一些,你可能不是要删一两个明确的大key,而是需要根据某种模式(pattern)清理一大批key,而这些key里可能混杂着很多存储二进制数据的大key,你想清理所有以

user_avatar:开头的用户头像缓存。- 错误做法:使用

KEYS user_avatar:*命令先找出所有key,然后再一个个删。KEYS命令在生产环境是绝对禁止的,因为它会一次性遍历整个数据库的所有key,在数据量大的时候会直接卡死Redis。 - 正确做法:使用

SCAN命令。SCAN是一个游标迭代器,它每次只返回一小部分key,不会阻塞服务器,你可以写一个脚本,用SCAN命令逐步、分批地找出所有匹配的key,对于每一批找出来的key,不要立刻逐个DEL,而是应该使用UNLINK命令,并且可以一次传递多个key,比如UNLINK key1 key2 key3 ...,这种管道化(pipelining)操作能进一步提高效率,减少网络往返开销。(来源:Redis官方文档对SCAN命令的说明以及对于延迟的优化建议)

- 错误做法:使用

-

针对特定数据结构的特殊技巧 如果你的二进制数据不是简单地存成一个字符串,而是用了Hash、Set、Sorted Set或List这种复杂数据结构,并且这个结构非常庞大(比如一个Hash里有成千上万个字段,每个字段值都是一个二进制块),那删除起来更要小心,除了用上面的

UNLINK整体删除外,如果只是想清理其中的一部分数据,Redis为这些大型数据结构也提供了渐进式删除命令:- HASH:可以使用

HSCAN和HDEL配合,分批删除字段。 - SET:使用

SSCAN和SREM配合。 - Sorted Set:使用

ZSCAN和ZREM配合。 - List:直接使用

LTRIM命令逐步修剪列表,从尾部一点点截断。 这些方法的核心思想都是一样的:避免单次操作的数据量过大。

- HASH:可以使用

清理前后必须注意的地方

光知道怎么删还不够,下面这些坑点不注意,照样可能出问题:

-

清理前务必确认!务必确认!务必确认! 二进制数据很可能关联着重要的用户文件或业务数据,在执行清理脚本前,一定要双重甚至三重确认你的匹配模式是否正确,是否误伤了不该删的数据,最好先在测试环境跑通流程,有条件的话,对重要数据设置适当的TTL(过期时间)让其自动过期,比手动删除更安全。

-

关注内存碎片和内存回收:即使你用了

UNLINK,内存也不是立刻释放的,Redis的内存分配器可能会产生内存碎片,尤其是在频繁写入和删除大块数据的情况下,碎片率可能会很高,你可以通过INFO memory命令监控mem_fragmentation_ratio这个指标,如果比值过高(比如长期大于1.5),可能会造成实际物理内存已耗尽但Redis认为内存不足的尴尬局面,这时候可能需要进行重启,或者使用Redis 4.0以上的MEMORY PURGE命令(如果支持的话)来尝试清理碎片。(来源:Redis官方文档关于内存优化的章节) -

设置合理的最大内存和淘汰策略:绝对不能任由Redis使用所有服务器内存,一定要在配置文件中使用

maxmemory参数设置一个上限,设置一个合适的maxmemory-policy(内存淘汰策略),比如allkeys-lru或volatile-lru,这样当内存接近上限时,Redis会自动按照策略淘汰一些key,给你一个缓冲地带,避免内存爆满导致写入失败或者更严重的问题,这在误操作写入超大数据时能起到保护作用。 -

监控删除时的性能指标:在执行大规模清理期间,密切监控Redis服务器的几个关键指标:CPU使用率、内存使用量、网络输出流量(因为

SCAN操作会增加网络流量),以及最重要的——延迟时间,如果发现延迟有明显上升,可能需要放慢你清理脚本的执行速度,比如在每批删除之间增加一个短暂的休眠时间。

清理Redis里的二进制数据,核心就是“温柔”二字,用UNLINK代替DEL,用SCAN代替KEYS,分批分次,异步操作,像一名谨慎的外科医生一样,术前确认病灶,术中监控生命体征,术后关注恢复情况,这样才能在保证Redis服务高可用的前提下,安全有效地完成数据清理工作。

本文由凤伟才于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/79752.html