分布式架构怎么帮Redis提速,实际用起来那些坑和窍门

- 问答

- 2026-01-12 22:55:18

- 1

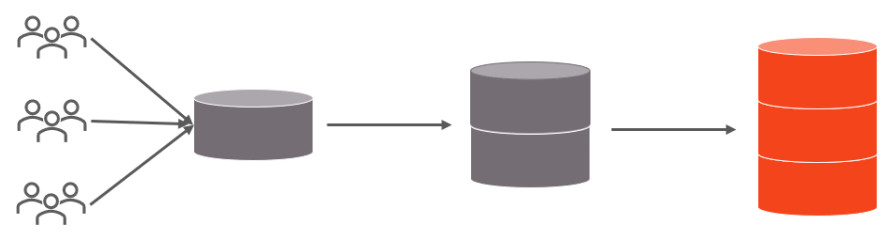

分布式架构提升Redis速度,核心思路就一句话:把巨大的压力和庞大的数据分摊到多台机器上,让大家一起扛,这就像一个人搬不动的石头,找几个人一起抬就轻松多了,具体怎么“分摊”,主要有两种主流玩法:主从复制和分片集群。

主从复制:读写分离,主库写,从库读 这种模式很简单,你指定一台Redis服务器作为“主库”,它主要负责处理写操作(比如新增、修改数据),你可以挂上好几台“从库”,主库会把写入的数据实时同步给这些从库,这样一来,所有读的请求(比如查询数据)就可以直接交给从库去做了。

- 提速原理:这直接减轻了主库的压力,在大多数业务里,读请求的量远远大于写请求,通过增加从库的数量,读请求的处理能力几乎可以线性增长,对于用户来说,最直观的感受就是网站或APP的查询、加载速度变快了。

- 实际用起来的坑:

- 数据不一致的延迟:这是最常见的问题,主库的数据同步到从库,哪怕再快,也有一个极短的时间差(毫秒级),如果你刚在主库写完,立刻去从库读,可能会读到旧数据,这在一些对数据一致性要求极高的金融场景下是致命的,用这招的前提是业务能容忍短暂的数据不一致。

- 主库依然是单点:写操作的压力还是集中在主库一台机器上,如果写操作非常频繁,主库还是会成为瓶颈,如果主库宕机了,虽然可以手动把某个从库升级成主库,但这个过程中服务是会中断的。

分片集群:把大数据拆开,分而治之 当你的数据量巨大,一台机器的内存根本装不下时,主从复制就不好使了,这时就要用分片集群,它的思想是把整个数据集合切成很多个小块,每个小块存储在不同的Redis服务器(称为分片)上。

- 提速原理:首先是解决了单机内存限制,数据可以无限扩展,读写请求也会被分散到不同的分片上,由多台机器同时处理,整体吞吐量得到巨大提升,这就像一个有多个收银台的超市,比只有一个收银台的超市结账速度快得多。

- 实际用起来的坑和窍门:

- 分片规则是命门:怎么决定一条数据该存到哪个分片上?通常是用Redis的key的一部分来计算一个哈希值,然后根据哈希值分配,这里最大的坑是,如果你一开始分了3个片,后来数据增长需要加到4个片,那么大部分key的哈希值取模后会发生变化,导致数据需要大规模重新迁移,这个过程非常痛苦,搞不好会停机,解决办法是采用一种叫“一致性哈希”的算法,它能在扩缩容时只影响一小部分数据,但实现起来更复杂,这是架构设计初期就必须慎重考虑的。

- 不支持多key操作:这是分片集群的一个巨大限制,像集合求交集(SINTER)、同时获取多个key(MGET)这样的操作,如果这些key恰好被分到了不同的服务器上,那就无法执行了,你必须改变业务设计,比如把有关联的数据通过相同的部分放在同一个key下,或者保证它们通过分片规则能落到同一台机器上。

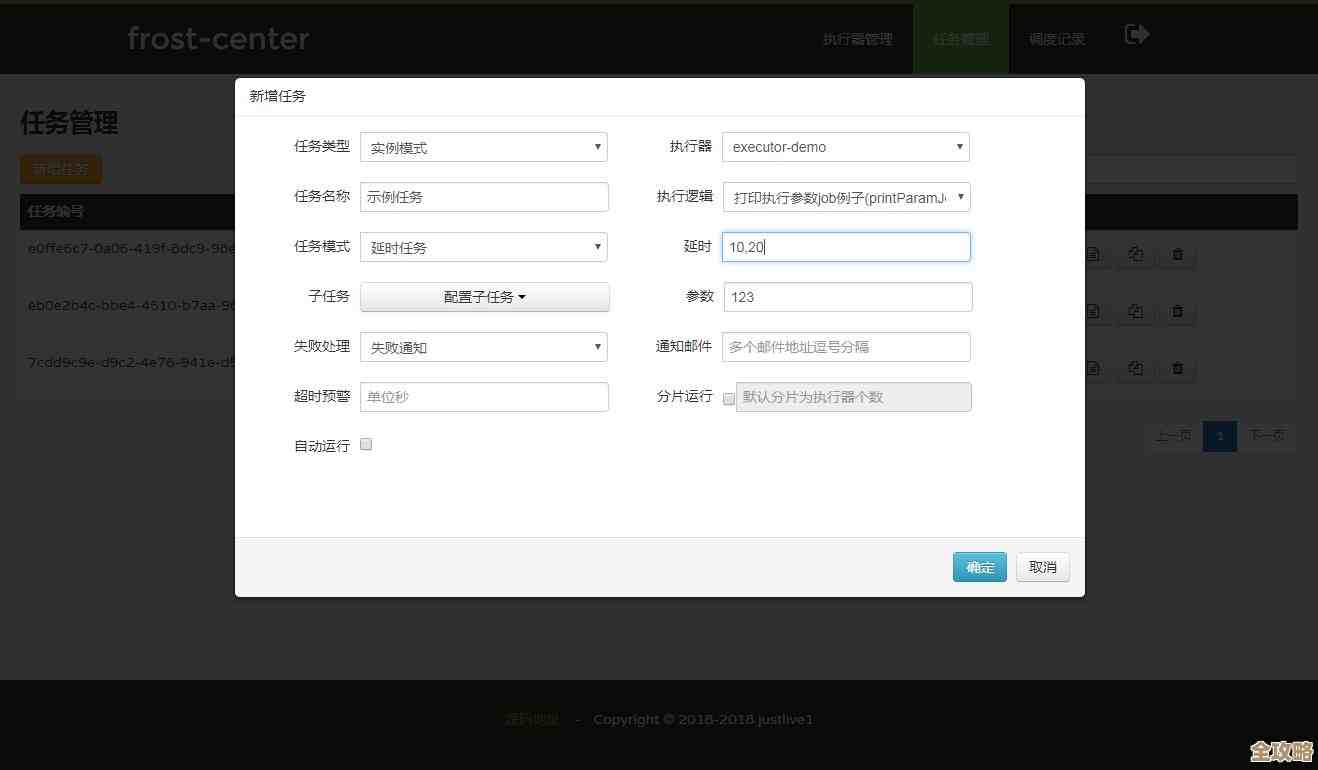

- 运维复杂度飙升:管理一个由几十上百个节点组成的集群,和管一个单机Redis完全是两回事,监控、备份、故障恢复的难度都呈指数级上升,你需要成熟的运维工具和团队。

一些通用的窍门和提醒:

- 监控是眼睛:无论用哪种架构,都必须有完善的监控,要时刻关注每个节点的CPU、内存、网络流量和延迟,很多问题在爆发前都是有征兆的。

- 慢查询日志是宝藏:Redis自带慢查询日志功能,一定要开启并定期分析,很多时候性能瓶颈不是架构问题,而是一条写得非常糟糕的SQL命令(比如一次性获取一个包含几万元素的集合),优化一条命令,可能比加十台服务器还有效。

- 客户端缓存是神助攻:在分布式Redis前面,还可以在应用服务器本地加一层缓存(比如Guava Cache、Ehcache),把最热的数据存在本地,这样连网络请求都省了,速度最快,但要注意本地缓存和Redis之间的数据一致性问题。

- 别把Redis当数据库:虽然Redis性能很强,但它本质上还是一个缓存,设计上要假设它随时可能崩溃,数据可能丢失,重要数据一定要有后端数据库(如MySQL)作为备份和持久化存储。

分布式架构是解决Redis性能和容量瓶颈的必由之路,但它不是银弹,是用更高的架构和运维复杂度换来的,选择主从还是分片,取决于你的业务场景是“读多写少”还是“数据海量”,在实际用起来的时候,一定要把上面提到的那些“坑”提前考虑到设计中,才能让它真正为你提速,而不是添乱。

引用来源:本文内容综合自《Redis设计与实现》、Redis官方文档以及多位资深运维工程师(如阿里云、腾讯云的社区专家)的实践经验分享。

本文由芮以莲于2026-01-12发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/79579.html