Kafka Connect用来同步RDS的binlog数据,具体咋操作和实现原理是啥?

- 问答

- 2026-01-10 21:13:43

- 7

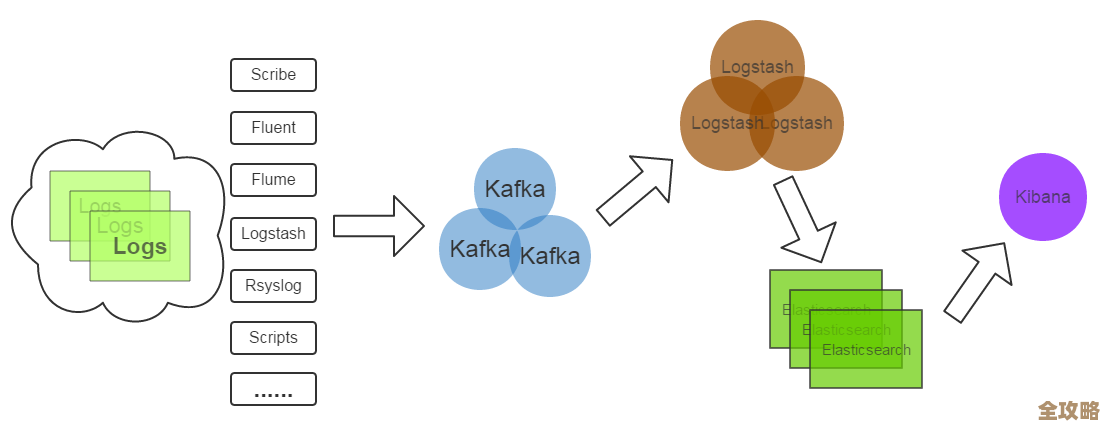

要理解Kafka Connect如何同步RDS的binlog数据,我们可以把它想象成一个高效且自动化的“数据搬运工”,这个搬运工不是去数据库里不停地敲门问“你有新数据吗?”,而是直接蹲在数据库的“流水账”(也就是binlog)旁边,实时抄录每一条变动记录,然后原封不动地转交给Kafka,下面我们分两步说:先讲它是怎么干活的(操作),再讲它为什么能这么干(原理)。

具体操作步骤

根据Debezium官方文档、AWS官方文档以及相关技术博客的普遍描述,操作流程可以概括为以下几个关键环节:

-

前期准备:配置数据库 源头MySQL或PostgreSQL等RDS实例需要提前做好设置,以便产生并允许读取binlog,这就像是为“搬运工”打开进入仓库的大门和准备好记录本,关键步骤包括:

- 开启binlog:确保RDS实例的参数组中,与binlog相关的参数(如

binlog_format设置为ROW,binlog_row_image设置为FULL)是正确配置的,大多数云厂商的RDS默认已开启,但需要确认。 - 创建专用账号:为了安全,需要创建一个专门用于数据同步的数据库账号,这个账号需要授予特定的权限,比如

REPLICATION SLAVE和REPLICATION CLIENT(对于MySQL),或者具有读取复制槽的权限(对于PostgreSQL),这样,Kafka Connect才能以“从库”的身份去拉取binlog。

- 开启binlog:确保RDS实例的参数组中,与binlog相关的参数(如

-

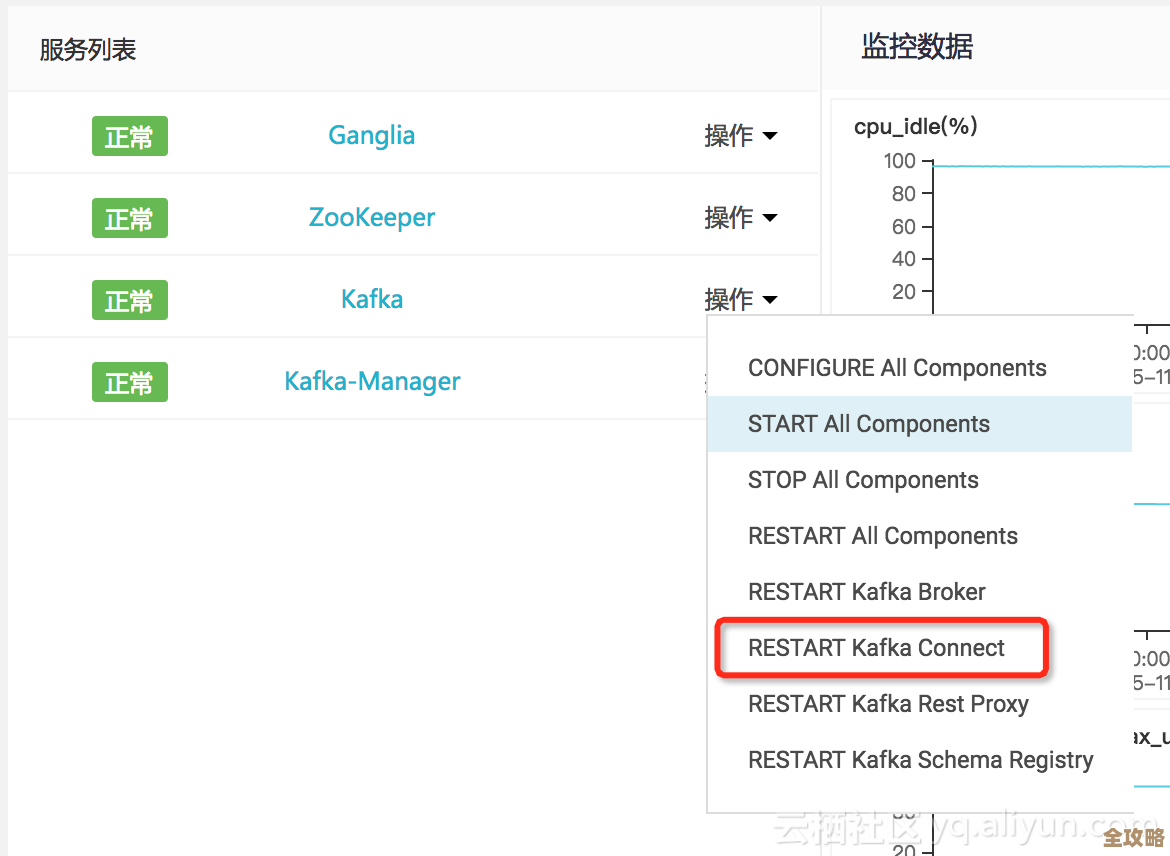

部署与配置Kafka Connect Kafka Connect通常以分布式模式运行,这样可以实现高可用和扩展性,之后,你需要部署一个叫做Debezium的源连接器(Source Connector),Debezium是一个开源项目,它专门扮演这个“binlog搬运工”的角色,并被设计成Kafka Connect的一个插件。

- 安装Debezium连接器:将Debezium连接器的插件文件(例如

debezium-connector-mysql或debezium-connector-postgres)放入Kafka Connect工作节点的插件目录下,然后重启Connect服务使其识别。 - 提交连接器配置:通过Kafka Connect提供的REST API接口,提交一个JSON格式的配置文件来创建一个新的连接器任务,这个配置文件是这个操作的核心,它告诉Debezium所有必要的细节:

connector.class:指定使用哪个连接器,比如io.debezium.connector.mysql.MySqlConnector。database.hostname&database.port:RDS实例的地址和端口。database.user&database.password:第一步创建的专用账号和密码。database.server.id:一个唯一的数字ID,模拟一个MySQL从库的身份。database.server.name:为你同步的这套数据库起一个逻辑名称,比如rds-inventory-server,这个名称会作为Kafka主题名前缀的一部分,非常重要。table.include.list:指定要同步哪些表,例如"inventory.products,inventory.orders",如果不指定,默认会同步所有表。database.history:这是一个关键配置,Debezium需要知道表的初始结构(Schema)来解析binlog中的数据,它会将Schema信息存储在一个指定的Kafka主题(通常是<server.name>.history)中,以便在连接器重启后能快速恢复状态。

- 安装Debezium连接器:将Debezium连接器的插件文件(例如

-

启动与监控 配置提交后,Kafka Connect就会启动这个连接器任务,它会先执行一个初始快照(Initial Snapshot)操作,也就是将数据库中现有表的全部数据一次性导入到Kafka相应的主题中,这个过程类似于给数据库拍一张完整的照片作为起点,快照完成后,连接器就会自动切换到增量同步模式,开始实时监听binlog的变更,你可以在Kafka中看到,每个被监控的数据表都会对应生成一个主题(主题名通常类似

<database.server.name>.<database名>.<表名>),里面的消息就是数据的插入、更新、删除事件。

实现原理

根据Debezium官方文档对其架构和MySQL连接器的深入解释,其核心原理可以概括为“伪装从库,解析流水账”。

-

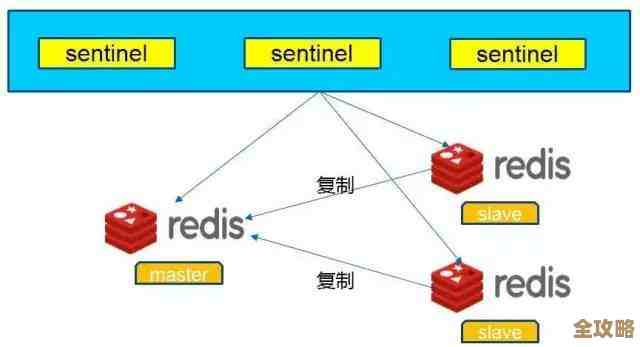

基于数据库复制协议 以MySQL为例,Debezium连接器在启动时,会使用你配置的账号信息,向RDS MySQL实例发起一个复制协议请求,这个过程,完全模拟了一个MySQL从库(Slave)向主库(Master)发起的同步请求,RDS实例会将其识别为一个新的“从库”,并开始向这个连接器推送binlog事件流,这就建立了数据同步的底层通道。

-

解析Binlog事件 Binlog本身是二进制的,人类和Kafka都无法直接读懂,Debezium连接器的核心能力在于,它内置了解析器,能够读懂MySQL、PostgreSQL等数据库特定格式的binlog,连接器会持续地从建立的复制流中读取binlog事件,然后将其解析成一个个结构化的变更事件,这些事件包含了丰富的信息:是INSERT(插入)、UPDATE(更新)还是DELETE(删除)操作;操作发生的时间戳;操作所在的数据行在变更前(before)和变更后(after)的所有字段值。

-

转换为CDC事件并发送到Kafka 解析出结构化的数据变更后,Debezium会将这些信息封装成一个通用的变更数据捕获(CDC)事件,这个事件通常是一个JSON或Avro格式的消息,其内容大致包括:

op:操作类型,如c(create/insert)、u(update)、d(delete)。before:数据行变更前的状态(update和delete操作有值)。after:数据行变更后的状态(insert和update操作有值)。source:元数据,包括数据库名、表名、事务ID、binlog位置等。 连接器会将这些CDC事件作为消息,发送到对应的Kafka主题中,每个表的变化都会进入自己专属的主题,方便下游系统订阅和处理。

-

断点续传与一致性保障 为了保证数据不丢失、不重复,连接器会定期地将当前已经成功处理到的binlog位置(例如MySQL的binlog文件名和偏移量)作为一个“偏移量”记录在Kafka的一个内部主题(

connect-offsets)中,如果连接器因为任何原因重启,它可以从这个记录的位置继续拉取binlog,从而实现断点续传,保证数据的最终一致性。

Kafka Connect(借助Debezium这类连接器)同步RDS binlog的本质,就是巧妙地利用数据库自身的复制机制,以一个无害的“从库”身份,实时地、低延迟地捕获数据的所有变更,并将其转换成易于流式处理的消息,为构建实时数据管道和数据集成提供了坚实的基础。

本文由符海莹于2026-01-10发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/78290.html