控制Redis连接数到底怎么影响性能,连接数多大合适才不会卡顿?

- 问答

- 2026-01-10 18:25:38

- 4

关于Redis连接数如何影响性能以及设置多少连接数合适才不会导致卡顿,这是一个非常实际且重要的问题,要理解清楚,我们得先抛开复杂的专业术语,用一个简单的比喻来切入,你可以把Redis服务器想象成一家只有一个服务员的网红小餐馆,而应用程序建立的每一个Redis连接,就相当于一位在餐馆门口排队的顾客。

第一部分:连接数如何影响性能?就像餐馆排队一样

刚开始,餐馆门口只有零星几位顾客(连接数很少),服务员(Redis主线程)可以非常高效地处理每一位顾客的点单请求(客户端命令),他迅速地在后厨(内存数据库)和前台之间穿梭,顾客几乎感觉不到等待,这时,餐馆的吞吐量(每秒处理的命令数)很高,响应时间(延迟)很低,一切都很顺畅。

随着生意变好,排队的人(并发连接数)逐渐多了起来,如果人数在服务员能承受的范围内,他依然能保持不错的效率,但问题在于,Redis这个“服务员”有一个关键特点:它是单线程处理命令的(注:这里指处理核心读写命令的线程是单线程,Redis 6.0之后引入了多线程IO,但命令执行本身仍是单线程串行化的),这意味着,无论门口排了多少人,服务员一次只能服务一位顾客,为他点完单、上好菜,才能服务下一位。

让我们看看连接数过多会引发哪些具体问题,也就是“卡顿”是怎么发生的:

-

CPU资源竞争加剧(服务员忙到晕头转向):每个活跃的连接,即使它没有发送命令,也需要服务器花费极少的CPU资源来维护其状态(检查它是否还“活着”,即心跳检测),当连接数成千上万时,这“极少”的资源累加起来就非常可观了,更重要的是,大量的连接意味着海量的命令请求涌向那个单线程的“服务员”,线程需要不断地在不同的连接之间进行切换,检查哪个连接有数据来了、要处理什么命令,这种频繁的上下文切换本身就会消耗大量CPU时间,根据Oracle官方JVM性能调优指南(其中也涉及服务器资源管理的基本原理)中的描述,过多的线程(类比于此处的连接)会导致显著的上下文切换开销,使得CPU把宝贵的时间花在“调度”上,而不是真正“干活”上,结果就是,CPU利用率看似很高,但实际处理命令的效率却下降了,响应时间变长。

-

内存消耗暴涨(餐桌和菜单不够用了):在Redis服务器端,每一个连接都需要占用一定的内存来存储其相关信息,比如连接上下文、缓冲区等,根据Redis官方文档的说明,每个连接大约需要消耗几KB到十几KB的内存,听起来不多?那我们来算笔账:1万个连接就可能轻松占用超过100MB的内存,这些内存本可以用来存储更多的业务数据(键值对),现在却被用来“养”这些连接本身了,当物理内存不足时,系统可能会开始使用Swap空间(硬盘模拟的内存),这会导致性能急剧下降,产生严重卡顿。

-

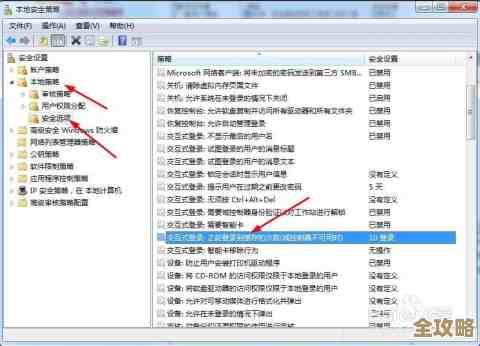

网络瓶颈与文件描述符耗尽(餐馆门口堵死了):操作系统对于单个进程能同时打开的网络连接数量是有限制的,这个限制就是“文件描述符上限”,如果应用程序创建的连接数超过了这个上限,新的连接就无法建立,会收到“Cannot assign requested address”或“Too many open files”这类错误,即使没有达到上限,数万个连接同时存在,也会给操作系统的网络栈带来巨大压力,可能引发网络延迟和丢包。

-

慢查询的连锁反应(遇到一个磨蹭的顾客):假设某个连接执行了一个非常耗时的命令(比如对一个包含百万元素的集合执行

KEYS *操作,或者一个复杂的Lua脚本),由于Redis是单线程模型,这个慢查询会“阻塞”整个线程,在此期间,所有其他连接的命令都必须等待这个慢查询完成才能被处理,连接数越多,出现慢查询的概率就越大,一旦出现,受影响的连接数也越多,造成的“卡顿”感就越发明显。

第二部分:连接数多大合适才不会卡顿?

这是一个没有标准答案的“黄金问题”,因为它完全取决于你的具体业务场景,但我们可以遵循一些原则来找到最适合你的那个数字。

-

核心原则:使用连接池,并设置合理的池大小,绝大多数现代应用程序都不会为每次请求创建新的连接再关闭,而是使用连接池,连接池维护着一组预先建立好的连接,应用程序需要时从池中借用,用完后归还,这避免了频繁建立和断开连接的开销。问题的关键就变成了:连接池应该设置多大?

-

参考公式与基准测试:数据库专家Martin Thompson等人曾提出一个估算线程池(其原理与连接池相通)大小的经验公式:*池大小 ≈ (CPU核数 2) + 磁盘 spindle数,对于Redis这种主要是内存操作、计算密集型的服务,可以简化为关注CPU核数,你的Redis服务器是4核CPU,那么一个初始的参考值可以设在8-10左右。但这仅仅是起点。**

-

必须进行压测!压测!压测!:理论值必须通过实际压力测试来验证和调整,你需要模拟真实的生产环境流量,使用像

redis-benchmark或memtier_benchmark等工具,在逐步增加并发连接数(即客户端并发数)的情况下,观察两个关键指标:- 吞吐量(QPS:每秒请求数):随着连接数增加,QPS会先快速增长,然后趋于平缓。

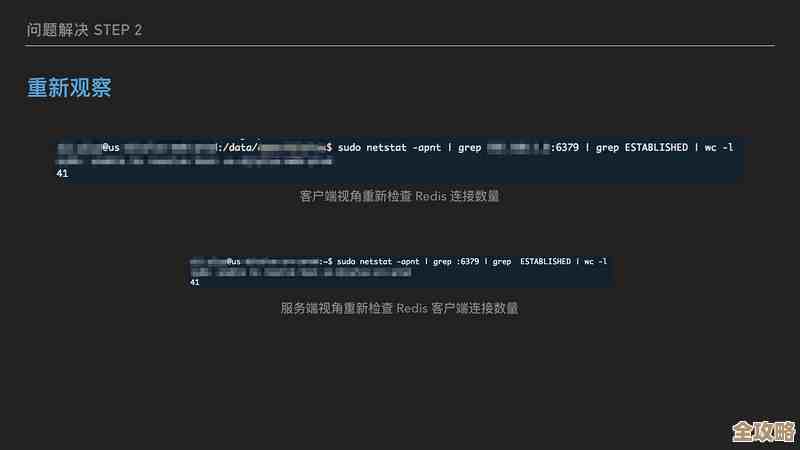

- 延迟(Latency):随着连接数增加,平均延迟和尾部延迟(如P99延迟)的变化。 你会发现一个“拐点”:当连接数超过某个值后,QPS不再增长甚至开始下降,而延迟却开始显著上升,这个拐点之前的值,就是你当前业务和硬件配置下比较理想的连接池大小,你可能发现当并发连接数达到200时,QPS是10万,延迟1毫秒;当达到300时,QPS还是10万,但延迟变成了1.5毫秒;当达到500时,QPS降到9.5万,延迟飙升到5毫秒,那么200-300可能就是你的最佳区间。

-

考虑业务类型:如果你的应用主要是轻量级的

GET/SET操作,那么单个连接能处理的QPS很高,所需的连接池大小可以小一些,如果业务中混杂了大量耗时的命令(如范围查询、聚合计算等),那么可能需要稍大一点的连接池来避免等待,但同时更要紧的是优化这些慢查询。

控制Redis连接数的核心在于避免不必要的资源浪费和竞争,连接数并非越多越好,过犹不及,正确的做法是:

- 强制使用连接池。

- 从一个基于CPU核数的合理初始值(比如10-20)开始。

- 通过严格的压力测试,找到吞吐量和延迟的“最佳平衡点”,从而确定最终的生产环境配置。

- 务必优化Redis配置,提高操作系统的文件描述符上限,并严格避免慢查询命令。

才能确保你的Redis服务始终保持流畅,避免出现令人头疼的卡顿问题。

本文由称怜于2026-01-10发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/78219.html