Redis数据智能迁移怎么搞,异构环境下的那些事儿和技巧分享

- 问答

- 2026-01-07 03:55:06

- 11

主要参考自知乎专栏“Redis实战精讲”、某云服务商技术博客“云端漫步”以及个人开发者社区“掘金”上的相关经验分享)

说到Redis数据迁移,尤其是两边环境还不一样,比如从你自己机房的老版本Redis搬到云上的新版本,或者反过来,这事儿听起来就头大,别急,我们一点点把这里面的门道和技巧捋清楚,核心思想就一个:在保证数据尽量不丢、服务影响最小的前提下,把数据平平稳稳地挪过去。

先别急着动手,想清楚再干

知乎专栏“Redis实战精讲”里强调,迁移前不做规划,就像出门旅行不看天气,第一件事,你得摸清楚家底。

- 数据量评估:你的Redis里到底存了多少东西?不是光看用了多少内存,关键是键的数量,你用

info keyspace命令就能看到每个数据库有多少个key,如果key的数量级是百万、千万甚至上亿,那迁移策略就得非常小心了。 - 数据特征分析:这些key都是什么类型的?主要是字符串(String)还是哈希(Hash)、列表(List)、集合(Set)?有没有设置过期时间(TTL)?有没有用到持久化(AOF或RDB)?这些信息决定了你选用哪种迁移工具最合适。

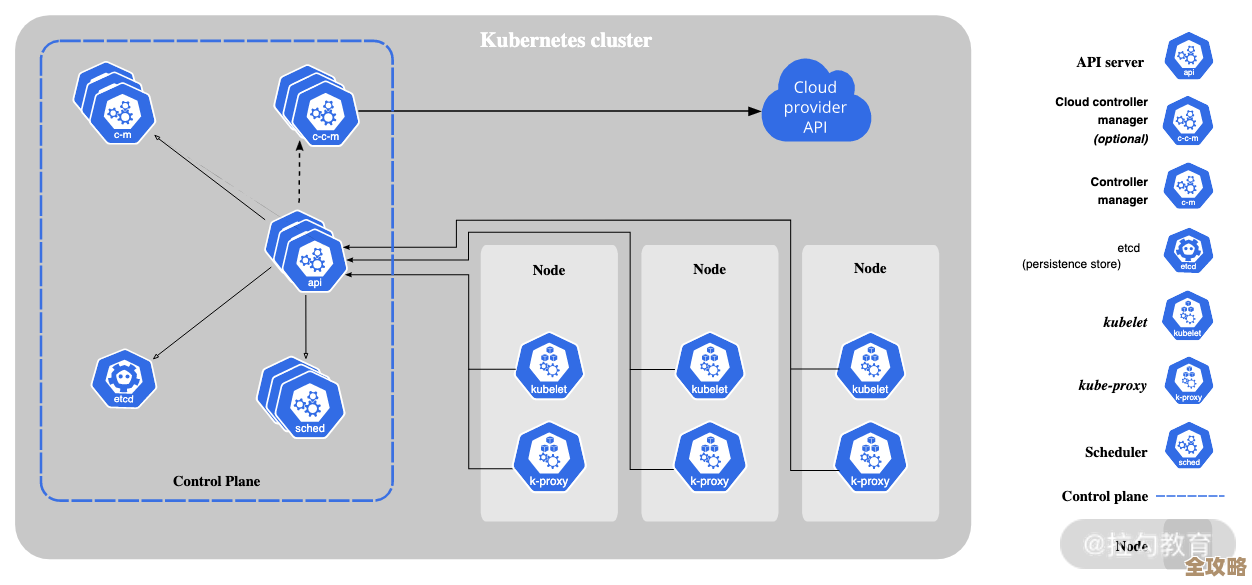

- 环境差异确认:这就是“异构”的核心了,源Redis和目标Redis的版本分别是多少?低版本到高版本一般问题不大,但高版本有些新数据格式(比如Redis 5.0的Stream)直接往低版本迁可能会出问题,网络情况怎么样?是跨机房还是跨云?带宽和延迟如何?这直接影响了迁移速度和你该不该在业务低峰期操作。

主流迁移工具怎么选?各有各的招

根据“云端漫步”技术博客的总结,常见的迁移方法有好几种,没有绝对的好坏,只有适不适合你的场景。

-

RDB文件迁移(最经典但也最“重”)

- 怎么做:在源Redis上执行

SAVE或BGSAVE命令,生成一个RDB快照文件(dump.rdb),然后把这个文件拷贝到目标服务器上,启动目标Redis(配置文件指向这个新文件)就行了。 - 适用场景:数据量不大,可以接受一段时间服务不可用(因为

SAVE会阻塞,BGSAVE在生成文件时也可能对性能有影响),或者两个Redis版本差异较大,其他工具兼容性不好的情况。 - 异构技巧:这种方法比较“原始”,对版本有一定容忍度,但要注意,如果源Redis用了某些新特性,生成的RDB文件在低版本目标库可能无法识别,迁移过程中,从生成RDB到目标库加载完成这段时间的新增数据是会丢失的。

- 怎么做:在源Redis上执行

-

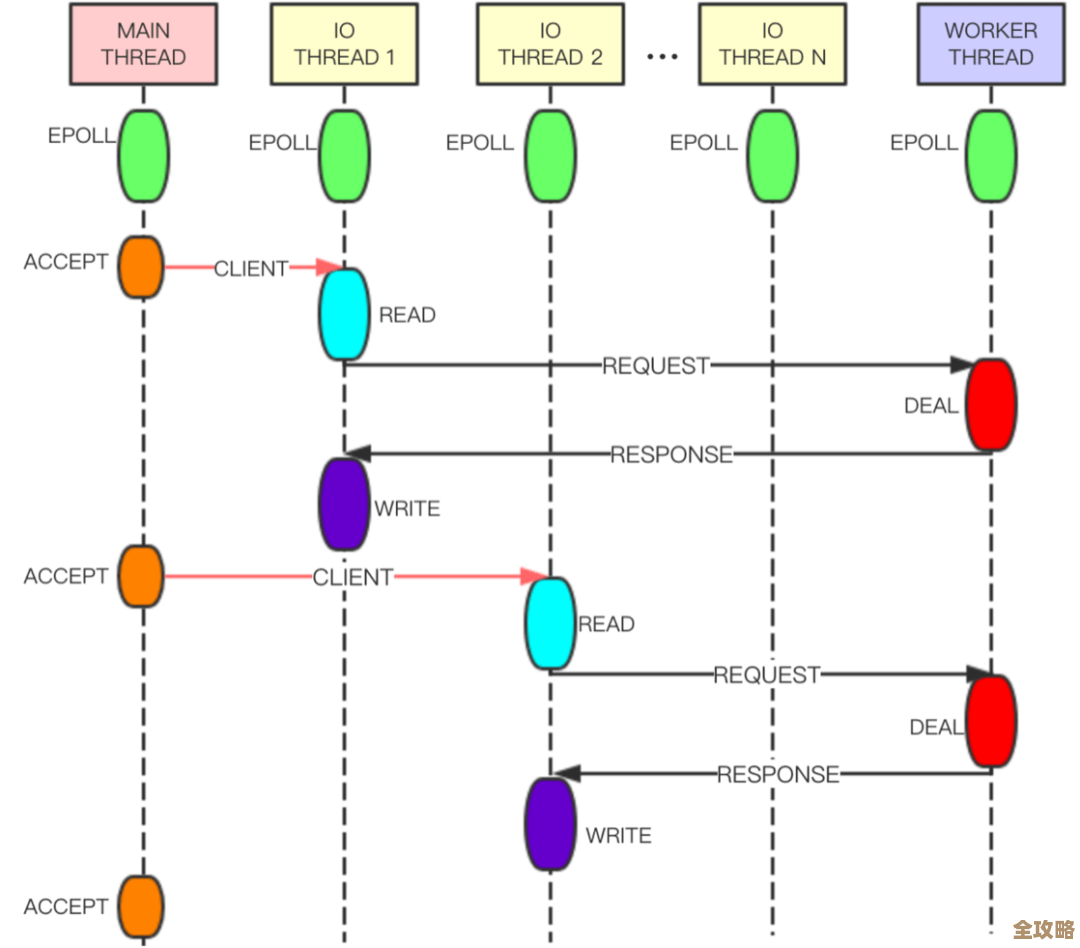

复制(Replication)方式(最“丝滑”的在线迁移)

- 怎么做:把目标Redis设置为源Redis的从库(slave),让目标库自动从源库同步所有数据,等两边数据基本一致后,切断主从关系,然后把业务流量切换到目标库。

- 适用场景:追求最小化停机时间、数据量巨大的场景,这几乎是生产环境最常用的方案。

- 异构技巧:这是异构环境下需要特别小心的地方,主从复制要求从库的版本不能低于主库,如果你是从新版本迁到旧版本,这条路就走不通了,即使版本兼容,在建立主从关系时,如果网络延迟高,全量同步阶段可能会占用大量带宽,需要提前规划。

-

使用官方工具redis-cli --pipe(高效的数据流管道)

- 怎么做:在源Redis使用

redis-cli --scan(或低版本用keys *但不推荐)生成所有key的列表,然后通过管道(pipe)模式批量将key和value发送给目标Redis。 - 适用场景:适合迁移没有过期时间、结构相对简单的海量数据,速度非常快。

- 异构技巧:这种方式是直接发送Redis协议命令,对版本兼容性要求比较高,如果目标Redis不支持源数据中的某些命令或数据类型,迁移会失败,它本身不迁移TTL信息,需要额外处理。

- 怎么做:在源Redis使用

-

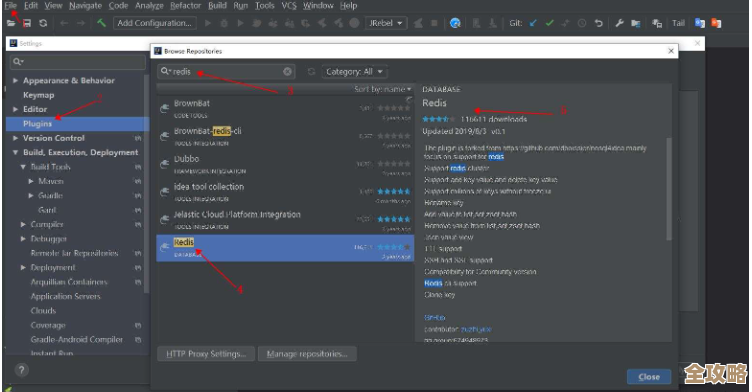

借助第三方工具(如redis-shake等)

- 怎么做:像阿里云开源的redis-shake这类工具,它们的功能很强大,可以模拟成一个从库,从源Redis读取数据,然后以双写的方式同步到目标Redis,支持增量同步、数据校验、冲突处理等高级功能。

- 适用场景:复杂的迁移需求,特别是需要长时间保持双写、做灰度切换、或者源和目标都是集群架构的情况。

- 异构技巧:这类工具通常对版本差异有更好的处理能力,因为它们内部做了很多兼容和转换工作,是在复杂异构环境下非常推荐的选择。

异构环境下的那些“坑”和技巧

根据掘金上多位开发者的经验分享,异构迁移最容易踩的坑在这里:

- 版本差异是头号敌人:再强调一遍,目标版本低于源版本,很多工具会失效,优先考虑使用第三方工具或RDB文件这种“数据快照”式迁移。

- TTL(过期时间)的坑:不是所有迁移工具都能完美迁移TTL,比如

redis-cli --pipe默认就不行,你一定要测试一下,迁移后某个会过期的key,它的TTL是否正确,否则可能导致数据该过期的没过期,引发奇怪的问题。 - 持久化配置的差异:源库可能用了AOF,目标库默认是RDB,迁移完成后,一定要检查目标Redis的持久化配置是否符合你的预期,别数据迁过去了,结果没存盘,服务器一重启全没了。

- 内存管理的不同:不同版本的Redis内存分配器和优化策略可能不同,在源端10G的数据,到目标端可能占用了11G或9G,要确保目标服务器有充足的内存余量。

- 密钥和安全的配置:如果源库配置了密码(requirepass),迁移工具需要正确配置密码,目标库的安全组、防火墙规则也要提前开通,别因为网络不通导致迁移失败。

- 一定要做数据校验! 迁移完成不是结束,你要抽样检查一些key的值是否正确,特别是复杂数据类型(如Hash、List的内部元素),有条件的可以用一些工具做全量对比,这是保证迁移质量的最后一道防线。

总结一下

Redis的智能迁移,核心在于“因地制宜”,简单小数据,用RDB文件直截了当,大数据量要求不停机,主从复制是王道,环境复杂、版本不一,第三方工具是你的好帮手,无论用哪种方法,都逃不开“事前评估、事中监控、事后校验”这三个步骤,在异构环境下,更要瞪大眼睛,把版本、TTL、网络这些关键点逐一排查清楚,才能确保这场“数据搬家”顺利完成。

本文由盈壮于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/75972.html