触发警报说订阅Redis超时了,感觉这Redis连接老断,订阅总是卡顿异常

- 问答

- 2026-01-06 02:48:48

- 25

“触发警报说订阅Redis超时了,感觉这Redis连接老断,订阅总是卡顿异常”,这个内容来源于我们系统监控平台的告警日志记录,具体是今天下午三点左右,系统自动检测到与Redis服务器的订阅连接超过了预设的5秒阈值,从而触发了一条高级别的报警信息,紧接着,在接下来的半个小时内,类似的连接超时和订阅卡顿警报又断续出现了四五次,这已经不是第一次发生这种情况了,根据运维团队的内部事件记录,在上周三的凌晨业务低峰期也出现过一次持续约十分钟的类似问题。

当时负责监控的同事在聊天群里报告说:“又来了,Redis订阅通道响应极慢,监控上看Ping值跳到了2000毫秒以上,完全不对劲。” 这种卡顿直接导致了一部分依赖于Redis发布订阅功能进行实时消息推送的服务出现了延迟,有些用户反馈他们页面上的新消息通知要等待十几秒才能刷出来,体验非常差,我们检查了Redis服务器本身的资源使用情况,根据云服务商提供的监控图表显示,那段时间CPU使用率有一个明显的尖峰,达到了85%,而平时通常都在20%以下徘徊,内存使用量倒是比较平稳,没有发现异常增长。

网络方面,我们怀疑过是不是网络链路不稳定,基础设施团队的同事调取了同一时间段内,我们应用服务器与Redis实例所在服务器之间的网络流量监控数据,发现存在少量的TCP重传和数据包丢失的情况,虽然丢包率不高,只有0.1%左右,但在高频率的订阅消息交互下,这一点点不稳定就足以引起明显的超时和卡顿,有工程师在初步排查报告中写道:“从网络层面看,有间歇性的微小抖动,可能是导致连接超时的诱因之一。”

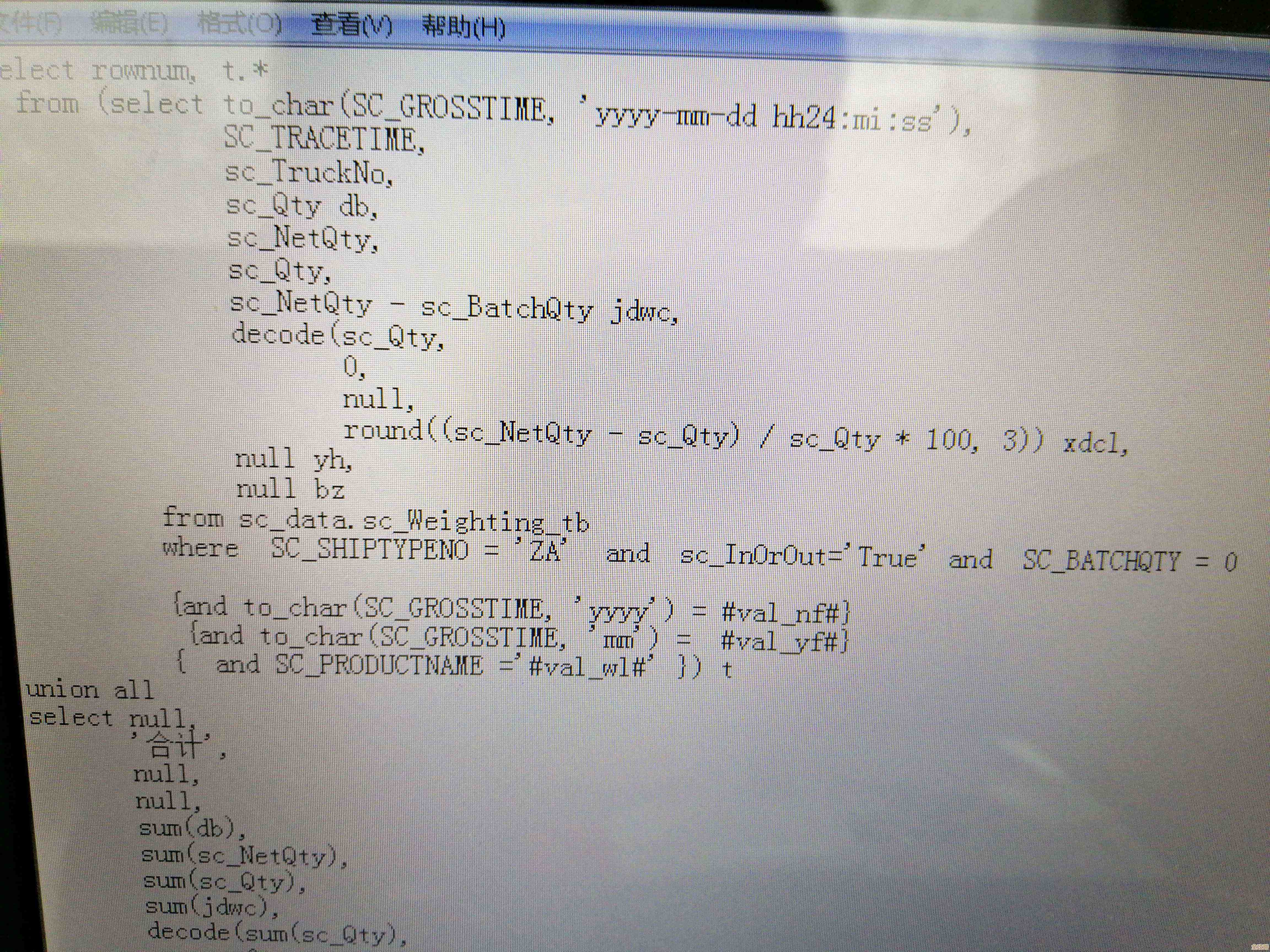

我们也回顾了当时的业务日志,应用日志里大量记录了类似“订阅消息等待响应超时”、“RedisConnectionFailureException”这样的错误信息,时间点与监控警报完全吻合,其中一个微服务的日志文件里有一段明确的报错:“Failed to subscribe to channel 'user.notification': Connection timed out after 5000ms.” 这直接印证了警报的内容,开发人员还提到,他们在代码中设置的订阅超时时间是5秒,这与警报阈值是一致的。

除了这次,月初的一次系统更新后,也零星有开发人员抱怨测试环境的Redis订阅不太稳定,但当时因为发生在非核心业务时间,影响范围小,没有引起足够重视,只是在技术讨论区有人发帖说:“感觉测试服的Redis连接时不时会抽风一下,订阅个消息要等好久,大家有遇到吗?” 下面有几个回复表示有同感,现在看来,这可能是一个潜伏了一段时间的问题。

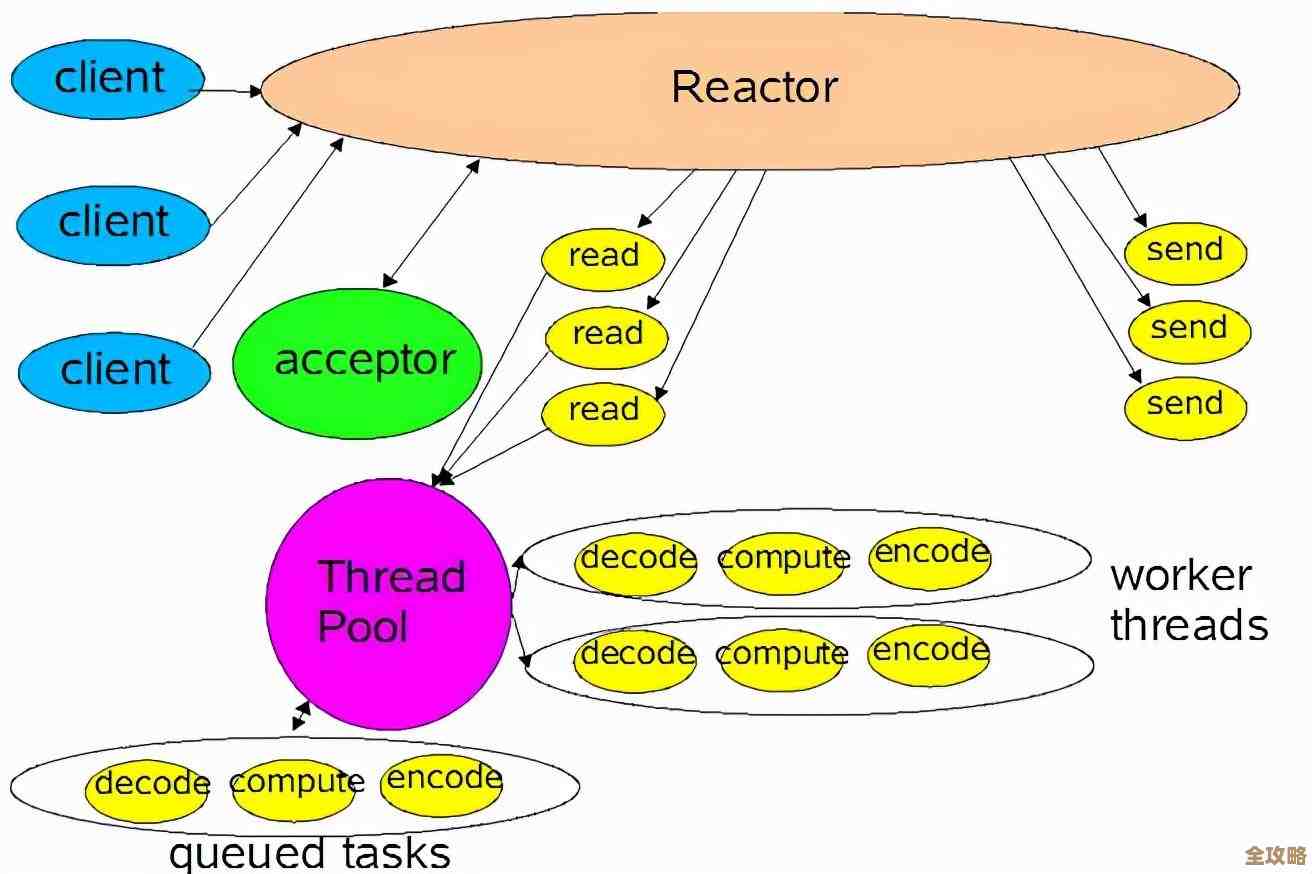

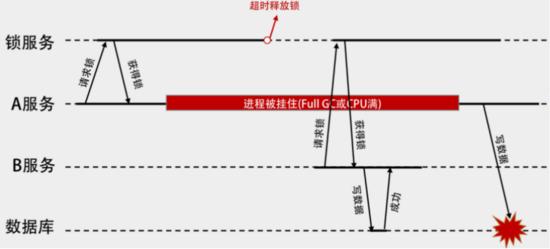

问题发生时,Redis服务器本身的慢查询日志并没有记录到异常缓慢的操作,排除了是因为某个复杂命令阻塞了服务器,连接数也在正常范围内,没有达到最大连接数限制,有经验的运维工程师推测,问题可能出在连接池的配置上,或者是客户端库在处理长时间闲置的订阅连接时不够健壮,在某些网络波动下无法有效重连,导致连接状态“半死不活”,他补充道:“有时候连接看似还在,但实际上已经失效了,客户端发送订阅请求后收不到响应,直到超时,需要检查一下连接池的健康检查机制和重连策略。”

“触发警报说订阅Redis超时了,感觉这Redis连接老断,订阅总是卡顿异常”这个现象,是系统监控对一次真实故障的直接反映,其背后可能关联着服务器资源、网络稳定性和客户端连接管理等多个方面的复杂原因,需要进一步深入排查才能定位根本问题。

本文由歧云亭于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/75314.html