GPU 容器虚拟化又有新东西了,怎么用才更顺手全场景都能试试看

- 问答

- 2025-12-29 07:13:09

- 3

关于GPU容器虚拟化又有了新的进展,这个新东西主要来自于一些公司和开源社区的努力,让原本在容器里使用GPU这件有点“技术活”的事情,变得更容易上手,而且能适应的场景也更广了,就是现在你想在容器里跑需要GPU的程序,不管是做人工智能训练、科学计算,还是图形渲染,都比以前更顺手了。

新东西“新”在哪?以前为啥不顺手?

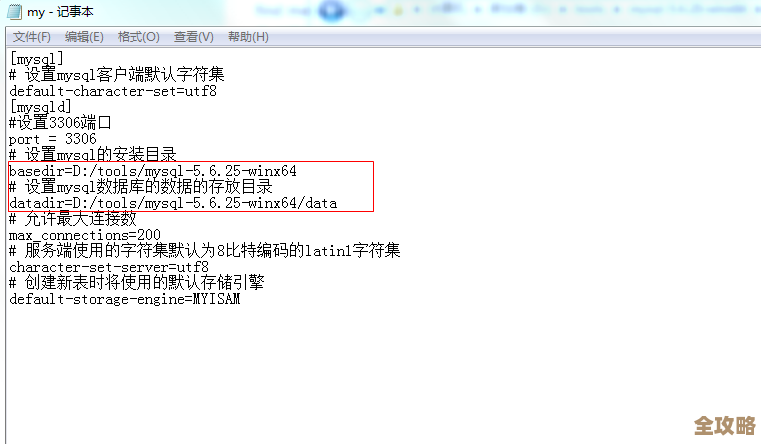

要理解新在哪,得先知道以前的痛点,最早的时候,在容器里用GPU,通常需要把宿主机的整个GPU驱动和库文件“映射”到容器里,这种方法很原始,就像把一整工具箱直接搬进一个小房间,不仅笨重,而且容易出问题,容器里的软件版本必须和宿主机一模一样,否则就“打架”,用不了,管理和升级都非常麻烦。(来源:基于早期Docker使用GPU的常见做法)

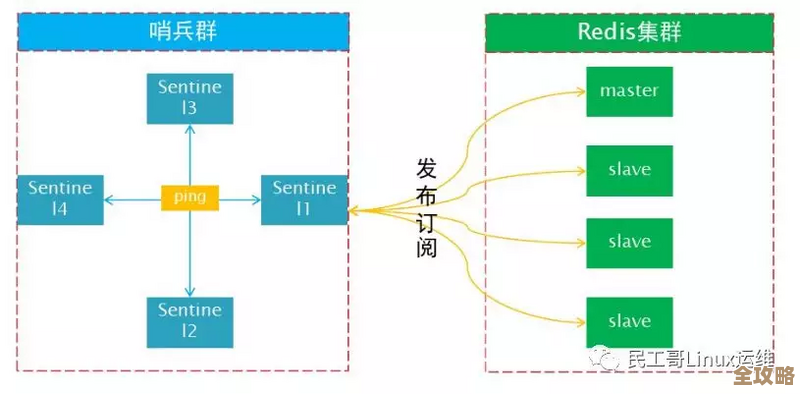

后来,英伟达推出了NVIDIA Docker,这算是一个巨大的进步,它提供了一种更标准、更干净的方式让容器访问GPU,但即便如此,它本质上还是让容器“看到”了整个物理GPU,这就带来了新的问题:如果一个团队有多个人想用同一张很贵的GPU卡,比如A100,该怎么办?大家只能排队轮流用,这张卡在一个人手里时,其他人就得干等着,GPU的资源没办法被灵活地切分和共享,这在很多时候造成了巨大的浪费。(来源:NVIDIA Docker运行时的工作机制描述)

新的进展核心就围绕着一个关键词:细粒度共享,目标是把一块强大的GPU像切蛋糕一样,分成好几份,让不同的容器、不同的用户同时使用,互不干扰。

新东西怎么用才更顺手?

让GPU容器虚拟化变得更顺手的技术路径主要有几条,它们各有侧重,你可以根据你的场景来选择。

基于MIG技术的“物理分蛋糕” 这是英伟达自家从安培架构(比如A100、H100)开始推出的硬件事物,MIG的全称是Multi-Instance GPU,它允许系统管理员把一块物理GPU最多划分成7个独立的、硬件隔离的“小GPU实例”。(来源:NVIDIA官方MIG技术文档)

- 怎么用:你用命令工具或者Kubernetes的插件,就可以像分配CPU和内存一样,直接申请“我要1个拥有5GB显存的GPU实例”,这个实例是硬件层面隔离的,性能非常稳定,绝对不会被“邻居”影响。

- 什么时候更顺手:这特别适合需要稳定性能和严格隔离的企业环境,在一个AI平台上有多个团队,有的在做模型训练,有的在做模型推理,你可以给训练任务分一个大的GPU实例,给推理任务分几个小的实例,大家井水不犯河水,资源利用率大大提高,缺点是它需要特定的高端GPU硬件支持。

基于时间切片的“软件排队” 对于一些没有MIG功能的GPU(比如常用的V100、RTX系列),或者需要更灵活分配的场景,就可以用时间切片的方式,这个技术不是真的把GPU硬件切开,而是通过驱动程序,让多个任务在GPU上非常快速地轮流执行,就像单核CPU同时运行多个程序一样。

- 怎么用:在Kubernetes这样的容器编排平台里,你可以通过一些插件(比如NVIDIA的K8s Device Plugin配合特定的配置)来设置,你可以指定一个容器“最多能使用GPU 50%的计算能力”,即使当前只有它一个任务在跑,它也不会占满100%,剩下的算力可以分配给其他容器任务。

- 什么时候更顺手:这非常适合开发和测试环境,数据科学家们都在同一个服务器上调试代码、跑一些小规模的实验,通过时间切片,大家不用争抢,可以同时进行,虽然每个人的任务会慢一点,但避免了漫长的等待,整体效率提升了,它的缺点是任务之间没有硬隔离,如果一个任务崩溃导致GPU驱动出问题,可能会影响同卡上的其他任务。

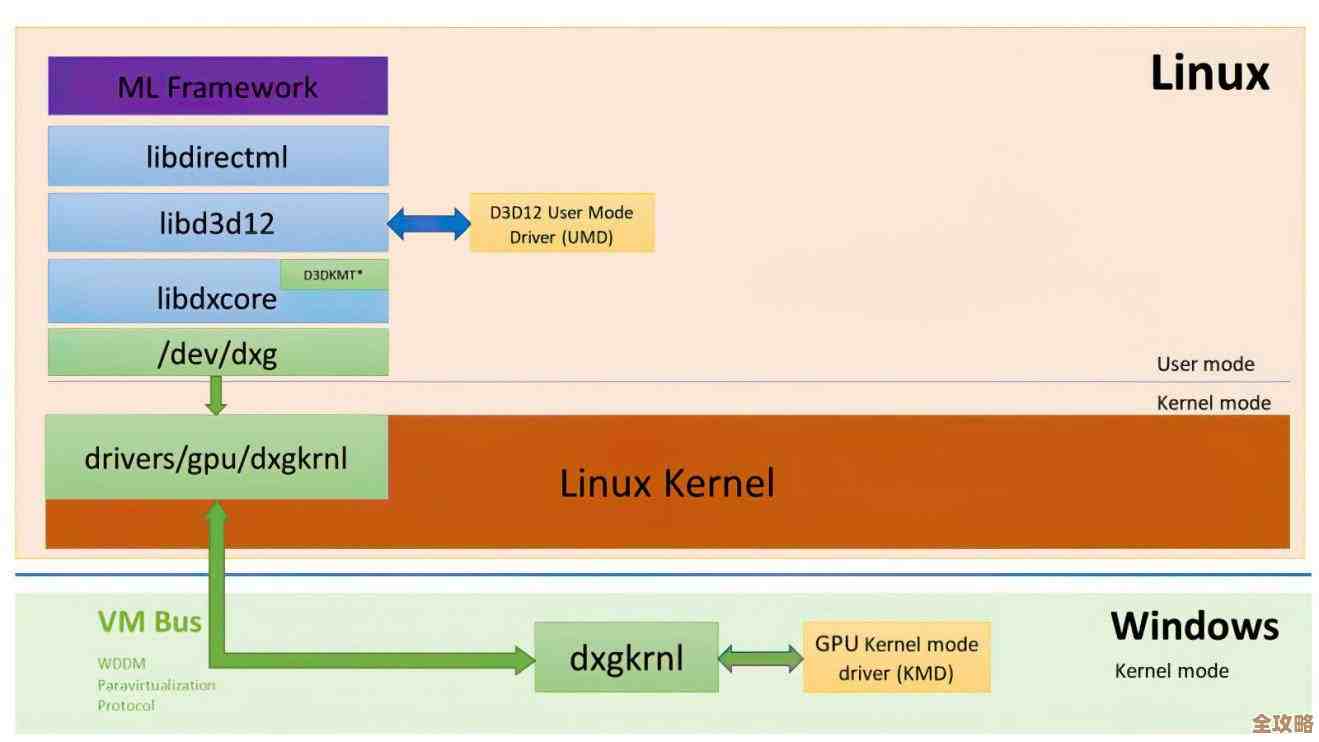

虚拟化技术的“全场景覆盖” 还有一些更前沿的技术,比如借助底层虚拟化Hypervisor来实现GPU的虚拟化,这种方法能做到非常精细的资源切割,甚至可以把不同厂商(比如英伟达、AMD)的GPU资源统一管理起来,形成一个虚拟的GPU资源池。

- 怎么用:这类方案通常由一些专业的云计算厂商或开源项目提供(例如某些基于Kubernetes的扩展方案),它们会提供自己的操作接口和调度策略,他可能不需要关心底层是哪种GPU,只需要申请“需要多少GPU算力”即可。

- 什么时候更顺手:这瞄准的是混合云和多云环境,或者大型企业希望构建内部私有云平台的时候,它能实现最大程度的灵活性和资源池化,让GPU像现在的云服务器一样可以按需创建、销毁和调整配置,目前这类技术还在不断成熟和普及中。

全场景都能试试看,怎么理解?

所谓的“全场景”,就是指从个人的笔记本电脑,到多人的开发机,再到大型的数据中心和生产环境,都有了更顺手的GPU容器化方案。

- 个人学习/开发场景:你可以在自己的带GPU的电脑上,使用Docker Desktop(已内置了对GPU的支持)或者简单的容器运行时,直接运行一个包含PyTorch或TensorFlow的容器来做练习,这是最基础的“顺手”。

- 团队研发场景:团队共享一台或多台强大的GPU服务器时,就可以采用上面提到的时间切片或者MIG技术,通过Kubernetes进行资源调度,每个成员通过提交作业的方式使用GPU,避免了冲突,管理起来非常清晰。

- 大规模生产环境:在需要部署AI模型服务(推理)的场景下,MIG能保证每个服务的响应时间稳定;而虚拟化技术则能实现高效的弹性伸缩,在流量高峰时自动分配更多GPU资源,低谷时释放以节省成本。

GPU容器虚拟化的新进展,核心就是让资源的分配从“粗放”走向“精细”,从“独占”走向“共享”,无论你是在哪个环节使用GPU,现在都有更合适的工具和方法,让你用得更顺手、更高效,选择哪种方案,取决于你的具体需求:是追求极致的性能和隔离,还是更看重灵活性和成本,建议可以从自己最熟悉的场景开始,比如先在团队的开发服务器上尝试配置时间切片,亲身体验一下这种“顺手”带来的便利。

本文由盘雅霜于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/70511.html