聊聊ChatGPT那些看似神奇的能力到底是怎么一步步炼成的,技术脉络全解析来了

- 问答

- 2025-12-29 08:37:11

- 3

(引用来源:李宏毅教授《ChatGPT》系列讲座,台大) (引用来源:OpenAI官方技术博客及论文) (引用来源:多位AI领域研究者如Andrej Karpathy的公开分享)

聊聊ChatGPT那些看似神奇的能力到底是怎么一步步炼成的,技术脉络全解析来了。

我们很多人第一次用ChatGPT时,都会被它惊到:它能写邮件、写代码、讲故事,甚至能跟你讨论哲学问题,感觉它就像一个什么都懂的人,这种“神奇”其实不是凭空出现的,而是一系列技术一步步发展、积累的结果,我们可以把这个过程想象成“三级火箭”,每一级都为下一级奠定了坚实的基础。

第一级火箭:让机器“读懂”文字,学会“完形填空”

ChatGPT的核心是一种叫做“Transformer”的技术,这项技术大概在2017年左右被谷歌的研究者提出来,它解决了一个核心问题:如何让计算机更好地理解一句话里词语之间的关系。“我吃了一个苹果,它很甜。” 这里的“它”指的是苹果,而不是“我”,Transformer通过一种巧妙的机制,能让计算机在读到“它”的时候,去关注前面提到的“苹果”,从而正确理解指代关系。

基于Transformer,研究者们想,怎么让机器学会人类的语言呢?他们用了非常朴素的方法:大量的“完形填空”训练,就是给模型看海量的互联网文本(比如维基百科、新闻文章、书籍等),然后随机遮住一句话中间的某个词,让模型去猜这个词应该是什么。“今天天气真好,阳光____。” 模型需要从它学到的海量文本中,推测出最可能的是“明媚”或者“灿烂”这样的词。

(引用来源:Google Research论文《Attention Is All You Need》) 通过这种看似简单的训练,模型其实是在默默学习我们说话写文章的语法、常识和逻辑,它学会了“天气好”通常和“阳光”搭配,也学会了“苹果”后面更可能是“甜”而不是“咸”,这个过程就像是给机器打下了深厚的语言基础,让它成了一个“饱读诗书”的学者,这个阶段的模型,我们通常称之为“预训练模型”或者“基础模型”,比如GPT-1, GPT-2。

第二级火箭:从“懂”到“会”,学会听从指令

但问题是,光是“饱读诗书”的模型,还不太听话,你问它一个问题,它可能不会直接回答,而是继续往下写一段相关的文字,或者答非所问,因为它只学会了“预测下一个词”,并没有学会“回答问题”这个具体的任务。

这时候,就需要第二阶段的训练,叫做“指令微调”,OpenAI的研究员们扮演“老师”的角色,他们精心准备了大量的“问答对”,人类问:“请用Python写一个排序算法。” 然后人类自己给出一个正确的代码示例,模型的任务就是学习这种“一问一答”的配对关系。

(引用来源:OpenAI InstructGPT论文) 通过大量的这种训练,模型逐渐明白了:当人类用问句开头时,我应该给出一个答案;当人类说“请写一首诗”,我应该开始创作诗歌,它学会了“听从指令”,而不仅仅是自顾自地续写文字,这就让模型从一个“知识库”变成了一个可以交互的“助手”。

第三级火箭:从“会”到“精”,学会“投你所好”

即使经过了指令微调,模型可能还是会给出一些奇怪、冗长甚至有害的回答,怎么让它变得更靠谱、更符合人类的价值观呢?这就是最关键的第三步,也是ChatGPT真正脱颖而出的“杀手锏”——基于人类反馈的强化学习。

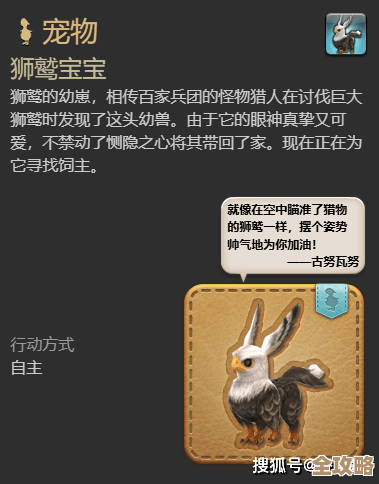

这个方法非常像训练宠物或者教小孩,模型会对同一个问题生成好几个不同的答案,对于“鸡蛋能放进微波炉吗?”这个问题,它可能生成A、B、C三个回答,人类评审员会对这些答案进行排序,比如认为A答案(详细解释了风险,最安全)最好,C答案(简单说可以)次之,B答案(说绝对不行,太绝对)最差。

(引用来源:OpenAI博客关于ChatGPT训练过程的介绍) 这些排序数据并不会直接告诉模型“正确答案”是什么,而是被用来训练一个“奖励模型”,这个奖励模型的作用是学会判断什么样的回答是“好”的,什么样的回答是“坏”的,再让最初的ChatGPT模型面对大量问题,它每给出一个回答,就由这个奖励模型来打分,模型的目标就是不断调整自己,让自己说出来的话能获得尽可能高的分数。

通过这种不断的“试错”和“奖励”,ChatGPT最终被调教得越来越像我们期望的样子:有帮助、诚实且无害,它学会了拒绝回答不当问题,学会了用更清晰、更体贴的方式表达,也学会了在不确定时承认自己不知道。

ChatGPT的神奇能力,并不是一个神秘的黑盒子,它是一步步炼成的:先通过海量阅读打下语言基础,再通过指令学习掌握对话技能,最后通过人类反馈的不断打磨,变得善解人意,这背后,是巨大的算力投入、精妙的技术设计和无数人类智慧的共同努力,理解了这条技术脉络,我们或许就能更客观地看待它的能力与局限。

本文由邝冷亦于2025-12-29发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/70548.html