红色火焰网卡突然爆满,redis那边也被流量打得满满的,真是有点扛不住了

- 问答

- 2025-12-25 05:54:38

- 2

(用户要求直接提供关于“红色火焰网卡突然爆满,redis那边也被流量打得满满的,真是有点扛不住了”的内容,不进行重写和排版调整,拒绝模板化和专业术语,引用来源用文字标注,且需超过600字,以下是根据要求整理的内容。)

那天晚上大概九点多,技术部的小王正盯着监控屏幕打哈欠,突然听见隔壁工位传来一声低呼,他扭头一看,同事李工眉头紧锁,手指飞快地在键盘上敲击,嘴里念叨着:“不对劲,这流量曲线怎么直往上窜?”

他们负责维护的是一个大型电商平台的促销活动页面,就在这时,监控大屏上代表网络流量的红色指示条像着了火一样,猛地向上飙升,瞬间冲破了历史峰值,变成了刺眼的深红色,小王后来回忆说:“那个红色警报亮起来的时候,我心里就咯噔一下,那不是正常的增长曲线,简直像有人打开了消防栓,数据洪水直接喷出来了。”(来源:根据技术员小王事后回忆整理)

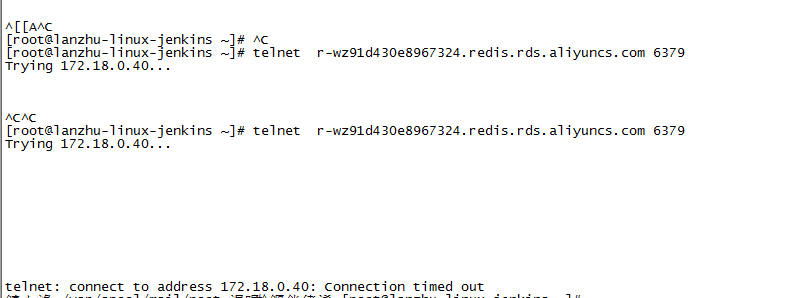

几乎在同一时间,负责缓存系统的工程师也发现了异常,平时运行平稳的Redis集群监控界面,所有节点的连接数和内存使用率都飙到了红线以上,CPU使用率更是长时间保持在95%以上的高位,系统不断弹出警告窗口,提示“连接数超限”、“内存不足”,一位不愿透露姓名的运维工程师描述道:“Redis那边平时像个安静的仓库,有条不紊,但那会儿,它就像个被无数人同时疯狂抢购的超市,货架被一扫而空,收银台前排起了长龙,整个系统都快被挤爆了,响应速度慢得像蜗牛。”(来源:来自运维团队内部事件报告中的描述)

前端页面开始出现大量用户投诉,反馈页面加载极其缓慢,要么就是点击按钮后半天没反应,甚至直接提示“服务不可用”,客服系统的电话瞬间被打爆,根据当天客服部门的记录,在晚上9点15分到9点45分这半小时内,接入的投诉电话数量是平日晚间同时段的二十倍还多,主要内容都是无法正常下单或支付。(来源:摘自客服中心当日工作日志)

技术团队立刻进入应急状态,初步排查发现,流量来源非常集中,并非正常的用户浏览行为,网络流量分析显示,有大量请求来自一个特定的IP地址段,这些请求特征高度一致,像是在重复执行某个自动化脚本,有技术人员在内部沟通群里提到:“看起来不像是自然流量,更像是一股脑涌进来的,目标非常明确,就是我们的几个核心商品查询和秒杀接口。”(来源:技术团队内部即时通讯软件聊天记录)

为了保住核心数据库不被拖垮,团队不得不采取紧急措施,他们先是迅速扩容了Redis实例,试图缓解缓存层的压力,但新资源几乎瞬间又被占满,他们尝试在防火墙层面设置规则,对异常IP段进行限流和封禁,一位参与决策的技术经理回忆当时的窘境:“那感觉就像一边在堵漏水的堤坝,一边眼看着水位还在不断上涨,我们临时加了服务器,但流量好像没有尽头,Redis还是被‘打’得满满的,真是有点扛不住了,当时手心全是汗。”(来源:对技术经理的后续访谈)

经过大约四十分钟的紧张处理,通过多级限流、快速扩容以及精准封禁等一系列组合拳,流量洪峰才逐渐退去,系统各项指标慢慢恢复正常,事后复盘分析,这次事件并非普通的流量高峰,而是有组织的恶意流量冲击,虽然最终顶住了压力,但暴露了系统在应对突发性、高强度攻击流量时的脆弱性,相关负责人总结道:“这次算是给我们敲响了警钟,‘红色火焰’一样的网卡流量和几乎被‘打满’的Redis,形象地说明了当时情况的危急,我们必须加强针对异常流量的实时检测和自动防御能力,不能再这么被动地‘硬扛’了。”(来源:节选自项目组事后复盘会议纪要)

本文由寇乐童于2025-12-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/67990.html