支付宝服务异常背后的技术原因解析

- 游戏动态

- 2025-10-19 18:18:44

- 24

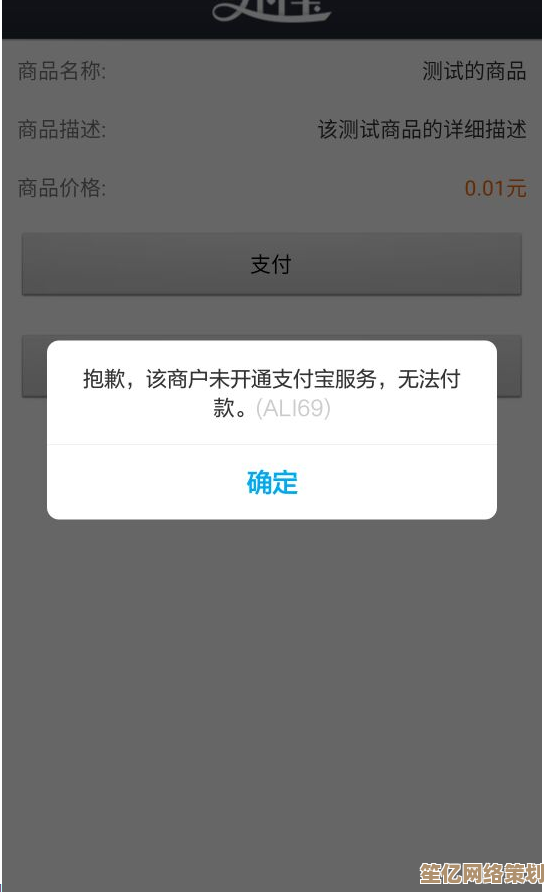

哎 你说这事儿闹的…昨天下午支付宝突然卡住的那半小时,我正扫码买煎饼果子呢,老板举着二维码 我这边转圈圈转了快两分钟…后面排队的大爷直跺脚 搞得我汗都下来了😅 这让我忍不住琢磨,这么个天天用的玩意儿,怎么说瘫就瘫了呢?

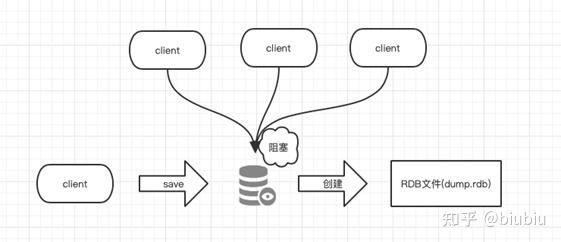

我猜啊…首先可能不是我们想的那种“服务器被黑客炸了”的戏剧性场面,更大概率是某个特别小的环节出了岔子,像蝴蝶效应那样 层层放大,有没有可能是某个数据库集群在做日常数据迁移的时候,一条看起来人畜无害的指令,因为网络延迟产生了微小的不同步?这种不同步一开始可能都没触发警报,毕竟系统冗余做得那么好…但它就像毛衣的一个线头,被后续的海量交易请求一拉扯,诶,整个数据一致性就乱套了,工程师们肯定设置了重重保险,但有时候故障的路径就是那么刁钻,能绕过所有预设的防护网,想想也挺无奈的,你防住了99.999%的可能,但总有那0.001%的奇葩组合拳等着你。

然后就是…依赖的复杂性,现在的系统都不是孤岛,支付宝背后是无数个微服务在握手、在对话,可能支付核心链路本身稳如泰山,但某个不起眼的、用来做风险控制的第三方服务接口突然响应变慢或者返回了异常数据…这个延迟或错误数据 就可能像高速上的第一次追尾,引发后面一连串的“车祸”,排查的时候最头疼这种,你得像个侦探一样,在成千上万个服务调用链路里,找出最初的那个“叛徒”,我都能想象到当时运维小哥对着满屏的监控图表,心里默念“是你是你 到底是不是你”的那种焦灼感😫。

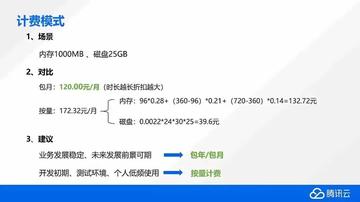

再说说流量吧,虽然支付宝肯定有弹性扩容机制,但有时候流量的洪峰来得就是那么不讲道理,也许当时正赶上什么我们不知道的“超级秒杀”活动,或者某个热点事件突然引爆了集体支付(比如某个明星演唱会门票开售?),瞬时流量可能冲到了一个远超历史峰值的诡异高度,负载均衡器可能都懵了,一下子不知道该把请求往哪台机器上导…这种时候,系统为了自保,可能会主动降级一些非核心功能,或者直接触发限流,所以我们感觉到的“卡顿”或“失败”,说不定正是系统在“断臂求生”呢,唉,也挺难为它的。

还有种不太浪漫但很现实的可能是…基础设施出了问题,机房空调挂了导致局部过热,或者光缆又被挖断了…这种物理世界的意外,对数字世界来说简直是降维打击,你代码写得再优雅,架构设计得再完美,也架不住挖掘机那一铲子啊🤯,这种时候,就得靠异地多活架构赶紧把流量切到别的城市的数据中心去,但这个切换过程本身也需要时间,期间服务不可用几乎不可避免。

想着想着 我反而有点佩服这些工程师了…这么庞大的系统,每天处理着天量的交易,能保持几乎永远稳定,本身就是个奇迹,偶尔出一次问题,就像给所有人提了个醒:看,这背后不是魔法,是无数人日夜维护的、极其复杂且脆弱的精密机器,它需要不断打补丁、升级、演练故障恢复,那次异常之后的修复过程,估计又是一场不眠不休的战斗,咖啡罐堆成山,监控屏的光映着工程师们严肃的脸…

所以吧,下次再遇到这种情况,也许我们可以多一点点耐心(虽然煎饼果子凉了确实不好吃),毕竟,让一个如此复杂的系统持续稳定运行,本身就是一场永不停歇的、与人性和概率的博弈,而偶尔的失误,恰恰说明了它是由人构建的、活生生的系统,而不是冰冷完美的神迹,这么一想,是不是感觉…它反而更真实、更可靠了一点?🍵

本文由才同于2025-10-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/yxdt/32922.html