企业在扩展容器和Kubernetes应用时常遇到的那些棘手又现实的问题,真不是说说那么简单

- 问答

- 2026-01-13 19:01:00

- 4

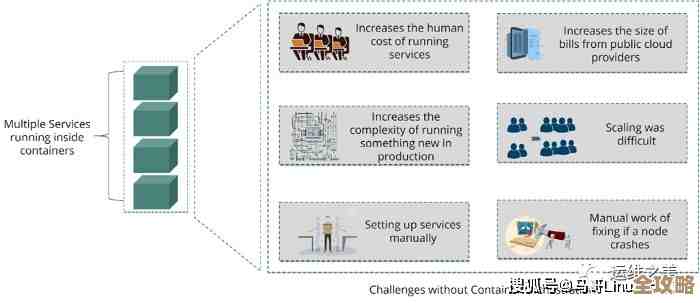

企业在刚开始接触容器和Kubernetes时,往往被其自动化、弹性伸缩、快速部署等优点吸引,但当真把关键业务搬上去,并且规模逐渐变大后,一堆在实验环境下遇不到的问题就全冒出来了,这些问题非常现实,直接关系到业务是否稳定、团队效率高低和钱袋子深浅。

首先一个绕不开的大难题就是网络,Kubernetes的网络模型要求每个Pod都有一个独立的IP地址,并且Pod之间可以直接通信,这听起来很美好,但在实际企业环境中,网络环境远比这复杂,容器里的应用如何与还没容器化的、跑在传统虚拟机或者物理机上的老系统通信?这些老系统可能还在公司的内部数据中心,有着自己的一套网络规则和安全策略,光是打通Kubernetes集群网络和现有数据中心网络,就够网络团队和运维团队折腾好一阵子了,有时候为了一个简单的连通性,不得不配置复杂的路由规则、VPN或者专门的网络代理,不仅增加了复杂度,还引入了新的故障点。(来源:众多企业云原生实践者的经验分享)

存储也是个让人头疼的事情,容器本身的设计是“无状态”的,意思是重启后里面的数据就没了,但企业的业务系统,比如数据库、文件服务,几乎都是有状态的,虽然Kubernetes提供了Persistent Volume(持久化存储)的概念,但具体用哪种存储、性能能不能跟上、怎么备份和恢复、数据的安全性如何保证,每一个都是需要深入研究的课题,不同的应用对存储的要求天差地别,有的要高速SSD,有的要低成本大容量,选择了一个存储方案后,很可能发现它无法满足所有应用的需求,结果就是一个集群里要对接多种存储后端,管理起来非常混乱。(来源:CNCF社区关于有状态工作负载的调查报告)

再来说说监控和日志排查,这简直是故障排查时的“噩梦”,在微服务和容器化的架构下,一个用户请求可能会经过几十个甚至上百个不同的Pod,当用户报障说某个功能慢或者出错时,运维人员首先要从海量的、生命周期短暂的Pod日志里,把这次特定请求流经的所有组件的日志都找出来,然后像拼图一样拼出完整的调用链,这需要一套非常完善的日志集中收集、存储和检索系统,以及分布式链路追踪工具,搭建和维护这套可观测性体系本身就是一个巨大的工程,而且对运维人员的技能要求非常高,很多时候,问题就卡在“找不到日志”或者“看不懂链路”这一步。(来源:企业级可观测性平台用户的普遍反馈)

安全问题在扩展后也变得异常突出,镜像仓库的安全、容器运行时的安全、Pod之间的网络策略、密钥和配置信息的管理,每一个环节都可能被攻击,传统安全边界在容器环境下变得模糊,需要采用“零信任”的安全模型,如何确保一个被入侵的Pod不会在集群内部“横移”,去攻击其他Pod?这需要精细配置网络策略,还有,数据库密码、API密钥这些敏感信息,绝对不能硬编码在镜像里,得用Kubernetes的Secrets或者其他外部的密钥管理工具来管理,但这又增加了使用的复杂性。(来源:安全厂商及机构对云原生安全的分析报告)

成本和资源管理的失控是很多企业后期才意识到的“惊喜”,Kubernetes的弹性伸缩听起来能省钱,但如果没有精细的管理,很容易造成资源浪费,开发人员为了保险起见,可能会给Pod申请远超实际需要的CPU和内存资源,导致集群资源利用率很低,但公司却要为此支付高昂的云服务费,随着集群数量和规模的扩大,管理集群本身(控制平面)的资源消耗和成本也会显著增长,企业需要建立成本核算和优化机制,但这往往需要额外的工具和专门的人员来做。(来源:云成本管理公司的行业洞察与分析)

Kubernetes就像一把强大的瑞士军刀,功能多但也很复杂,企业用它来扩展应用,绝不仅仅是学会几个命令和YAML语法那么简单,它涉及到网络、存储、监控、安全、成本控制等一系列底层基础设施的深刻变革和团队协作方式的调整,这些才是真正棘手又现实的挑战。

本文由召安青于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/80097.html