MySQL面对海量数据时,查询慢得让人抓狂,怎么才能不崩溃地优化和提速呢?

- 问答

- 2025-12-27 13:31:57

- 4

面对海量数据时MySQL查询慢得让人抓狂,这确实是很多开发者和管理员会遇到的头疼问题,要不想崩溃地优化和提速,不能只靠某一个“银弹”,而是需要一套组合拳,从思想、设计、查询语句到硬件配置进行系统性的优化,核心思想就是:尽量减少数据库需要处理的数据量,把力气用在刀刃上。

最根本的优化要从数据库设计和索引开始。 这就好比建房子,地基打不好,后面装修再漂亮也容易出问题,根据美团技术团队的经验,表结构设计要尽量避免过度设计,选择最合适的数据类型,比如能用int就别用varchar来存数字,能定长就别用变长,这样可以减少存储空间和I/O压力,但最重要的还是索引,索引就像书本的目录,没有索引,数据库就得一页一页地全表扫描,数据量一大自然就慢下来了,你需要为经常用在WHERE子句、JOIN条件以及ORDER BY后面的字段创建索引,阿里巴巴的开发者们就非常强调索引的有效性,他们建议定期使用EXPLAIN命令来分析SQL语句的执行计划,看看是否真的用上了你创建的索引,有没有出现全表扫描(type列显示为ALL)这种糟糕的情况,索引也不是越多越好,索引本身也会占用空间,并且会在数据增删改时降低性能,需要平衡。

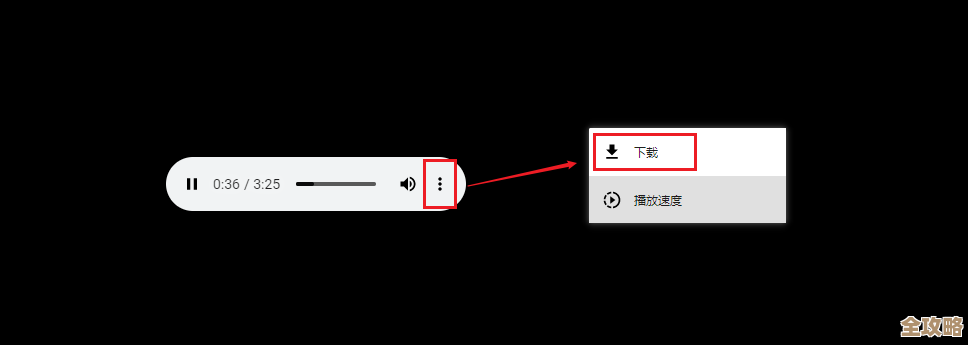

SQL查询语句的写法至关重要,一条烂SQL能拖垮整个数据库。 很多慢查询其实是因为程序员写了不高效的SQL导致的,腾讯云的数据库专家们经常处理这类问题,他们总结了一些常见的坑:一是避免使用SELECT *,只查询需要的字段,特别是不能返回TEXT、BLOB这类大字段,这能显著减少网络传输和数据排序的开销,二是谨慎使用JOIN,特别是多表关联时,要确保关联字段上有索引,并且关联的表不能太大,如果可能,尝试将复杂的查询拆分成多个简单的查询,有时候在应用程序里做处理反而更快,三是注意模糊查询,LIKE '%关键字%'这种前缀模糊匹配是无法使用索引的,会导致全表扫描,如果必须用,可以考虑使用搜索引擎如Elasticsearch来分担压力,四是合理使用分页,当LIMIT的偏移量很大时(比如LIMIT 1000000, 20),MySQL需要先读取100多万条数据然后丢弃,非常慢,这时可以通过记录上一页的最大ID,使用WHERE id > 上一页最大ID LIMIT 20的方式来优化。

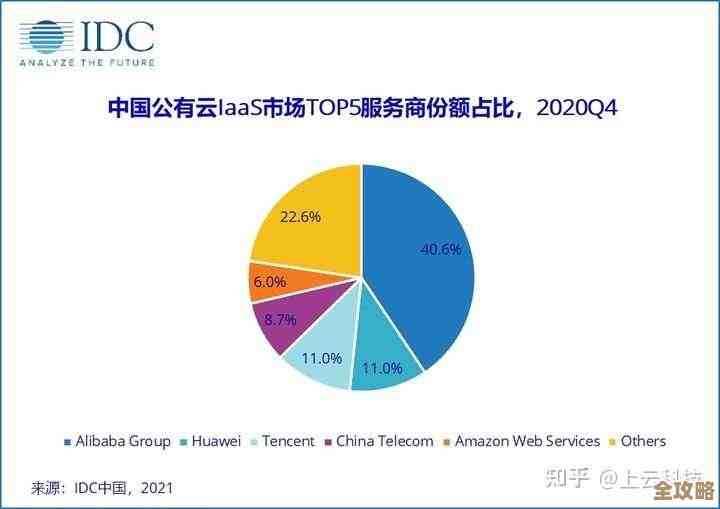

当单表数据真的膨胀到亿级以上时,单机MySQL可能就力不从心了,这时就要考虑架构层面的扩展。 这也是像淘宝、微信这样的大型互联网公司必经之路,主要有两个方向:一是读写分离,根据58同城的技术实践,通过主从复制(Master-Slave),让主库负责写操作,多个从库负责读操作,这样就把读压力分摊出去了,非常适合读多写少的场景,二是分库分表,这是应对海量数据的终极武器之一,分表就是把一张大表按某种规则(比如时间、用户ID取模)拆分成多个物理小表;分库则是将整个数据库实例拆散,分布到不同的服务器上,京东在应对大促时,就大量采用了分库分表的策略,将用户、订单等数据分散开来,极大提升了系统的整体容量和性能,不过分库分表会带来跨库查询、事务处理等复杂性,需要引入中间件(如ShardingSphere)来管理。

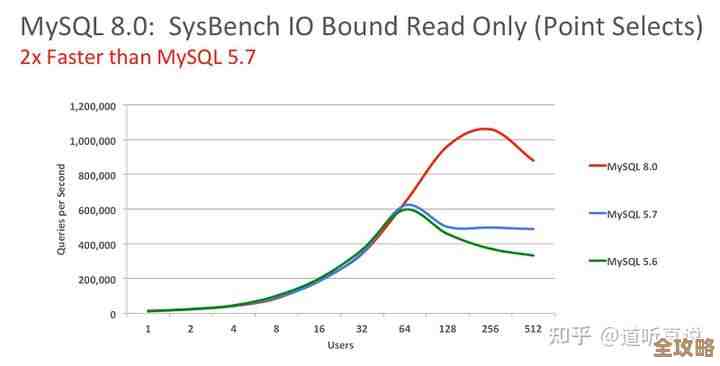

别忘了硬件和系统配置这块“压舱石”。 再好的设计和SQL,如果数据库跑在一台内存只有2G的虚拟机上也白搭,根据一些云服务商(如阿里云、腾讯云)的建议,首先确保服务器有足够的内存,让innodb_buffer_pool_size(InnoDB缓冲池)设置得尽可能大,这样数据库可以把更多的数据和索引缓存在内存中,减少慢速的磁盘I/O,使用SSD固态硬盘代替机械硬盘,能带来I/O性能的质的飞跃,对查询速度提升非常明显,定期对数据库进行优化,比如清理碎片、分析表更新索引统计信息等,也能保持数据库的健康状态。

优化海量数据下的MySQL是一个持续的过程,需要你先从最划算的SQL和索引优化入手,然后根据业务增长逐步升级到读写分离乃至分库分表的架构,同时配以合适的硬件资源,保持耐心,一步步来,就能让数据库的性能不再成为业务的瓶颈。

本文由钊智敏于2025-12-27发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/69434.html