深入探讨分布式系统的设计准则与实际应用策略

- 问答

- 2025-10-20 08:22:43

- 25

哎 说到分布式系统 这玩意儿真是让人又爱又恨,记得第一次接触时 我盯着那些密密麻麻的服务节点图 脑子里就一个想法:这特么不是自找麻烦吗?但后来慢慢发现 当系统大到一定程度 你根本没得选。😅

分布式系统设计的核心 其实是在解决一个悖论:我们既想要单机系统的简单性 又想要无限扩展的能力,这就像...嗯 想要马儿跑又想马儿不吃草,所以第一条准则可能就是“接受不完美”吧,系统总会出故障 网络一定会延迟 节点随时可能挂掉 你得从一开始就假设这些烂事一定会发生,我见过太多团队 设计时假设理想环境 结果上线第一天就崩了 半夜被叫起来处理故障的滋味可不好受。

说到CAP定理 老生常谈了 但实际应用中很多人还是拎不清,有一次和同事争论 他非说我们的系统必须同时满足一致性和可用性...我心想 哥们儿 你当这是魔法呢?最后事实证明 在跨地域部署时 我们不得不放松一致性要求 采用最终一致性,这就像...你给朋友发微信 总不能指望对方秒回吧 但只要他最终回复了 对话就能继续。💬

实际设计中 我发现“无状态设计”真是个好东西,把状态外移到Redis或数据库里 服务本身就像金鱼一样 只有7秒记忆 挂了就重启 啥也不耽误,但有些场景确实避不开状态 比如购物车 这时候就得在数据分片和复制之间做权衡,有一次我们为了性能把用户数据按地域分片 结果有个大客户员工经常跨省出差 登录时数据老是错乱...后来只好加了条特殊同步逻辑 搞得像打补丁一样。

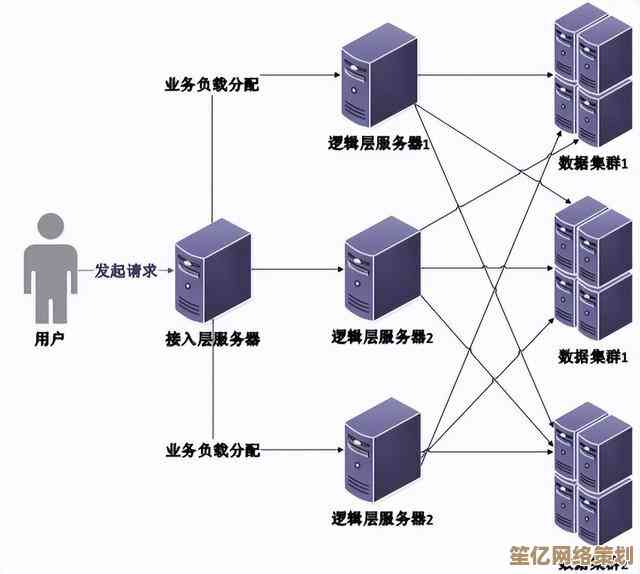

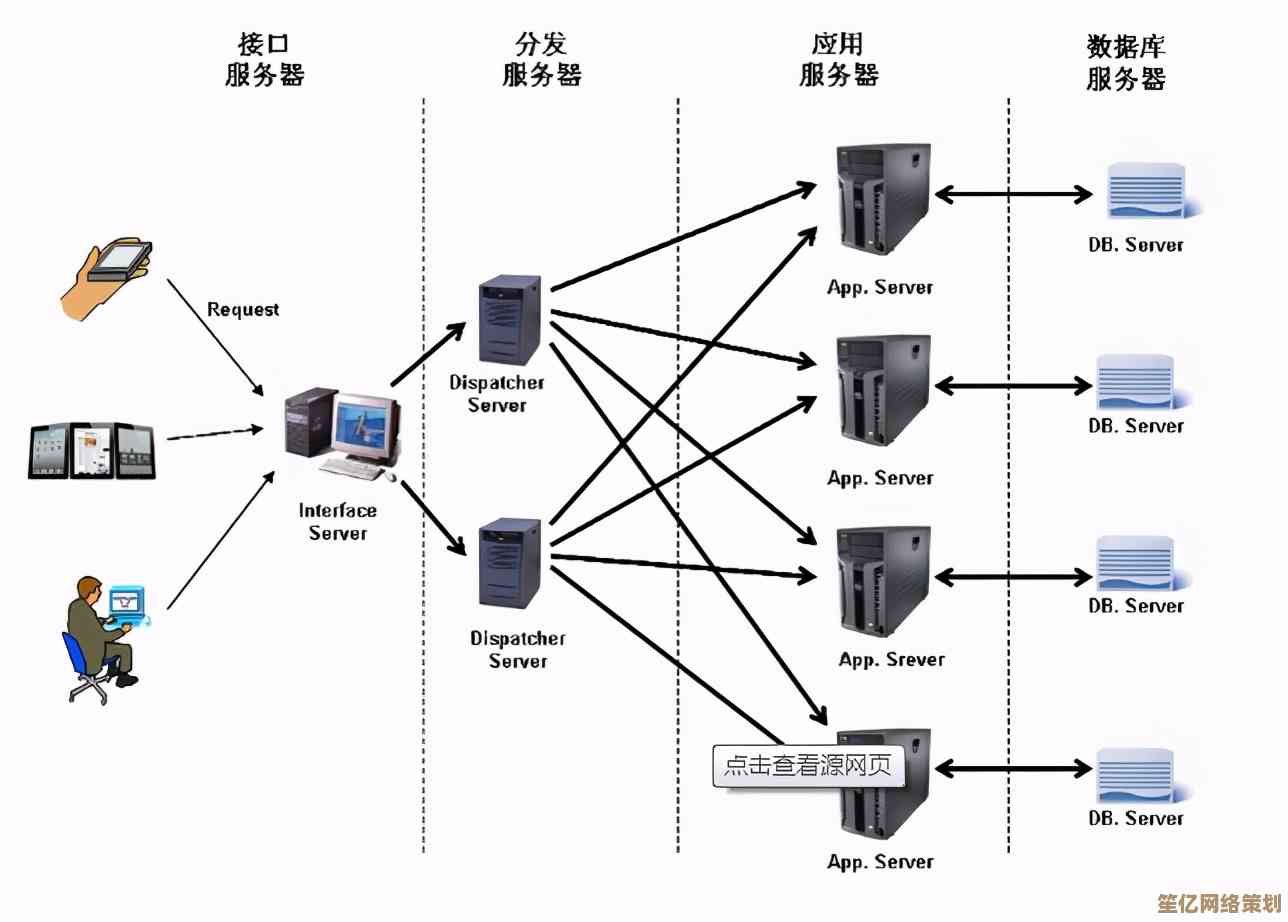

服务发现和负载均衡这些基础组件 看似简单 但细节能要人命,记得我们自研过一个服务注册中心 开始觉得很简单 用ZooKeeper存个列表不就完了?结果网络分区时出现了“脑裂” 两个数据中心各自为政 数据互相覆盖...那场面 简直是一场灾难,最后还是用回了成熟方案 有些轮子真没必要重造。

微服务拆分的艺术 更像是一种直觉,拆得太细 调用链路过长 性能撑不住;拆得太粗 又失去了扩展的灵活性,我们有个服务最初按业务领域拆 后来发现有个模块CPU密集型 总拖慢整个服务 只好又拆出来...这过程就像雕塑 得一点点打磨,而且分布式事务这事儿 能避免就避免 用 Saga模式或者补偿事务 虽然复杂点 但总比两阶段提交那种性能黑洞强。🚀

监控和可观测性 这是分布式系统的眼睛,没有它 系统就像在黑暗中开车,我们曾经迷信日志 后来发现日志太多反而找不到问题 又加了链路追踪和指标监控...现在看一个请求从入口到数据库 每一步都清晰可见,有一次排查问题 发现某个服务延迟高 最后竟是因为GC太频繁 这种问题没有全链路监控根本想不到。

容错设计上 熔断、降级、限流 这些策略就像汽车的保险带 平时感觉不到 出事时能救命,但配置这些参数需要经验 太敏感会误熔断 太迟钝又起不到保护作用,我们曾经把熔断阈值设得太低 结果正常流量波动就触发熔断 用户反而用不了服务...真是矫枉过正。

最后想说 分布式系统没有银弹 每个选择都是权衡,就像谈恋爱 你不可能找到完美的人 只能找到适合的相处方式,也许...最好的策略是保持简单 只在必要时引入复杂性,毕竟 系统是为人服务的 不是用来炫技的。😊

哦对了 还有数据一致性模型的选择,强一致性当然好 但对性能影响大 最终一致性又可能让用户看到中间状态...我们有个社交App 用户有时会看到自己刚发的帖子消失又出现 就是因为同步延迟,后来我们在UI上做了点手脚 让变化看起来更自然 用户反而接受了,所以有时候 技术解决不了的问题 可以用产品设计来弥补。

分布式系统设计是一场永无止境的修行 你得在理论和实践之间不断调整,最重要的是 保持谦逊 因为再好的设计 也抵不过现实世界的复杂性,每次我以为自己懂了 总会冒出新的问题...但这也许正是它的魅力所在吧。

本文由符海莹于2025-10-20发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/33753.html