深入理解Linux操作系统中的文件读取机制与实现原理

- 问答

- 2025-10-16 20:26:42

- 1

嗯 好 聊聊Linux文件读取这事儿吧 其实挺有意思的 我经常半夜调试代码的时候就在想 从敲下cat file.txt显示在屏幕上 这中间到底发生了什么 感觉就像一场接力赛 每个环节都扣着下一个环节。

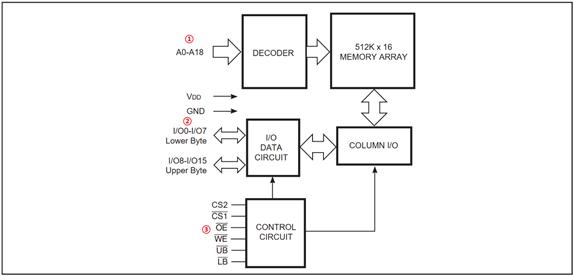

首先你得知道 当我们说“读取文件”时 内核眼里看到的根本不是我们想的那个“文件”,那首先是一串被组织起来的字节流 而且这玩意儿可能根本不在硬盘的某个连续区域里 它可能碎成一片一片的… 就像你收拾房间时乱塞的衣服 东一件西一件,文件系统比如ext4或者XFS 就是个超级管理员 它有个账本 inode嘛 记录着这些碎片都藏在硬盘的哪个角落。

读取的起点 肯定是那个open系统调用,这个open()啊 看起来简单 不就是打开个文件嘛 但内核里可是忙得团团转,它得先去查路径 一层一层目录找下去 权限对不对啊 文件存不存在啊… 最后才把那个inode从硬盘里捞到内存里 创建一个“文件描述符”给你,这个描述符 就像是银行给你的一张存折 凭这个你才能后续进行存取操作,有意思的是 open不一定真的会去碰磁盘数据 如果inode已经在内存的缓存里了 那就省事了 内核也偷懒。

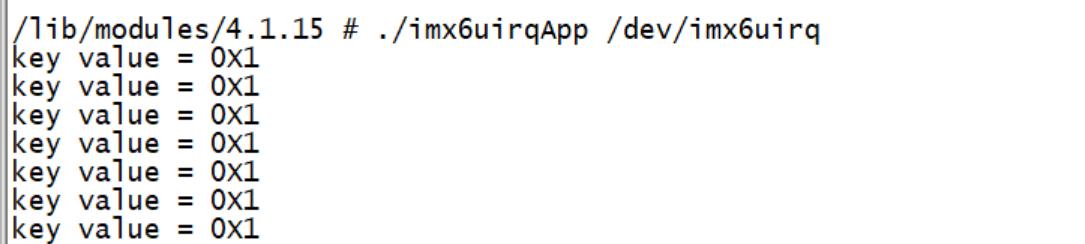

然后轮到read上场了,你以为read就是直接从硬盘读数据到你的内存?哪有那么简单,内核第一反应是问:“我要的这页数据 是不是已经在我的page cache里了?”这个page cache啊 就是内核在内存里划出的一大块缓存区 最近被读写的文件数据都会在这儿留个副本,如果运气好 缓存命中了 那速度就飞起来了 根本不用去碰慢吞吞的硬盘,这感觉就像你想查个单词 手边正好有本字典 而不是还得跑去图书馆。

但要是缓存里没有呢 那就得触发那个著名的“缺页异常”了,这时候内核才不情不愿地开始真正的磁盘I/O,它得根据inode里记录的映射关系 找出你要的数据对应着硬盘上的哪些块 然后给块设备驱动发指令:“嘿 去把这几块数据给我弄上来。” 这个过程才是真正的瓶颈所在,硬盘的磁头得咔嗒咔嗒地移动 寻道 等待盘片转到合适的位置… 这机械延迟是硬伤 所以数据库什么的才拼命想减少随机读。

说到这个 我想起有一次用strace跟踪一个程序的读取过程 看到read系统调用一次次地发生 每次读个4K什么的,我就纳闷 为啥不一次多读点?后来才明白 这其实是种权衡,用户态的缓冲区就那么大 内核也有自己的考虑,那个“预读”机制才叫聪明,内核会偷偷多读一些你可能会用到的数据 放在page cache里 猜你接下来很可能会顺序读取,这就像有个贴心的图书管理员 不仅给你拿了你要的那本书 还把旁边几本相关的也一并塞给你 说“估计你等下也要看这个”,这个预测算法其实挺复杂的 会根据你的访问模式是顺序还是随机来调整预读的窗口大小。

数据终于从硬盘读到page cache后 也还没完,还得把这些数据从内核的地址空间 拷贝到我们用户程序的地址空间,这个内存拷贝也是要消耗CPU的,所以现在的高性能编程 老是提什么“零拷贝”技术 比如用splice或者sendfile 就是想绕过这次拷贝 让数据直接从page cache飞到网络套接字什么的 省点力气。

还有啊 别忘了那些乱七八糟的锁,你想啊 page cache是共享资源 可能好几个进程都在读同一个文件 内核得加锁保证数据一致性 不然就乱套了,这个锁的竞争 有时候在压力测试下会成为意想不到的性能杀手,我猜… 内核开发者为了优化这些锁 头发肯定没少掉。

所有这些复杂的步骤 对咱们写应用程序的人来说 几乎是无感的,我们调用的read 感觉就是个简单的函数调用,内核把所有的脏活累活都包揽了 虚拟文件系统VFS层提供了统一的接口 让你不用管底下是ext4还是NTFS 是硬盘还是内存盘,这种抽象能力 真是操作系统最伟大的地方之一。

所以你看 一个看似简单的文件读取 背后是文件系统 缓存管理 块设备驱动 内存管理 这一整套庞大机制的协同工作,每次想到这些 我就觉得Linux内核真是个庞然大物 充满了各种精妙甚至有些别扭的细节 但正是这些细节 撑起了我们整个计算世界的基础,挺酷的 不是吗?虽然有时候调试到这些底层问题会让人抓狂。

本文由盘雅霜于2025-10-16发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/28722.html

![优化[word分页]使用:轻松处理大型文档,管理高效省时省力](http://www.haoid.cn/zb_users/upload/2025/10/20251017002030176063163021057.jpg)