Kubernetes集群里Etcd数据怎么备份恢复,避免丢失和出错的那些事儿

- 问答

- 2026-01-24 06:43:08

- 2

主要参考了 Kubernetes 官方文档中关于 etcd 备份与恢复的说明,以及一些常见的运维实践经验总结。)

在 Kubernetes 集群里,etcd 就像一个超级重要的记事本,里面记录了整个集群的所有家当:比如有哪些 Pod 在跑、服务是怎么配置的、密码密钥放在哪里等等,一旦这个记事本丢了或者写乱了,整个集群可能就瘫痪了,怎么给 etcd 的数据做备份,并且在出问题时能顺利恢复,就成了管理员必须掌握的头等大事。

第一部分:为什么要备份 etcd?

简单说,etcd 存储了 Kubernetes 集群的状态数据,etcd 数据完蛋了,即使你的服务器节点都好好的,Kubernetes 也不知道该怎么管理它们了,整个集群就“失忆”了,导致数据丢失或损坏的原因有很多:比如存放 etcd 数据的硬盘坏了、管理员误操作删了关键数据、升级 etcd 或 Kubernetes 时出了岔子,甚至是病毒勒索软件的攻击,定期备份 etcd 就像是给集群买了一份“保险”。

第二部分:怎么给 etcd 做备份?(备份操作)

备份 etcd 的核心思想,就是在某个时间点,为它的数据拍一张完整的“快照”,这张快照文件需要被安全地保存到 etcd 集群之外的地方,比如另一台机器、云存储或者磁带库。

-

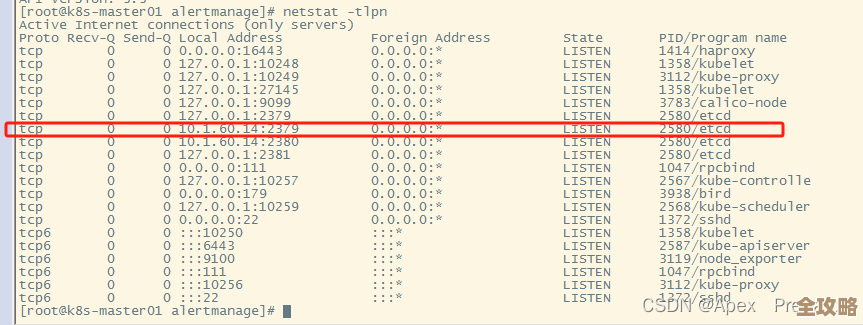

找到关键信息: 你需要知道你的 etcd 是怎么部署的,是自己手动安装的,还是用 kubeadm 这类工具部署的?etcd 的证书、密钥文件放在哪里?监听哪些地址和端口?这些信息通常在 etcd 的配置文件或者 systemd 服务单元文件里能找到,如果是 kubeadm 部署的集群,这些文件通常在

/etc/kubernetes/manifests/etcd.yaml和/etc/kubernetes/pki/etcd/目录下。 -

使用 etcdctl 命令备份: 这是最常用、最直接的方法。

etcdctl是和 etcd 配套的命令行工具。- 你需要准备一些连接 etcd 必需的参数,

--endpoints: etcd 的访问地址,如果是单节点可能是https://127.0.0.1:2379。--cacert,--cert,--key: 用于 TLS 加密认证的证书和密钥文件路径。

- 然后执行备份(快照保存)命令,格式类似这样:

ETCDCTL_API=3 etcdctl --endpoints=$ENDPOINT \ --cacert=/path/to/ca.crt \ --cert=/path/to/etcd-client.crt \ --key=/path/to/etcd-client.key \ snapshot save /path/to/backup/snapshot.db

这个命令会在指定的路径生成一个

snapshot.db文件,这就是你的备份。

- 你需要准备一些连接 etcd 必需的参数,

-

自动化备份: 手动备份太麻烦也容易忘记,最好能写个脚本,定期(比如每天凌晨)自动执行上面的命令,并把生成的快照文件加上日期标签(

snapshot-$(date +%Y%m%d).db),然后自动传输到远端的存储系统,这样可以确保备份的新鲜度和连续性。

第三部分:什么时候需要恢复?以及怎么恢复?(恢复操作)

恢复是最后的手段,是在真的发生数据灾难时才用的,你发现 etcd 的数据完全不可用,或者误删了某个命名空间且无法通过 Kubernetes 自身机制找回,再或者升级失败需要回滚。

重要警告:恢复操作是具有破坏性的! 它会用备份的数据完全覆盖当前 etcd 的数据,恢复前务必确保:

- 你已经有了一个可用的、足够新的备份文件。

- 你理解当前 etcd 集群里的所有数据在恢复后都会被备份点的数据替换。

- etcd 是集群模式(多节点),恢复过程会更复杂,通常需要先停止所有 etcd 节点,在一个节点上从快照恢复,然后以其为基准重新组建新集群,这里我们以常见的单节点 etcd(kubeadm 创建的单机集群)为例,说明基本步骤:

-

停止 kube-apiserver: 因为 kube-apiserver 依赖 etcd,所以先要停止它,避免它在恢复过程中写入新数据,如果是 kubeadm 部署,可以临时移动

/etc/kubernetes/manifests/etcd.yaml和kube-apiserver.yaml文件(Kubernetes 会自动停止对应的 Pod)。mv /etc/kubernetes/manifests/etcd.yaml /tmp/ mv /etc/kubernetes/manifests/kube-apiserver.yaml /tmp/

等待 Pod 确认被删除。

-

清理现有数据: 备份现有的(可能已经损坏的)etcd 数据目录(以防万一),然后清空它,数据目录位置可以在之前的 etcd 配置文件中找到(通常是

--data-dir参数指定的路径,/var/lib/etcd)。

mv /var/lib/etcd /var/lib/etcd.old.bak

-

执行恢复命令: 使用

etcdctl snapshot restore命令,这个命令会读取备份快照,并在指定的数据目录中重建 etcd 数据。ETCDCTL_API=3 etcdctl snapshot restore /path/to/backup/snapshot.db \ --data-dir=/var/lib/etcd \ --initial-cluster=default=https://127.0.0.1:2380 \ --initial-advertise-peer-urls=https://127.0.0.1:2380 \ --name=default

这里的参数需要根据你集群的实际配置进行调整,比如节点名称和网络地址。

-

恢复权限: 确保新恢复的数据目录的 ownership 正确,通常是 etcd 用户和组。

chown -R etcd:etcd /var/lib/etcd

-

重启 etcd 和 kube-apiserver: 将之前移走的 manifest 文件放回原处,Kubernetes 会自动重启这些关键组件。

mv /tmp/etcd.yaml /etc/kubernetes/manifests/ mv /tmp/kube-apiserver.yaml /etc/kubernetes/manifests/

-

验证: 等待 Pod 重启成功,然后使用

kubectl get nodes等命令检查集群状态是否恢复正常,资源是否和备份时的状态一致。

第四部分:避免出错和丢失的注意事项

- 测试!测试!测试! 备份文件好不好用,光生成不行,必须定期做恢复演练,可以找一个测试集群,模拟灾难场景,用备份文件恢复,确保整个流程是通的,不然真到用时发现备份是坏的或者恢复命令不对,就追悔莫及了。

- 备份也要保安全: 备份文件本身包含了集群的所有敏感信息(如密钥),存储和传输时必须加密,并严格控制访问权限,防止泄露。

- 关注版本兼容性: 用新版本的

etcdctl去恢复旧版本 etcd 生成的快照,通常没问题,但反过来可能不行,尽量使用相同或更高版本的客户端工具。 - 考虑集群模式: 对于生产环境的多节点 etcd 集群,备份和恢复流程更复杂,需要严格按照官方文档操作,确保集群一致性。

对待 etcd 数据就要像对待银行金库的钥匙一样,勤备份、妥保管、常演练,才能在真正遇到问题时心里不慌,有条不紊地让集群重获新生。

本文由雪和泽于2026-01-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/84932.html