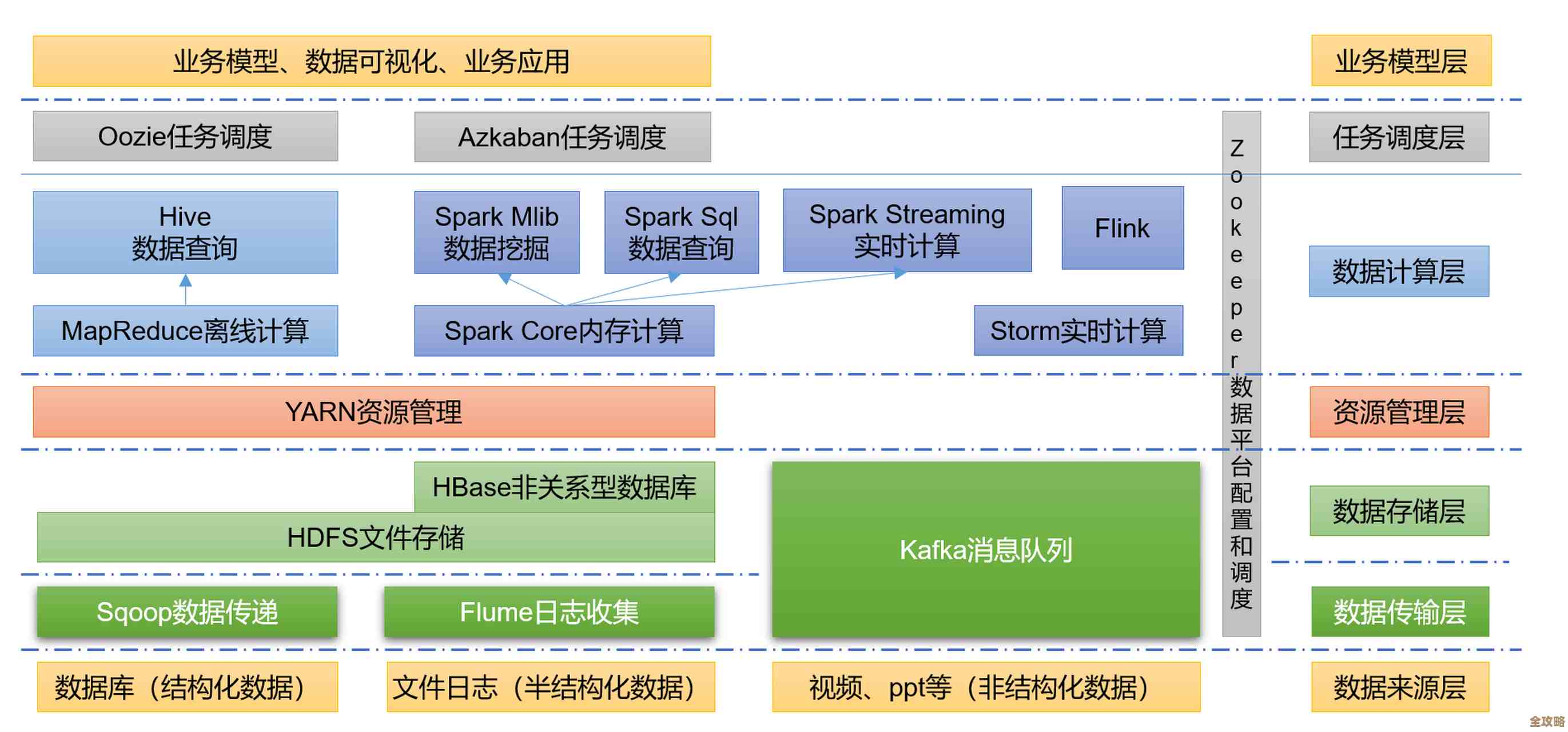

经验聊聊Hadoop分布式文件系统那些架构设计上的关键点和总结心得

- 问答

- 2026-01-20 00:59:00

- 2

聊到Hadoop分布式文件系统,也就是HDFS,它的设计思路其实非常朴实,核心就是为了解决一个问题:怎么用一堆便宜又普通的电脑,来存下海量的数据,并且保证数据不丢、还能被快速处理,它不是为了一台超级计算机设计的,而是为了成百上千台“破铜烂铁”组成的集群,理解了这一点,就能明白它很多看似“奇怪”的设计其实都是不得已而为之的智慧。

第一个关键点,也是基石:一次写入、多次读取的模型。 这个设计是HDFS的灵魂,它假设文件一旦被创建、写入,就不会被修改了,顶多是在文件末尾追加数据,这个假设大大简化了系统的复杂度,你想啊,如果允许随意修改,那就要处理复杂的锁机制、数据一致性等问题,在成百上千台机器上做这个,难度是指数级上升的,HDFS的设计者们发现,像搜索引擎的日志、用户行为数据、海量传感器数据等,绝大部分场景都是写一次,然后被分析程序反复读取,它干脆放弃了随机修改的能力,换来了高吞吐量的数据读写,这就像刻录光盘,刻完就不能改了,但读起来很快,这个设计选择,让HDFS在处理大数据批量计算时表现得非常出色。

第二个关键点,主从架构与元数据管理:NameNode和DataNode的分工。 这是HDFS架构的核心,NameNode是大脑,只有一个(虽然有高可用方案,但逻辑上还是单一大脑),它负责管理整个文件系统的命名空间,也就是文件目录树、文件块放在哪里这些元数据,而DataNode是干活的四肢,有很多个,负责存储实际的数据块。

这里有个非常重要的心得:把元数据和数据本身分开,NameNode只把元数据放在自己内存里,所以它能极快地响应客户端询问“某个文件块在哪儿”这类请求,而实际的数据IO压力,全部分散到各个DataNode上,这就避免了单台机器既要管理目录又要传输数据的性能瓶颈,但这个设计也有个著名的痛点:单点故障,虽然通过Secondary NameNode、JournalNode等技术实现了高可用,但早期版本里如果NameNode宕机,整个系统就瘫痪了,这其实也体现了分布式系统设计中的一个经典权衡:简化管理与保证可靠性之间的博弈,HDFS最初选择了简化管理和高性能,后续再通过更复杂的技术来弥补可靠性的不足。

第三个关键点,数据分块与复制机制。 HDFS会把一个大文件切分成固定大小的块,比如128MB或256MB,这个“分块”思想是分布式存储的精髓,好处太多了:一个文件可以远远大于单块硬盘的容量;一个大文件可以被分散到集群的多个节点上,读写时可以并行操作,速度飞快;也方便了存储空间的管理。

光分块还不够,还得保证数据不丢,HDFS用的是最直接粗暴但有效的方法:多副本复制,默认一个数据块会在不同的机器上存三份,这里面的放置策略也很有讲究:第一个副本放在客户端所在的节点(如果客户端不在集群里,就随机选一个);第二个副本放在另一个机架上的某个节点;第三个副本放在第二个副本相同机架的不同节点上,这个策略的目的就是为了平衡可靠性和网络带宽,既保证了即使整个机架坏了数据也不会丢,又考虑了机架内网络带宽通常比机架间要大的现实,优化了数据读写的效率,这个设计体现了对现实硬件环境(比如网络拓扑)的深刻理解。

第四个关键点,数据可靠性的保证方式。 HDFS不靠昂贵的RAID磁盘阵列来保证数据安全,它用的是软件层面的机制,DataNode会定期向NameNode发送心跳包和块报告,告诉大脑“我还活着,我存了哪些块”,如果NameNode一段时间没收到某个DataNode的心跳,就认为它挂了,然后会自动触发这个节点上数据块的复制任务,从其他副本那里再复制一份到健康的节点上,始终维持设定的副本数,它还会通过校验和来检测数据是否损坏,这种“移动数据到计算节点”比“移动计算到数据节点”要便宜得多,这也是HDFS适合做大数据批处理(如MapReduce)的根本原因之一。

总结心得:

- 设计服务于场景:HDFS的所有特性,无论是优点还是缺点,都源于它最初为大规模、高吞吐量批处理而生的定位,用它来做需要低延迟、频繁更新的在线数据库,那就是用错了地方。

- 简单性是一种力量:“一次写入”模型、简单的副本冗余,这些设计虽然在某些方面有局限,但保证了核心功能的稳定和高效,在分布式系统里,复杂往往意味着容易出错。

- 权衡无处不在:单NameNode带来了性能和管理上的简便,却牺牲了初期架构的可用性,多副本保证了可靠性,但付出了存储空间翻倍的代价,好的架构设计就是在这些矛盾中找到一个最佳的平衡点。

- 考虑硬件故障是常态:HDFS的设计哲学是“假设硬件总会出故障”,它的副本机制、心跳检测、自动恢复等,都是为了在故障常态化的环境下依然能稳定运行,这是一种面向现实的设计智慧。

HDFS的架构是分布式存储领域一个非常经典和成功的范例,它的思想,比如数据分片、多副本、元数据与数据分离,深深影响了后来无数的分布式存储系统,尽管今天有更多更先进的系统出现,但理解HDFS的设计关键点,依然是掌握大数据技术基础的重要一课。

本文由凤伟才于2026-01-20发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/83987.html