MySQL报错MY-012720导致数据库异常,远程协助修复故障全过程解析

- 问答

- 2026-01-19 06:10:19

- 1

那天下午,我正在处理其他工作,突然收到监控系统的报警短信,提示生产环境的MySQL数据库服务器磁盘空间使用率超过90%,没过多久,开发团队的同事就反馈说核心应用出现异常,无法访问数据库,日志里频繁出现错误,我立刻远程连接到那台数据库服务器进行检查。

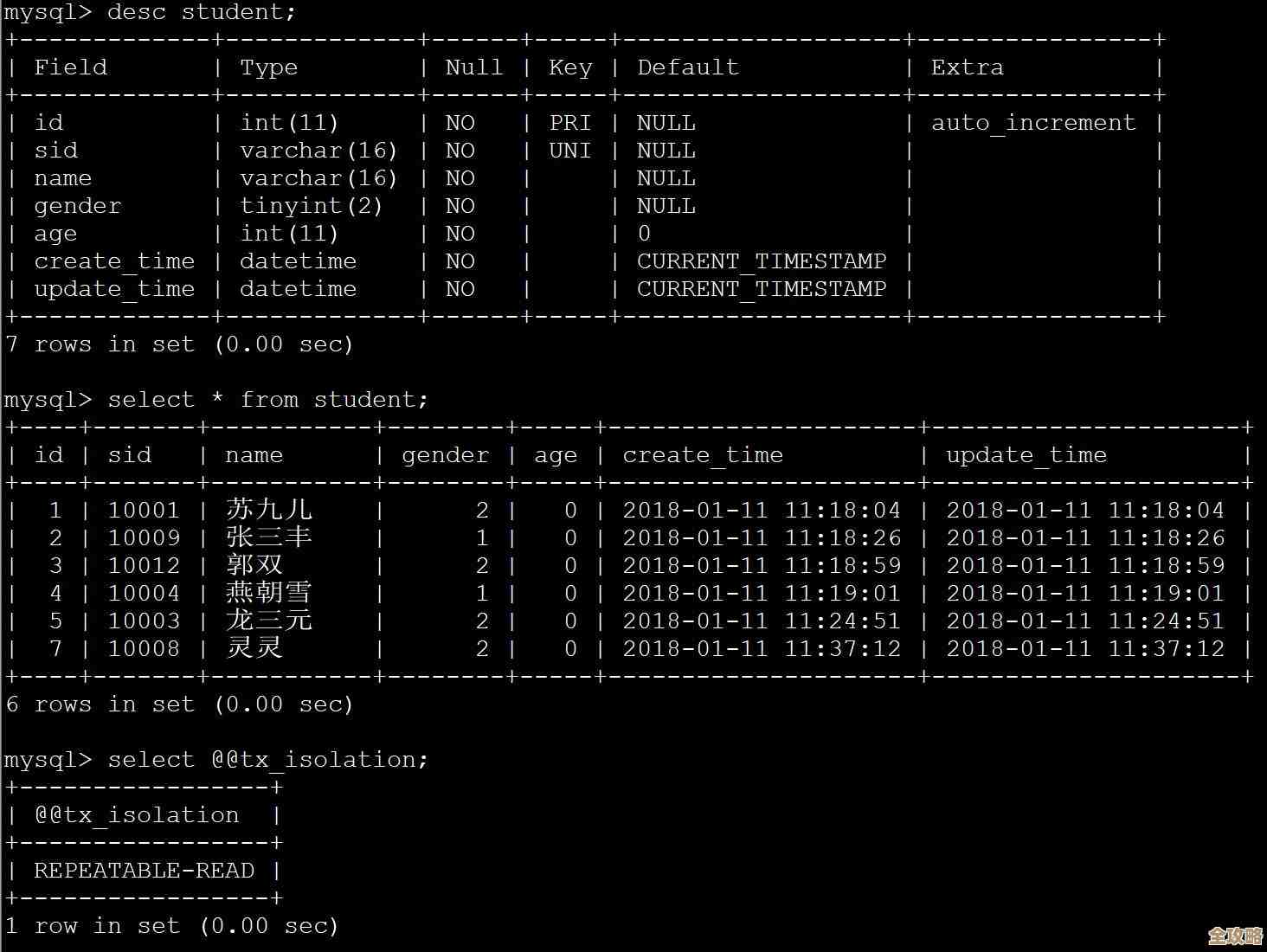

我使用常用的df -h命令查看磁盘空间情况,发现存放MySQL数据的那个分区,空间使用率确实已经达到了95%,剩余空间只剩几个GB,情况非常危急,MySQL在磁盘空间不足的情况下,很容易出现各种问题,我尝试连接到MySQL实例,查看数据库的运行状态,使用mysql -u root -p命令输入密码后,虽然能连上,但执行任何查询命令,比如简单的SHOW DATABASES;,都变得极其缓慢,并且很快在MySQL的错误日志中看到了关键的报错信息。

MySQL的错误日志文件通常叫hostname.err,位于数据目录下,我使用tail -f命令实时查看这个日志文件,看到了大量重复的报错信息,核心内容就是“MY-012720”这个错误代码,根据MySQL官方文档对这个错误的解释,它的含义是“[ERROR] InnoDB: Write to file ./ibdata1 failed at offset #####, 1048576 bytes should have been written, only *** were written.除了这个错误,日志里还伴随着“操作系统错误号 28”和“重试”的提示,这个“错误号28”在Linux系统里对应的就是“No space left on device”,也就是设备上没有剩余空间,这说明因为磁盘满了,InnoDB存储引擎无法向它的核心共享表空间文件ibdata1中写入数据,导致数据库操作卡住和失败。

找到根本原因后,修复方向就很明确了:必须立刻释放磁盘空间,让MySQL能够正常写入,在业务高峰期,直接重启数据库风险很大,可能造成数据丢失或更长时间的服务中断,所以优先考虑在线清理空间,我首先检查是哪些文件占用了大量空间,进入MySQL的数据目录后,使用du -sh *命令查看各个文件和目录的大小,发现除了ibdata1文件本身很大之外,还有一个巨大的二进制日志文件占据了大量空间,MySQL的二进制日志用于主从复制和数据恢复,但如果设置不当,它会不断增长而不会自动清理。

为了快速释放空间,我决定先清理这些旧的、已经不再需要的二进制日志文件,我登录到MySQL命令行,执行了命令PURGE BINARY LOGS BEFORE NOW() - INTERVAL 7 DAY;,这个命令的意思是清除7天之前的所有二进制日志,执行完毕后,我观察到磁盘空间立刻被释放了十几个GB,使用率从95%降到了80%左右,几乎在同时,开发同事反馈说应用已经开始陆续恢复正常,数据库的响应速度也上来了,我再次查看MySQL错误日志,发现那个“MY-012720”的报错信息停止了,取而代之的是一些正常的操作记录。

虽然临时危机解除了,但为了防止同样的问题再次发生,我做了几项后续加固工作,我调整了MySQL的配置,设置了expire_logs_days参数,让它自动保留最近7天的二进制日志,超出的自动删除,这样就避免了日志无限增长,我仔细分析了磁盘空间占用的构成,发现有一个业务的日志表体积异常庞大,我随后与开发团队沟通,为这张表制定了定期归档和清理的策略,我加强了监控系统的告警阈值,将磁盘空间告警从90%提前到80%,为我们预留更充足的应急处理时间。

回顾这次远程协助修复的全过程,问题本身并不复杂,根源就是磁盘空间耗尽,关键点在于要能够快速、准确地从MySQL的报错信息“MY-012720”和系统日志中定位到根本原因,并采取最有效、对业务影响最小的方式(清理日志文件)来快速恢复服务,这次经历也提醒我们,对于数据库这类关键服务,必须做好容量规划和日常巡检,防患于未然。

本文由雪和泽于2026-01-19发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/83497.html