解决Kubernetes存储那些让人抓狂的问题,终于有办法了

- 问答

- 2026-01-15 20:55:32

- 4

“解决Kubernetes存储那些让人抓狂的问题,终于有办法了”

你是不是曾经在深夜里,被Kubernetes的存储问题搞得焦头烂额?Pod莫名其妙地卡在Pending状态,错误信息永远是那句让人摸不着头脑的“FailedAttachVolume”或“FailedMount”?或者更糟的是,你的应用明明显示运行正常,用户却投诉说数据丢了,或者页面一片空白?如果你对这些问题频频点头,甚至已经开始感到血压升高,那么恭喜你,你并不是一个人在战斗,Kubernetes的存储层,确实是许多开发者和运维人员心中“最深的痛”。

但别担心,对付这些“妖魔鬼怪”,我们并非束手无策,今天我们就来聊聊,如何用一些朴实无华但极其有效的方法,把这些烦人的存储问题一个个揪出来解决掉。

第一关:Pod卡住不动了?先从“案发现场”开始勘察

当Pod无法启动时,千万别慌,就像侦探破案一样,我们需要收集线索,第一步,永远是从最简单的命令开始,根据一篇名为《Kubernetes存储问题排查指南》的技术文章建议,我们可以按顺序执行以下命令来获取关键信息:

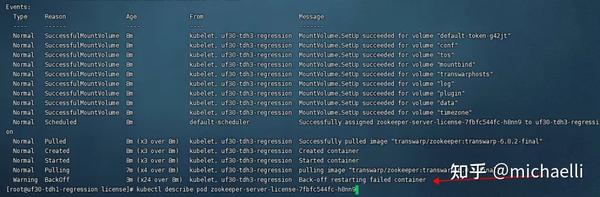

kubectl describe pod <pod-name>:这是你的首要工具,仔细查看“Events”部分,这里通常会直接告诉你问题所在,Unable to mount volumes”(无法挂载卷)或“Volume is already attached to another node”(卷已被挂载到其他节点),这些信息是破案的关键线索。kubectl get pv和kubectl get pvc:检查PersistentVolume(PV)和PersistentVolumeClaim(PVC)的状态,PVC是不是一直处于“Pending”状态?这可能意味着没有合适的PV能满足它的要求(比如存储大小或访问模式),PV的状态是“Bound”(已绑定)还是“Available”(可用)?如果PVC在Pending,而PV是Available,那可能是标签选择器不匹配等问题。kubectl describe pvc <pvc-name>:如果PVC是Pending,查看它的详细信息,Events部分会告诉你为什么无法绑定,no persistent volumes available for this claim”(没有可用的持久化卷用于此声明)。

通过这三板斧,大部分简单的配置错误,比如PVC声明的存储大小超过了PV的容量,或者访问模式(例如ReadWriteOnce只能被单个节点挂载)不匹配,都能被迅速发现。

第二关:数据怎么不见了?警惕“幽灵”卷和多副本陷阱

如果说Pod启动不了是“急症”,那数据丢失就是“内伤”,更让人头疼,这种情况常常发生在有状态应用(比如数据库)或多副本部署中。

一个非常经典的“坑”是:你部署了一个MySQL数据库,并使用了动态供给的持久化存储,某天,你一不小心删除了这个Pod,Kubernetes的控制器会立刻尝试重建一个新的Pod来满足你的部署需求,新的Pod被调度到了集群中的另一个节点上,并且成功绑定了一个新的PVC和PV,看起来一切正常,对吧?但当你连接数据库时,却发现里面空空如也!这是因为新Pod挂载的是一个“全新的、空的”存储卷,而不是之前那个存有数据的卷,原来的数据还安静地躺在原来的PV里,但新Pod已经和它失去了联系。

如何避免这种“惨剧”?核心在于理解“有状态”和“无状态”的区别,对于有状态应用,你必须使用StatefulSet而不是Deployment,StatefulSet会为每个Pod实例维护一个稳定的、唯一的标识符和与之绑定的存储卷,即使Pod被重建,Kubernetes也会确保它能够挂载回“属于它自己”的那个数据卷,从而保证数据的持久性,一篇来自知乎专栏《Kubernetes实战笔记》的文章强调,这是设计架构时就必须考虑清楚的关键点。

第三关:性能慢如蜗牛?可能是存储后端的“锅”

所有配置看起来都正确,Pod正常运行,数据也没丢,但应用的读写速度却慢得让人无法忍受,这时候,问题的根源很可能不在Kubernetes本身,而在底层存储系统。

你使用的网络存储(如NFS)可能正经历着网络带宽瓶颈或服务器端的高负载,或者,你选择的云服务商提供的块存储(如AWS的gp2/gp3)其IOPS(每秒读写次数)性能不足,无法满足你应用的高并发需求。

排查这类问题,需要跳出Kubernetes,从更底层入手:

- 检查存储后端的监控指标:查看你的NFS服务器、云硬盘的性能监控图表,看看是否存在明显的带宽或IOPS瓶颈。

- 调整存储类别(StorageClass):在云环境下,通常可以通过修改StorageClass的参数来动态提升存储性能,比如增加预配置的IOPS,这通常也意味着更高的成本。

- 考虑本地存储:对于性能要求极高的场景,如果允许,可以考虑使用Local Persistent Volume(本地持久化卷),将数据直接存储在Pod所在节点的本地硬盘上,避免网络开销,但这牺牲了Pod可随意调度的灵活性。

终极武器:养成良好的“存储习惯”

预防永远胜于治疗,要减少存储问题,最好的办法是养成良好的设计和运维习惯:

- 清晰标注:为你的PV、PVC和StorageClass打上清晰的标签(Labels),方便管理和排查。

- 资源配额:在命名空间中设置存储资源配额,防止某个应用意外申请过多存储资源,导致其他应用无法正常工作。

- 备份!备份!备份!:重要的事情说三遍,无论你的存储架构多么健壮,定期备份PV中的数据都是必须的,可以使用Velero等工具来实现集群资源和持久化数据的整体备份与恢复。

解决Kubernetes存储问题并没有一招鲜的秘籍,它更像是一个需要耐心和细心的排查过程,关键在于掌握正确的排查思路:从Kubernetes资源状态入手,结合事件日志,逐步缩小范围,最终定位到是配置错误、架构设计问题还是底层存储的瓶颈,当你下次再遇到让人抓狂的存储问题时,不妨深呼吸,然后按照这个流程一步步来,你会发现,问题终将迎刃而解。

本文由黎家于2026-01-15发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/81383.html