服务器跑大型数据库内存突然飙升,感觉快撑不住了,得想办法优化下

- 问答

- 2026-01-14 04:36:59

- 3

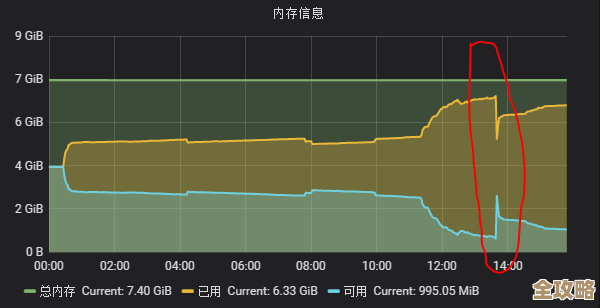

那天下午,监控系统突然发出刺耳的警报声,我一看,服务器的内存使用率像坐了火箭一样,从平时的60%猛地冲到了95%,而且还在往上爬,负责跑大型数据库的那台机器眼看就要撑不住了,屏幕上红色的警告条不断闪烁,我心里咯噔一下,这下麻烦大了。

这可不是小事,数据库是很多业务的核心,它要是因为内存耗尽而卡死甚至崩溃,前台的应用就会全部瘫痪,用户没法下单,也没法查询数据,那损失可就大了,我赶紧先找了个临时的办法,重启了数据库服务,让内存使用率暂时降了下来,但这完全是治标不治本,问题肯定还会再出现,我必须得找出原因,然后从根本上优化。

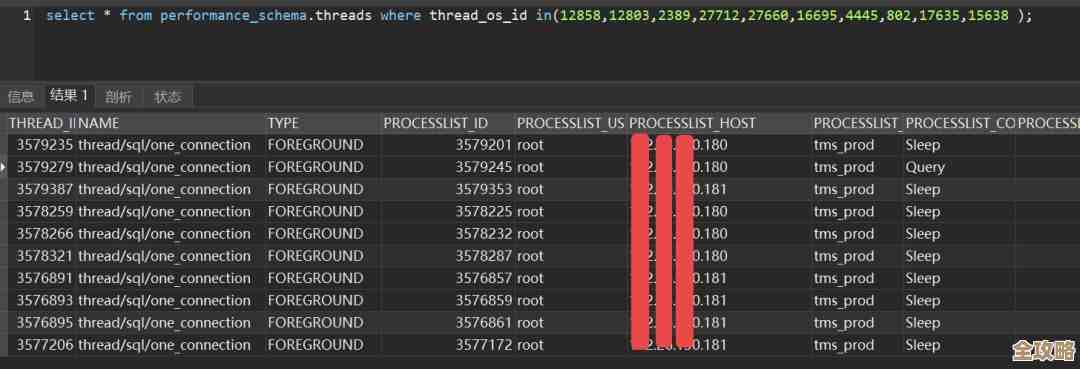

静下心来,我开始像侦探一样排查问题,首先想到的是,是不是最近业务量突然暴增了?我赶紧去查了查最近一周的访问日志和数据处理量,结果发现,虽然业务确实有缓慢增长,但远远没到能让内存瞬间飙升好几倍的程度,这个可能性暂时排除了。

我把目光转向了数据库本身,我打开了数据库的慢查询日志,这东西就像是一个黑匣子,记录了所有执行起来特别慢的SQL语句,一条条看下去,果然发现了问题,有几条给运营部门做大数据分析用的查询语句写得非常复杂,关联了七八张表,而且没有很好地用到索引,这就好比你要在一個巨大的图书馆里找一本特定的书,本来可以通过索引卡快速定位,但现在却需要把整个图书馆的书架从头到尾翻一遍,不仅慢,而且极其消耗体力(对数据库来说就是内存和CPU),这些“坏”查询平时偶尔跑一次可能还行,但如果同时有多个这样的查询在执行,就会像几个大胃王同时抢饭吃,很快就把内存资源消耗殆尽。

我还检查了数据库的缓冲区设置,数据库为了提速,会把经常用到的数据块放在内存的一个特定区域里,叫做缓冲池,这个池子的大小是可以在配置文件中设置的,我检查了一下当前的配置,发现这个值还是两年前根据当时的业务量设定的,现在数据量已经翻了好几倍,但这个池子的大小却没变,这就好比你的衣柜还是小时候的尺寸,却要塞进现在成年人的衣服,肯定塞不下,很多衣服只能堆在外面(也就是磁盘上),每次换衣服都得临时去翻找,效率极低,而且显得非常杂乱(内存频繁交换,导致效率低下和内存浪费)。

除了这些,我还怀疑是不是有什么不起眼的内存泄漏,就是有些程序申请了内存,但用完之后忘了释放,久而久之,可用内存就越来越小,虽然数据库软件本身通常很稳定,但我们自己写的一些用于数据清洗和同步的脚本,或者某些第三方插件,就有可能是罪魁祸首,这个排查起来比较费劲,需要长时间监控内存分配的情况。

原因找得差不多了,接下来就是动手优化,我首先做的就是优化那几条罪魁祸首的SQL语句,我和写这个查询的同事沟通,一起分析了执行计划,帮他们重写了查询,增加了必要的索引,这就好比给那个在图书馆乱翻的人一张精确的索书号,让他能直捣黄龙,效率瞬间提升,也不再浪费体力。

我根据当前服务器的物理内存大小和数据库的实际数据量,谨慎地调整了缓冲区的大小,我并没有一下子调到最大,而是采用“小步快跑”的方式,每次调整一点,观察一段时间的效果,避免矫枉过正,反而影响系统其他部分的运行,这个调整就像是给数据库换了一个更合身的大衣柜,让它能把最常穿的衣服都整齐地挂起来,随用随取。

我建立了一个更严格的监控机制,不仅监控总的内存使用率,还细分到监控那些长时间运行的慢查询,设置阈值,一旦有查询超过规定时间就自动告警,让我们能第一时间介入处理,也对那些自定义脚本的运行加强了监控,确保它们不会在背后偷偷“吃掉”内存。

经过这一系列的排查和优化,服务器的内存使用率终于稳定在了一个安全又合理的水平,警报再也没有无故响起过,这次经历让我深刻体会到,维护大型数据库就像照顾一个活物,不能设置好就放任不管,需要持续观察、细心调优,才能保证它健康平稳地运行。

本文由歧云亭于2026-01-14发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/80345.html