数据库变更捕捉到底是啥,怎么用起来方便又高效?

- 问答

- 2026-01-13 04:07:36

- 12

数据库变更捕捉,说白了,就是给你的数据库装上一个“监控摄像头”外加一个“忠实记录员”,它的核心任务非常简单:死死盯住数据库里你指定的那些数据表,一旦有任何数据发生变化——无论是新增了一条记录、修改了某条记录的内容,还是删除了某条记录——它都能立刻察觉到,并且把这次变动的“罪证”详详细细地记录下来。

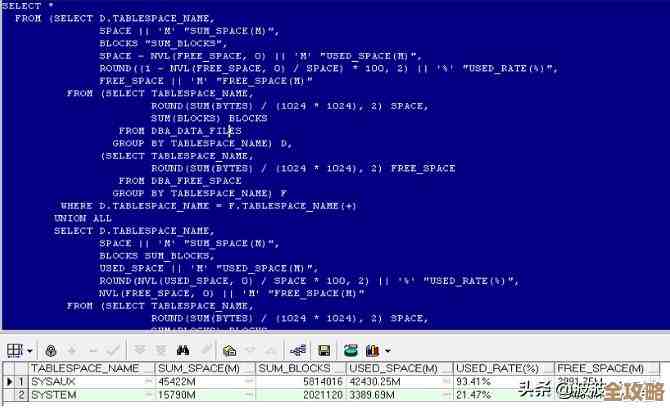

这个记录可不是简单的“有人动了数据”这么笼统,它会记下非常关键的信息,到底是哪张表被改了?被改的是哪一行数据(通常用主键标识)?具体是什么操作(增、删、改)?改动发生的确切时间是什么时候? 如果是更新操作,它甚至能同时记录下改动前的旧数据长什么样,和改动后的新数据长什么样,所有这些记录下来的变更信息,都会被按顺序保存到一个特定的地方,就像一本按时间顺序书写的“数据库变更日记”。

这个东西到底有啥用呢?为什么说它方便又高效?我们得从它解决的痛点说起。

在没有这个“监控摄像头”的年代,如果你想同步数据,或者想知道数据是怎么一步步变成现在这样的,会非常麻烦,最常见的场景是数据同步,你的核心业务数据库(比如订单库)压力很大,但有些部门(比如财务或数据分析部门)需要用到这些数据来做报表或分析,你不可能让他们直接去查核心库,那样会把核心库拖慢甚至拖垮,传统的做法是,每天夜里等业务不忙的时候,把整个数据库或者一部分表全量导出一份,再导入到另一个给报表用的数据库里,这种方式有几个大问题:第一,延迟高,财务看到的永远是昨天的数据,看不到今天的实时情况;第二,效率低,哪怕只改了一行数据,也要把整张表甚至整个库重新导一遍,浪费大量计算和存储资源;第三,对原数据库压力大,全量导出操作本身就很消耗数据库的性能。

而用了数据库变更捕捉,情况就完全不一样了,它不再是定时“拍快照”,而是实时“录视频”,任何数据变动一发生,就会被立刻捕捉到,然后几乎实时地应用到目标数据库(比如报表库)中,这样,数据分析师看到的几乎就是实时数据,更重要的是,它只同步变化的部分,增量操作,效率极高,对源数据库的压力也微乎其微。

除了数据同步,它还有几个非常厉害的用处:

-

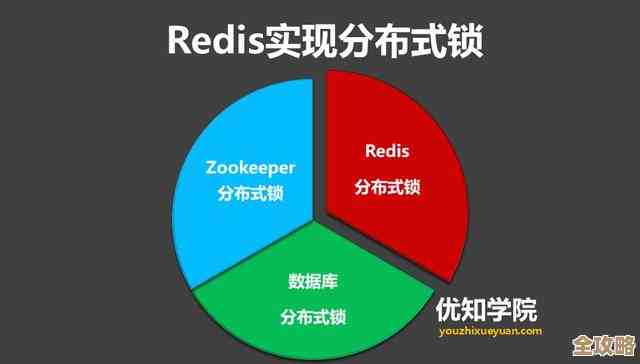

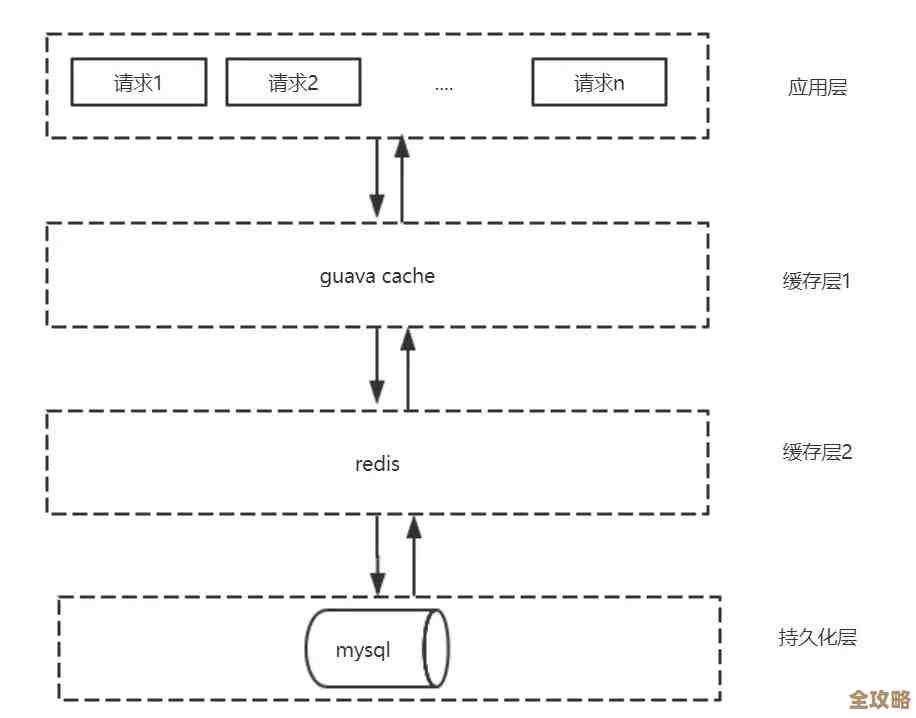

缓存更新:现在网站为了提高速度,普遍使用Redis这类缓存,当数据库里的商品信息、用户信息更新后,如何让缓存里的数据也一起更新?用变更捕捉是最优雅的方式,数据库一变,监听到变化,立刻去清理或更新对应的缓存,保证数据一致性。

-

搜索索引构建:像Elasticsearch这样的搜索引擎,它的数据来源也是数据库,用变更捕捉,可以实现数据库增删改的同时,搜索引擎里的索引也自动更新,实现真正的实时搜索。

-

审计和追溯:这是变更捕捉的“老本行”,有了那本详细的“变更日记”,你可以轻松查出来任何一个数据是谁、在什么时候、从什么值改成了什么值,对于金融、电商等对数据安全要求高的行业,这是必不可少的审计工具。

-

微服务架构下的数据解耦:在复杂的微服务系统里,一个业务动作可能导致多个服务的数据需要更新,如果让服务之间直接互相调用,会搞得一团乱麻,这时,可以用变更捕捉:订单服务只管更新自己的数据库,变更捕捉监听到订单变化后,发一个“订单已创建”的消息到消息队列,其他服务(如库存服务、积分服务)自己订阅这个消息去处理自己的事,这样服务之间就解耦了,非常清晰。

那怎么用起来才方便高效呢?根据资料(如阿里云DTS、Debezium等开源项目的设计思路),关键在于以下几点:

第一,选择合适的实现方式。 数据库变更捕捉主要有几种技术流派:

- 基于查询:定时去扫描表,根据时间戳或自增ID判断哪些数据变了,这种方式简单,但延迟高,不实时,而且频繁扫描对数据库有压力,不算高效。

- 基于触发器:在数据库里为每张表创建触发器,数据一变,触发器就动作,将变更写入另一张日志表,这种方式是实时的,但对源数据库性能有影响,因为每个SQL都要额外执行触发器的逻辑。

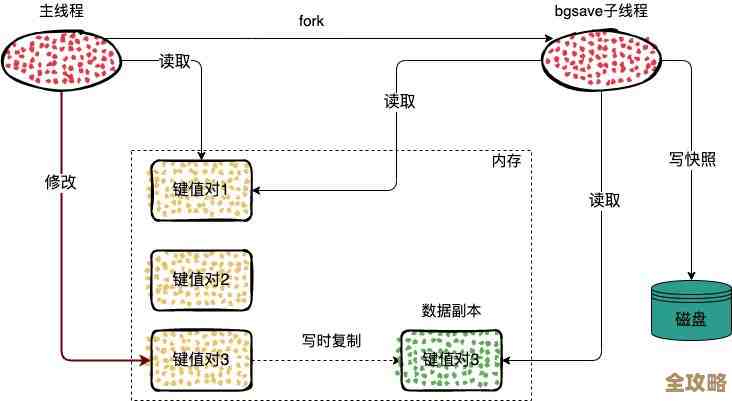

- 基于日志:这是目前最主流、最高效的方式,它直接去数据库的事务日志(比如MySQL的binlog,PostgreSQL的WAL)里读取变更,数据库本身就会把所有变更详细地记录在这个日志里(主要用于主从复制和崩溃恢复),变更捕捉工具就像一个小跟班,在不影响数据库正常业务的情况下,静静地“尾随”读取这个日志,然后解析出变更内容,这种方式对源数据库性能影响极小,而且是真正的实时,像开源的Debezium、阿里巴巴的Canal,都是基于这个原理。

第二,利用好现成的工具,避免重复造轮子。 现在有非常多成熟的开源和商业工具,大大降低了使用门槛,你不需要自己去解析复杂的数据库日志,Debezium就是一个非常流行的开源项目,它支持多种数据库,帮你搞定连接、日志解析、数据格式转换等脏活累活,最后把变更事件以标准化的格式(通常是JSON)发到Kafka这样的消息队列里,你只需要写代码消费这些消息就行了,云服务商(如AWS DMS, 阿里云DTS)则提供了全托管的服务,你几乎只需要点几下鼠标配置源库和目标库,它就能帮你自动完成同步和变更捕捉,连服务器都不用管,最为省心。

第三,设计好下游数据处理逻辑。 捕捉到变更事件只是第一步,如何消费这些事件才是业务价值所在,你需要考虑:

- 幂等性:由于网络等问题,同一条变更消息可能会被重复消费,你的处理程序要保证,即使收到重复消息,也不会导致数据错乱,执行“插入”操作前先判断一下数据是否已存在。

- 顺序性:对于同一行数据的变更,必须保证“先发生的变化先处理”,比如必须先处理“余额从100改为90”,再处理“余额从90改为80”,顺序错了结果就全乱了,好消息是,大多数基于日志的工具都能保证单表分区内的顺序。

- 容错与监控:你的消费者程序可能会挂掉,重启后要从断点继续消费,不能漏数据,同时要有监控报警,一旦发现同步延迟变大或中断,能马上知道。

数据库变更捕捉是一个极其有用的“基础设施”,它通过实时、增量地捕捉数据变化,为数据同步、缓存更新、系统解耦、审计追溯等场景提供了高效、低延迟的解决方案,要想用得方便高效,核心是选择对源库影响小、基于日志的成熟工具(如Debezium或云服务),并设计好能够应对重复、乱序等问题的下游数据处理逻辑,一旦搭建起来,它就像一条畅通无阻的数据高速公路,让数据在各种应用之间顺畅、实时地流动起来。

本文由歧云亭于2026-01-13发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/79708.html