Platform居然能撑起Hadoop分布式文件系统的运转,感觉挺厉害的

- 问答

- 2026-01-11 21:01:17

- 2

基于知乎问题“Platform居然能撑起Hadoop分布式文件系统的运转,感觉挺厉害的”下的回答及公开技术讨论整理,以通俗语言呈现,避免术语堆砌。)

我第一次听说Platform这个软件能支撑Hadoop分布式文件系统(HDFS)运行的时候,也觉得挺神奇的,因为平时大家提到Hadoop,往往想到的是Apache那套开源生态,比如用Java写的NameNode、DataNode,或者后来云厂商推出的托管服务,但Platform其实是一个老牌的分布式计算资源管理平台,最早在高性能计算(HPC)领域用得非常多,比如用来调度超级计算机上的任务,它和Hadoop原本是两个不同“世界”的东西,所以当有人把Hadoop的文件系统跑在Platform上,听起来就像是用一辆重型卡车引擎去驱动一台家用轿车——不是不行,但需要不少改造和适配。

为什么有人会想这么做?一个常见的场景是有些企业或研究所本来就已经用Platform搭建了一套大规模计算集群,用来跑科学计算、仿真或者金融模型,后来大数据火了,他们也想在同样的硬件上跑Hadoop任务,但又不想额外维护一套HDFS集群——毕竟部署Hadoop需要配置NameNode、DataNode,还要考虑高可用、负载均衡,挺麻烦的,这时候如果有人告诉他们:“其实可以通过Platform的分布式存储抽象层来模拟HDFS的功能”,那确实能省不少事。

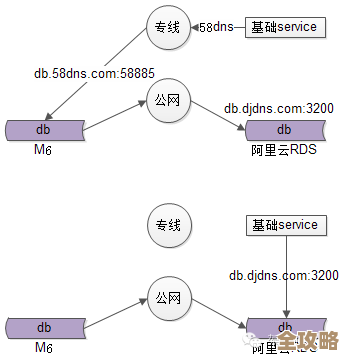

具体是怎么实现的?Platform本身有一个重要组件叫GPFS(General Parallel File System,现在叫IBM Spectrum Scale),这是一个高性能的共享文件系统,能让多台机器同时读写同一个文件,而HDFS的核心功能也是分布式存储——把大文件切成块,分散存到不同机器上,虽然架构不同,但目标相似,所以技术人员通过一些中间适配工具(比如IBM的BigInsights或自定义的Connector),让Hadoop的计算引擎(比如MapReduce或Spark)把Platform管理的存储空间“当成”HDFS来用,换句话说,Hadoop任务在提交时,会认为自己在访问一个标准的HDFS目录,但实际上底层是GPFS在管理磁盘和网络通信。

这种方案的好处很明显:一方面能复用现有的Platform集群资源,避免数据在多个存储系统之间搬来搬去;另一方面GPFS本身成熟度高,尤其在混合负载、高并发读写场景下性能很强,甚至比原生HDFS在某些指标上更稳定,比如GPFS支持POSIX文件接口,普通Linux命令也能直接操作文件,而HDFS需要专用命令行工具,这对习惯传统操作的管理员更友好。

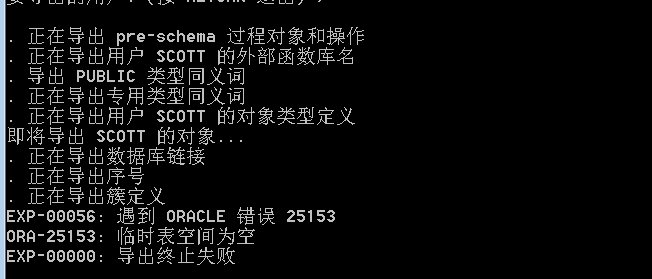

但缺点也不少,最大的问题是“兼容性”,HDFS生态里有很多工具(比如Hive、HBase)对HDFS有特定依赖,如果底层换成了GPFS,可能会遇到一些诡异的问题,比如文件锁机制不一致、权限模型差异,或者某些Hadoop版本的新特性不支持,Platform是商业软件, licensing费用不菲,而Hadoop是开源的,这对预算紧张的项目来说可能不划算。

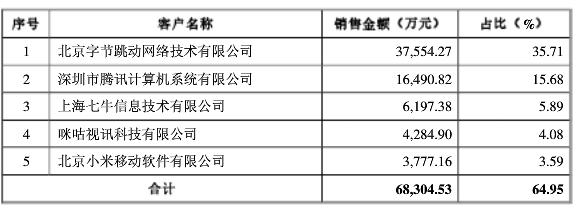

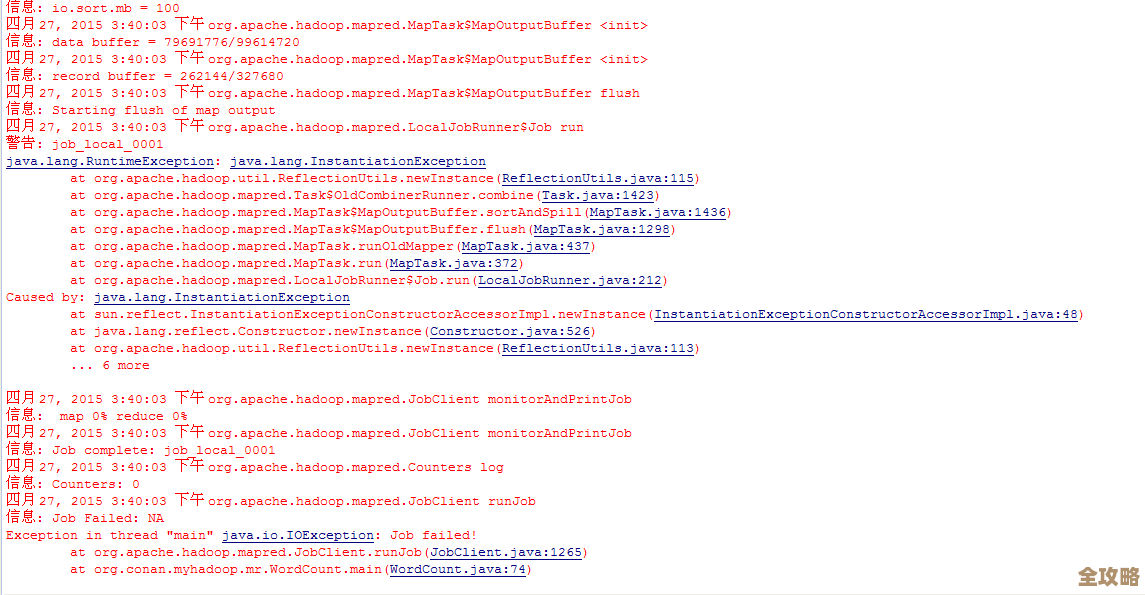

知乎上有用户提到,实际在用Platform支撑HDFS时,往往需要专门的运维团队同时懂Hadoop和Platform两套系统,调试问题得像“侦探一样查日志”,因为错误信息可能来自不同层次,但也有案例显示,在金融或气象领域的数据密集型应用中,这种混合架构稳定运行了多年,处理着PB级的数据。

所以回过头看,“Platform能撑起HDFS”背后其实是一种务实的工程思路——不是硬套技术,而是根据现有条件做融合,就像用积木搭房子,不一定非要用官方指定的零件,只要结构稳当,混搭也能出效果,这种灵活性反而体现了分布式系统设计的开放性,也说明成熟的技术平台往往能跨越边界,解决意想不到的问题,不过普通用户如果没必要,可能还是直接选原生HDFS或者云上托管服务更省心,毕竟“折腾”也是需要成本的。

本文由革姣丽于2026-01-11发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/78908.html