带你了解那些让K8s集群不容易崩溃的实用方法和技巧

- 问答

- 2026-01-09 16:27:50

- 3

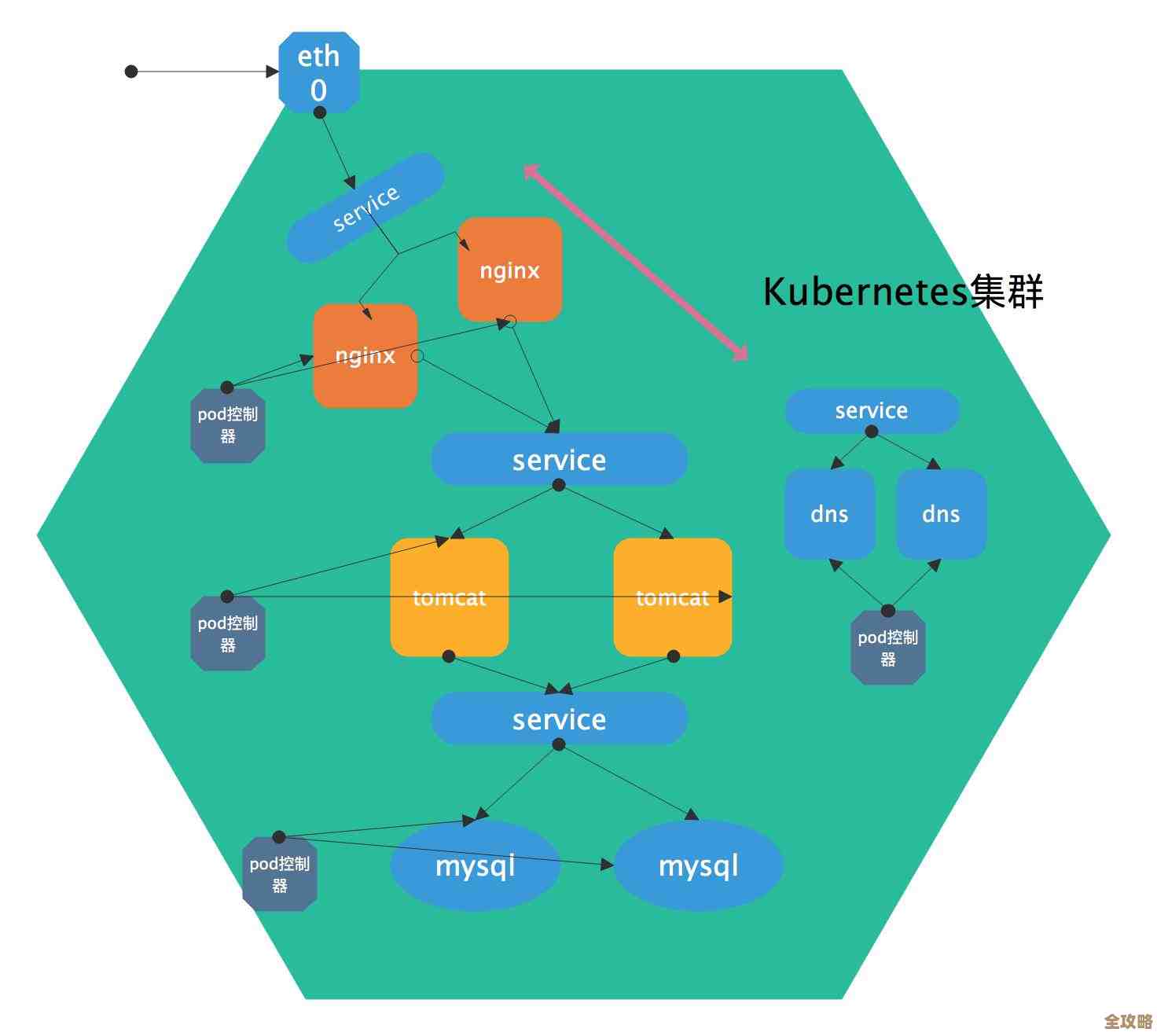

要让一个K8s集群稳定运行,不容易出问题,不能只靠运气,而是需要一些实实在在的方法和日常养成的良好习惯,这就像保养一辆汽车,定期检查、正确操作才能避免它半路抛锚,下面我们就来聊聊这些实用的技巧。

第一,给资源设定合理的“边界”。 这是最基本也是最重要的一步,在K8s里,如果我们不告诉一个应用(Pod)它最多能使用多少内存和CPU,它可能会像个贪吃鬼一样,无限地占用工作节点(Node)的资源,直到把这个节点“撑死”,导致节点上所有其他应用都崩溃,我们一定要为每个Pod定义资源请求(requests)和资源上限(limits),请求是保证这个应用至少能分到的资源,上限是绝不允许它超过的量,这样,调度器在安排Pod时心里有数,不会把Pod塞进一个已经资源紧张的节点;即使某个应用发疯似的想吃光资源,也会在达到上限时被系统强行制止,保护了同一个节点上的“邻居”们,这个原则在“Kubernetes官方文档”和几乎所有运维实践中都被反复强调。

第二,用好“活性探针”和“就绪探针”这两大健康卫士。 K8s不是一个简单的启停工具,它很智能,可以持续监控应用的健康状态,活性探针(liveness probe)就像个医生,定期检查应用的心脏是否还在跳动,如果检查失败,K8s会认为这个应用已经“死”了,它会毫不犹豫地重启这个Pod,尝试恢复服务,而就绪探针(readiness probe)则像个门卫,它检查应用是否已经准备好了,可以接收外部的流量,如果应用正在启动、加载大量数据或者暂时过载,就绪探针会失败,这时K8s会把这个Pod从接收流量的服务列表中暂时移除,等它准备好再加回来,这样既能避免用户请求被发送到一个还没准备好的应用上导致报错,也给了应用自我调整的时间,正确配置这两个探针,能极大地提高服务的自愈能力和用户体验。

第三,实施有效的“资源限制和配额”管理。 光管好单个Pod还不够,我们还需要在更大的范围内防止资源被滥用,K8s提供了命名空间级别的资源配额(ResourceQuota)和限制范围(LimitRange)功能,我们可以为一个测试环境命名空间设置总的CPU和内存使用上限,防止测试人员部署过多的应用把整个集群资源耗光,影响到生产服务,限制范围则可以为一个命名空间内的所有Pod设置默认的资源限制,避免有人忘记设置而埋下隐患,这相当于在个人自律的基础上,又加上了团队预算和公司规章,实现了多层次防护。

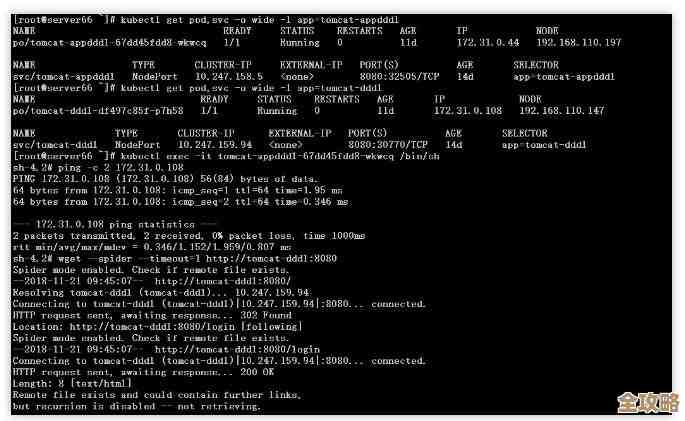

第四,建立清晰的“节点中断和处理”预案。 集群中的服务器(节点)不可能永远不坏,硬件会老化,系统需要升级,K8s设计了“污点”和“容忍度”的机制来优雅地处理这个问题,我们可以给一个计划要维护的节点打上“污点”,这样新的Pod就不会被调度上去,对于已经运行在该节点上的Pod,我们可以使用“驱逐”命令,让K8s安全地将它们迁移到其他健康的节点上运行,实现不中断服务的维护,还可以部署类似“集群自动伸缩”的功能,当资源不足时自动扩容新节点,当资源闲置时缩容以节省成本,让集群具备弹性。

第五,不能忽视“日志和监控”这只眼睛。 一个看不到内部情况的集群是危险的,我们需要搭建完善的监控系统(如Prometheus+Grafana组合)和日志收集系统(如ELK栈),监控面板能让我们实时看到集群的资源使用率、应用的状态、错误率等关键指标,一旦有异常趋势就能提前发现并处理,而不是等问题爆发,集中日志则让我们在出问题时能快速定位故障根源,就像飞机的黑匣子一样重要。

第六,严守“权限最小化”的安全原则。 不安全,何谈稳定?一个被入侵的集群随时可能崩溃,必须使用RBAC(基于角色的访问控制)为不同的用户和服务账户分配最小必需的权限,一个只负责查看日志的应用,绝不应该有关闭Pod或访问机密的权限,要及时更新K8s版本和打上安全补丁,堵住已知漏洞。

养成“良好部署”的习惯。 避免一次性把所有实例都更新掉,而是采用滚动更新策略,慢慢用新版本替换旧版本,万一新版本有问题可以快速回滚,使用Helm等工具来模板化管理应用部署配置,确保环境的一致性。

让K8s集群保持稳定不是一个高深莫测的黑魔法,而是由一系列扎实的基础实践构成的,从给资源设限,到健康检查,再到全局监控和安全管控,每一步都是在为集群的稳健运行添砖加瓦,只要我们坚持这些方法和技巧,就能大大降低集群崩溃的风险,睡个安稳觉。

本文由芮以莲于2026-01-09发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/77538.html