数据库论文的总结和分析,带着具体案例一步步讲清楚内容和重点

- 问答

- 2026-01-08 20:41:49

- 14

我们今天要讲的这篇论文非常有名,可以说是大数据时代的基石之一,它发表于2004年,由谷歌公司的工程师撰写,标题是 《MapReduce: Simplified Data Processing on Large Clusters》,这篇论文解决了一个核心问题:当数据量大到一台电脑根本存不下、算不动的时候,我们该怎么办?

论文要解决的核心问题(背景)

在谷歌那样规模的互联网公司,每天都会产生海量的数据,比如网页内容、用户搜索记录、点击行为等,这些数据可能高达数百TB甚至PB级别,要对这些数据进行分析(统计每个单词在所有网页中出现了多少次”),传统的计算方法完全行不通,因为:

- 数据太大:没有一台超级计算机能装下所有数据。

- 容易出错:在成百上千台普通电脑上同时进行计算,随时可能有电脑宕机,如何保证计算任务能顺利完成?

谷歌需要一种新的编程模型,能让普通程序员即使不了解分布式系统的复杂细节(比如网络通信、故障恢复),也能轻松写出程序,在成千上万台机器上高效、可靠地处理海量数据。

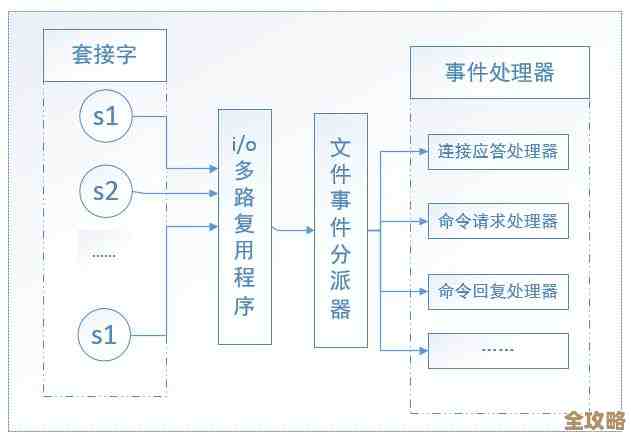

核心思想:MapReduce模型(内容)

这篇论文提出的解决方案叫做“MapReduce”,这个名字听起来很高深,但其实它的思想非常直观,我们可以把它类比成一个“工厂的流水线作业”。

这个模型只要求程序员写两个简单的函数:Map函数 和 Reduce函数,剩下的所有复杂工作,比如把数据拆开、把任务分发给不同的机器、管理机器之间的通信、处理机器故障等,全部由一个统一的“MapReduce框架”自动完成。

我们用一个具体的例子来贯穿讲解:统计一个超大型图书馆里所有藏书中,每个单词出现的总次数。

第一步:Map(映射)—— “化整为零,各自为战”

- 你的任务(写Map函数):你只需要写一个非常简单的程序,这个程序的功能是:输入一本书的一行文字,输出一堆

[单词, 1]的键值对。- 输入:“apple banana apple”

- 输出:

[apple, 1],[banana, 1],[apple, 1]

- 系统的工作:MapReduce框架会自动把图书馆里所有的书(海量数据)分成很多个小块(比如每100页一块),它启动很多个“Map工人”,每个工人领一小块数据,并执行你写的那个Map函数。

- 结果:成千上万个Map工人同时工作,很快就把所有书都处理完了,生成了海量的、中间态的

[单词, 1]记录,这个过程就像把原材料(书本文字)加工成了标准的半成品(带计数1的单词)。

第二步:Shuffle(洗牌)—— “物以类聚”

这是框架自动完成的,程序员不用管,系统会把所有Map工人产生的中间结果收集起来,然后根据“单词”进行排序和分组,把相同的单词聚集到同一个地方。

- 所有

[apple, 1]的记录被送到一个篮子,所有[banana, 1]的记录被送到另一个篮子。

第三步:Reduce(归约)—— “汇总求和”

- 你的任务(写Reduce函数):你再写一个简单的程序,这个程序的功能是:输入一个单词和它对应的所有“1”的列表,输出这个单词的总和。

- 输入:

[apple, [1, 1, 1, ...]](这个列表非常长) - 输出:

[apple, 12654](表示“apple”这个词在全部书籍中出现了12654次)

- 输入:

- 系统的工作:框架启动很多个“Reduce工人”,每个工人领取一个或几个“单词篮子”,并执行你写的Reduce函数,进行求和计算。

- 结果:所有Reduce工人计算完毕,最终结果就是每个单词及其出现的总次数。

重点与创新点分析(分析)

这篇论文的伟大之处不在于Map和Reduce这两个概念本身(它们源于函数式编程),而在于它工程上的完美实现和简化。

-

自动化与简化:它把分布式计算的复杂性(数据分区、任务调度、节点通信、容错处理)封装在了一个简单的接口背后,从此,数据分析师只需要关心他们自己的业务逻辑(即Map和Reduce函数怎么写),而不用成为分布式系统专家,这极大地降低了门槛。

-

强大的容错能力:这是论文的一个重点,在几千台机器的集群中,随时可能有机器变慢或宕机,MapReduce框架如何应对?

- Worker故障:主节点会定期检查各个工人的工作状态,如果一个工人长时间没有响应,主节点就认为它坏掉了,然后自动把它未完成的任务重新分配给另一个空闲的工人,因为Map任务的结果是存储在本地磁盘的,可以重新计算。

- 优雅的重复处理:由于中间结果可能因机器故障而丢失,重新执行任务是最简单可靠的策略,框架确保了即使有故障,最终结果也是正确的。

-

本地化计算:框架会尽量把Map任务调度到存储着所需数据块的机器上去执行,这叫做“数据本地化”,这样做减少了网络传输的数据量,大大提高了效率,这体现了“移动计算比移动数据更划算”的重要设计哲学。

案例回顾与影响

通过“单词计数”这个案例,我们清晰地看到了MapReduce如何将一个大问题分解、分发、再汇总的过程,这个模型虽然简单,但非常强大,适用于很多大规模数据处理场景,比如构建搜索引擎的索引、分析用户行为日志、进行机器学习数据预处理等。

总结来说,谷歌的这篇MapReduce论文,不仅仅是介绍了一个工具,更是开创了一个时代,它直接催生了后来鼎鼎大名的开源实现Hadoop,使得所有公司(而不仅仅是谷歌)都能利用廉价硬件组建集群来处理大数据,它奠定了现代大数据技术的基础生态,可以说是21世纪前20年最重要的计算机论文之一,它的核心贡献在于:用一种简单而优美的抽象,隐藏了分布式系统的底层复杂性,让大规模计算变得平民化。

本文由召安青于2026-01-08发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/77023.html