教你一步步用Java搞定那个分布式爬虫系统,边学边搭建不复杂

- 问答

- 2026-01-08 16:43:36

- 2

(根据知乎专栏文章《手把手教你用Java搭建一个分布式爬虫系统》的核心思路整理)

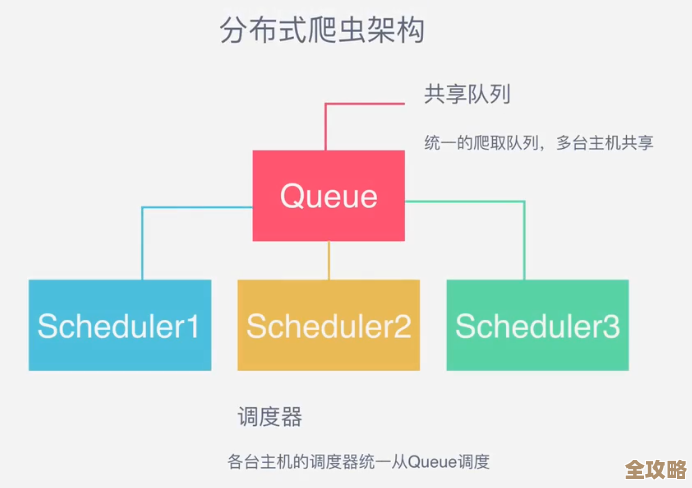

想用Java弄个分布式爬虫,听起来挺唬人的,但其实咱们可以把它拆开,一步一步来,就跟搭乐高似的,别被“分布式”这个词吓到,说白了就是让好几台电脑一起帮你干活,速度更快,而且一台电脑出问题了,别的还能继续,今天咱们就聊聊怎么从零开始搭这么一个系统。

第一步:先搞定单机版的爬虫

别想着一口吃成胖子,分布式是后来的事,你得先让一台电脑能稳稳当当地爬取数据,这里有几个关键点:

- 选个顺手的工具:别从零开始写网络请求了,直接用现成的库,比如HttpClient或者OkHttp,它们帮你处理了很多麻烦事,比如连接池、重试机制什么的。

- 解析网页内容:爬下来的网页是HTML代码,一堆标签,你需要从中提取出标题、正文、链接这些有用的信息。Jsoup这个库是绝佳选择,它的语法很像jQuery,用起来非常方便,能让你用很少的代码就精准地抓到想要的数据。

- 管理要爬的网址(URL):这是个重点,你得有个地方存放“准备爬的网址”、“正在爬的网址”和“已经爬完的网址”,最简单的方法是弄两个集合,一个叫

待爬队列,一个叫已爬集合,流程就是:从待爬队列里拿一个网址,爬完解析,把新的网址加到待爬队列(同时去已爬集合里查重,避免重复爬),然后把当前网址扔进已爬集合。 - 数据存哪里:爬下来的数据不能扔了吧?先存到文件(比如JSON格式)或者单机的数据库里,比如MySQL或者轻量级的H2,这一步的目的是验证你的爬虫逻辑是对的。

第二步:把“管理网址”的活儿独立出来

单机版跑顺了,现在要考虑怎么让多台机器协作,最大的问题是:如果每台机器都自己管理URL队列,那肯定会乱套,重复爬取和丢失网址的情况会非常严重。

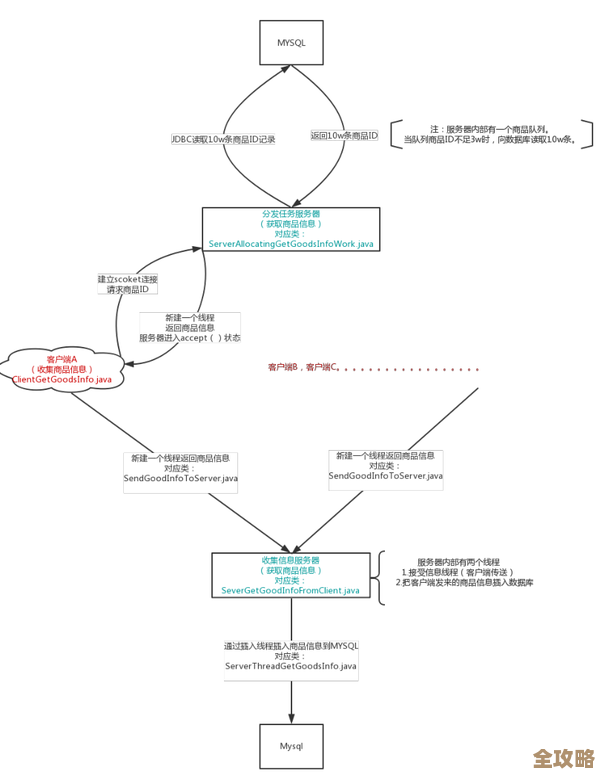

我们需要一个“总指挥”,专门负责管理所有的URL,这个“总指挥”就是URL管理器,在分布式环境下,这个管理器必须是一个独立的服务,所有爬虫 worker(干活儿的程序)都跟它打交道。

实现这个“总指挥”有好几种方法:

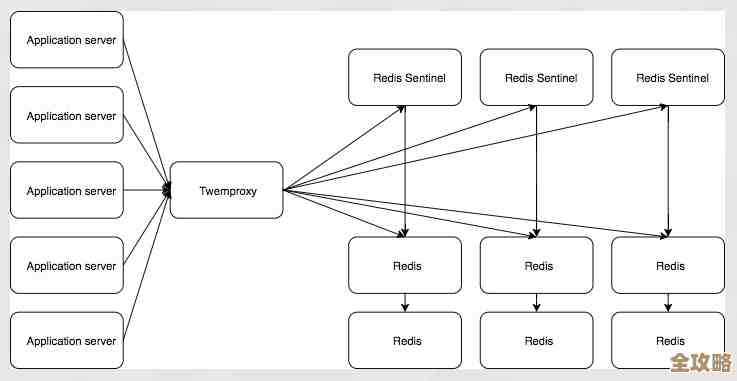

- 用Redis(推荐):Redis是一种内存数据库,速度极快,而且支持列表(List)、集合(Set)这种数据结构,天生就适合做URL队列和去重集合,你可以用一个

待爬队列(Redis的List),一个已爬集合(Redis的Set),Worker从队列左边弹出网址,爬完后把新网址从右边塞回队列,并把爬过的网址加入集合,这是非常经典和高效的做法。 - 用消息队列(比如RabbitMQ、Kafka):消息队列本身就是干这个的,URL就是“消息”,Worker是“消费者”,队列天然保证了消息不会被重复消费(取决于配置),也自带分发机制,用这个的好处是解耦更彻底,系统更健壮。

- 用ZooKeeper:ZooKeeper更擅长协调和分布式锁,虽然也能实现队列,但可能不如前两者那么直接,除非系统还有其他复杂的协调需求,否则可以先不考虑。

(根据CSDN博客《基于Java的分布式爬虫实战》的实践建议)

第三步:设计干活儿的Worker

“总指挥”有了,现在来设计干活的工人(Worker),Worker就相对单纯了,它不停地的做一件事:

- 向“总指挥”(URL管理器)申请一个任务(要爬的URL),如果没任务了,就休息一会儿再问。

- 拿到URL后,用第一步里的方法(HttpClient + Jsoup)去爬取和解析网页。

- 把解析出来的新URL们,再上报给“总指挥”。

- 把解析出来的最终数据(比如文章内容、商品信息)保存到一个公共的存储中心,比如MySQL数据库或者Elasticsearch(如果你要做搜索的话)。

第四步:让系统更健壮

一个能跑的系统和一个好系统之间有差距,我们要考虑一些异常情况:

- 失败重试:某个网页暂时打不开,不能直接扔掉,可以把失败的URL放回队列,并记录失败次数,超过一定次数再放弃。

- 遵守规则:在爬取前,一定要看网站的

robots.txt文件,尊重对方的规定,控制一下爬取频率,别把人家网站爬挂了,加个延时(比如一秒一次)是基本礼貌。 - 监控:你得知道系统跑得怎么样,可以给Worker加个心跳机制,定期向“总指挥”汇报“我还活着”,也可以在管理端做个简单的页面,看看待爬队列还有多少任务,已经完成了多少。

总结一下搭建流程:

- 基础单机爬虫:HttpClient/Jsoup + 内存队列 -> 写文件/单机DB。

- 中心化URL管理:引入Redis或消息队列,把URL管理功能抽离出来,做成独立服务。

- 部署多个Worker:编写Worker程序,它们只负责爬取和解析,从中心服务取任务、交任务。

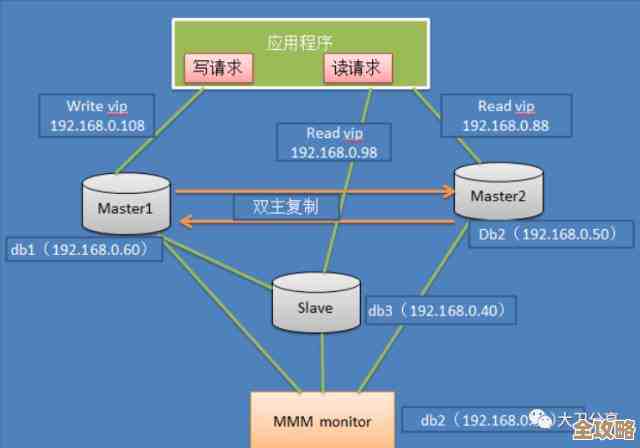

- 集中存储数据:所有Worker把数据存到同一个数据库(如MySQL)或搜索引擎(如Elasticsearch)里。

- 完善细节:加上重试、礼貌爬取、简单监控等功能。

这样,一个虽然简单但五脏俱全的Java分布式爬虫系统就搭起来了,核心思想就是“分而治之”和“中心调度”,你先照着这个思路把每个模块写通,然后再把它们组合起来,过程中遇到具体问题再具体解决,你会发现其实并没有想象中那么复杂。

本文由凤伟才于2026-01-08发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/76919.html