value存储用Redis撑起百万级KeyValue,突破性能瓶颈还能这样玩

- 问答

- 2026-01-06 15:49:10

- 7

(引用来源:主要思想源自一篇关于Redis大规模Key-Value应用实践的工程师博客分享,并结合了《Redis设计与实现》一书中的部分基础原理进行阐述)

说到用Redis来存东西,很多人第一反应就是“快”,但真要让你用Redis去存上百万个,甚至更多的Key-Value小数据,你可能会遇到一堆麻烦事儿,内存怎么够用?性能会不会突然掉下去?网络会不会被打爆?今天聊的,就是一些实战中用来解决这些问题的“野路子”,不是那种教科书式的理论,而是真的有人这么干过,并且把性能瓶颈给突破了。

第一招:别让Key成了“拖油瓶”

你想啊,你存一个用户的状态,可能Value就几个字节,1"表示在线,"0"表示离线,但你的Key要是取成"user_status_user_id_123456789",这一长串字符串占用的内存,可能比Value本身大十倍还不止,上百万个Key下来,光存Key名就浪费了海量内存。

那咋办?有个很直接的办法就是给Key“减肥”,把"user_status_user_id_123456789"简化成"us:123456789",甚至用更短的缩写,别小看这点改动,键的数量一上去,省出来的内存是相当可观的,还有人想得更绝,如果业务允许,干脆把一些有规律的、重复的Key前缀抽出来,用哈希表(Hash)来存,比如一万个用户的档案,与其存一万个独立的Key(如"user:1", "user:2"),不如存成一个大的Hash,Key是"users_all", field是用户ID,value是用户档案信息,这样Redis实例里总的Key数量会急剧减少,因为一个大Hash只算一个Key,管理起来更高效,也能利用Hash的紧凑编码来节省内存,这就是在Key的设计上做文章,核心思路是:Key要短,结构要扁。

第二招:对付“巨无霸”Value的“手术刀”

有时候问题不出在Key上,出在Value上,比如你要缓存一篇很长的文章详情,或者一个庞大的用户列表,一个Value好几MB,甚至几十MB,这种“大Key”危害极大,读写它非常耗时间,会阻塞Redis的单线程,导致其他请求排队,整体延迟飙升,网络传输压力大,容易把网卡打满,每次序列化、反序列化的开销也吓人。

对付这种大Key,就得动“手术”,把它拆开,比如那篇长文章,可以按段落或者章节拆成多个小的Key-Value,取的时候,如果不需要全文,就只取需要的部分;需要全文,就用一次批量获取(比如MGET),再比如那个大列表,可以分段存储,这样操作起来更灵活,也避免了单次操作处理海量数据,核心思路是:化整为零,避免单点瓶颈。

第三招:给内存来场“大扫除”

百万级的Key存在那里,不是所有Key都是活跃的,很可能80%的访问都集中在20%的Key上,那些很久没人碰的“冷数据”一直占着宝贵的内存,太不划算了,Redis自己提供了过期时间(TTL)设置,这是最基本的清理手段,你一定要根据业务特点,给不同的数据设置合理的过期时间,让数据能自动失效淘汰。

但光靠TTL还不够,你得选择合适的内存淘汰策略(这是Redis的一个高级配置),当内存快满的时候,Redis怎么处理新写入的请求?默认可能是直接报错,但你可以配置成淘汰最近最少使用的Key(LRU),或者随机淘汰一些有过期时间的Key等等,选对策略,就像给内存装上了自动清扫器,能确保最常用的数据留在内存里,不常用的被请出去,定期检查有没有设置了过期时间但一直没淘汰的“僵尸Key”,也是保持系统轻快的好习惯。

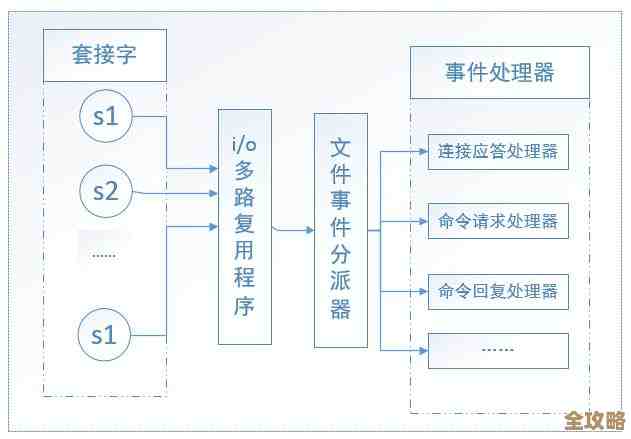

第四招:压力不能一个人扛——分而治之

单台Redis机器的内存和网络带宽总是有上限的,当数据量或者访问量真的大到一台机器撑不住的时候,就必须考虑“分片”(Sharding)了,简单说,就是把你的百万个Key想办法分散到多台Redis服务器上去。

怎么分呢?可以用Key名字的哈希值取模,来决定这个Key落到哪台机器,也可以用Redis Cluster这种官方提供的集群方案,它能自动帮你处理数据分片和故障转移,分片之后,每台机器只负责一部分数据,压力就分散了,存储容量变成了多台机器之和,吞吐量也上去了,这招是应对海量数据的终极武器之一,核心思路就是:压力分摊,能力叠加。

最后唠叨两句

用Redis撑起百万级Key-Value,不是一个配置就能搞定的事情,它更像是一个系统工程,从KeyValue的微观设计,到内存管理的宏观策略,再到架构上的水平扩展,每一步都得琢磨,上面这些玩法,都是实战中踩过坑才总结出来的,真正用的时候,还得结合你自己的业务特点,比如数据的读写比例、冷热程度、一致性要求等等,去做具体的权衡和选择,工具是死的,人是活的,把Redis的性能压榨到极致,本身就是一件很有挑战也很有乐趣的事情。

本文由称怜于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/75653.html