Redis连接突然卡壳了,感觉得重新摸索一遍才能继续往下走

- 问答

- 2026-01-06 14:08:13

- 21

(用户)那天下午,系统后台突然变得奇慢无比,一个简单的数据查询,那个加载的小圆圈转了快一分钟还没停,我心里“咯噔”一下,第一反应就是:不会是Redis挂了吧?赶紧打开监控一看,连接数倒是没爆,但操作延迟的曲线直接冲上了天,变成了一条陡峭的直线,这种感觉太熟悉了,就像你开着车在高速上飞驰,突然毫无征兆地陷进了厚厚的泥潭,油门踩到底,轮子空转,车子却只能一寸一寸地往前挪,整个人一下子就烦躁起来,因为这意味着,之前感觉已经理顺了的东西,又得从头再来一遍。

(用户)最开始,我以为是网络波动,毕竟云服务器嘛,偶尔抽下风也不是什么新鲜事,我试着用redis-cli去连了一下,能连上,但执行一个最简单的ping命令,都要等好几秒才有回应,这感觉就像你对着一个反应迟钝的人问话,问完一句,他得愣半天神才“啊?”一声,让你火冒三丈,排除了网络最表层的问题,我又把目光投向了Redis本身的监控指标。

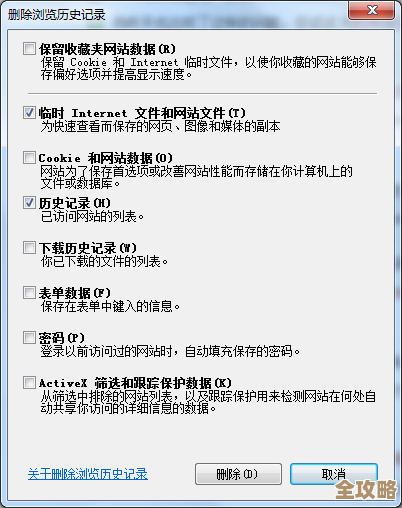

(用户)看着监控面板上那些密密麻麻的数字和曲线,什么used_memory、connected_clients、instantaneous_ops_per_sec,我突然感到一阵茫然,这些术语平时好像都懂,但真到了要快速定位问题的时候,它们就像一堆散乱的积木,我不知道该先拿起哪一块,这种“卡壳”不光是Redis的,也是我脑子里的,之前处理类似问题时记下的那些要点、排查的顺序,一下子变得模糊不清,我不得不停下来,像翻旧账一样,在笔记和浏览器历史记录里拼命寻找上一次是怎么解决的,这种“重新摸索”的感觉非常糟糕,它打乱了你的节奏,消耗着你的耐心和信心。

(用户)我深吸一口气,强迫自己冷静下来,按照最笨拙但也最可靠的方式重新开始“摸索”,第一步,先看日志。tail -f命令盯着Redis的日志文件,果然发现了一些端倪,里面开始频繁出现“慢查询”的警告,还有一些关于内存的提示,问题似乎指向了两个方面:一是某些命令执行得太慢,拖累了整个实例;二是内存使用可能不太健康。

(用户)就得用info命令这个“听诊器”去仔细听听Redis的内部状态了,我习惯性地输入redis-cli info memory,看着返回的一大段信息,目光锁定在used_memory_human和used_memory_peak_human上,发现当前内存使用虽然没到上限,但已经非常接近峰值了,这说明内存曾经承受过很大的压力,然后我又看了info stats里的keyspace_hits和keyspace_misses,计算了一下命中率,发现缓存命中率比平时低了不少,这解释了为什么应用会变慢——有大量的请求没有从Redis里拿到数据,直接打到了后端的数据库上。

(用户)这时候,我才想起来应该用redis-cli --slowlog get 10看看最近最慢的10条命令到底是什么,结果出来,发现有几个keys *模式的查询,执行时间长得离谱,我这才恍然大悟,可能是某个新上线的功能或者某个同事在调试时,不小心执行了这种全局扫描的命令,它会把所有的键都遍历一遍,在数据量大的时候,简直就是一场灾难,会瞬间阻塞住后续的所有请求,找到了这个“元凶”,我心里稍微踏实了一点。

(用户)但光找到问题还不够,得解决,对于慢查询,我赶紧联系相关同事,让他们紧急修复代码,用scan命令替代危险的keys,对于内存问题,我检查了数据的过期时间设置,发现有些关键键没有设置过期时间,导致了无用数据的堆积,于是赶紧给它们加上了TTL,这一通操作下来,就像是给卡住的齿轮一点点地滴润滑油,先是稍微松动一点,然后逐渐地,监控上的延迟曲线开始下降,最终恢复了正常的心跳般的波动。

(用户)当系统终于恢复正常的那一刻,我并没有感到多少成就感,反而是一种深深的疲惫,我意识到,这次“卡壳”和“重新摸索”的经历,暴露了我对Redis的理解还停留在“会用”的层面,远远没到“精通”的程度,那些知识是碎片化的、被动积累的,没有被系统地整理和内化,所以一旦遇到非常规的问题,就会手忙脚乱,我决定,不能就这么过去了,我得把这次排查的过程、用到的关键命令、每个指标的含义和阈值,都详细地记录下来,整理成一个属于自己的排查清单,下次再遇到类似情况,哪怕一开始还是会懵,但至少手里有了一张“地图”,不用再像没头苍蝇一样在黑暗中完全重新摸索了,这个过程虽然痛苦,但也许就是成长的必经之路吧。

本文由盈壮于2026-01-06发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/75613.html