Redis读写分离怎么用才能高性能,场景里那些坑和优化点分析

- 问答

- 2026-01-05 18:13:36

- 16

关于Redis读写分离怎么用才能实现高性能,以及在实际场景中会遇到哪些坑和怎么优化,我们可以结合一些网络上的技术分享,比如来自阿里云开发者社区、开源中国等平台的文章观点来聊聊。

读写分离的核心目的与适用场景

读写分离不是任何时候都需要的“银弹”,它的核心目的是为了分摊压力,当你的业务遇到读请求的量远远大于写请求(比如典型的八二开甚至九一开),并且单个Redis实例(哪怕是配置很高的机器)已经快扛不住读请求的压力时,才需要考虑读写分离,简单说,就是为了解决“读多写少”场景下的读性能瓶颈,如果写操作也很频繁,或者数据量特别大,那可能就需要考虑数据分片(分库分表)的方案了,而不仅仅是读写分离。

Redis读写分离的基本模式

Redis的读写分离通常依赖于主从复制(Replication)架构,你有一个主节点(Master),主要负责处理写操作(如SET、DEL),可以配置一个或多个从节点(Slave或Replica),这些从节点会实时(或近乎实时)地从主节点同步数据,应用程序在写数据时,直接访问主节点;在读数据时,则可以去访问一个或多个从节点,这样,读流量就被分散到了多个节点上,从而提升了整体的读吞吐量。

高性能使用中的“坑”与优化点分析

光有架构还不够,用不好反而会带来更多问题,以下是几个关键的坑和对应的优化思路:

-

数据不一致的坑(最大的坑)

- 现象:由于主从之间的数据同步是异步的,存在一个极短的延迟(毫秒到秒级都有可能),当你刚写完主节点,立刻去从节点读,可能会读到旧数据,这对于数据一致性要求不高的场景(如排行榜、缓存新闻)可以接受,但对于如库存扣减、订单状态等强一致性场景就是灾难。

- 优化点:

- 业务容忍:首先评估业务是否能接受短暂的不一致,如果可以,这是最简单的方案。

- 强制读主:对一致性要求极高的特定读请求(如用户刚下单后查询订单),可以设置一个“开关”,让这个请求直接走主节点读取,但这会增加主节点压力,失去读写分离的部分意义。

- 监控延迟:密切监控主从之间的复制延迟(

repl_offset),如果延迟过大,需要报警并排查原因(如网络、从节点负载过高)。

-

从节点负载不均的坑

- 现象:如果你有多个从节点,但应用端只是随机或者简单轮询地访问它们,可能会因为某些热点Key或查询复杂度不同,导致个别从节点负载过高,成为新的瓶颈。

- 优化点:

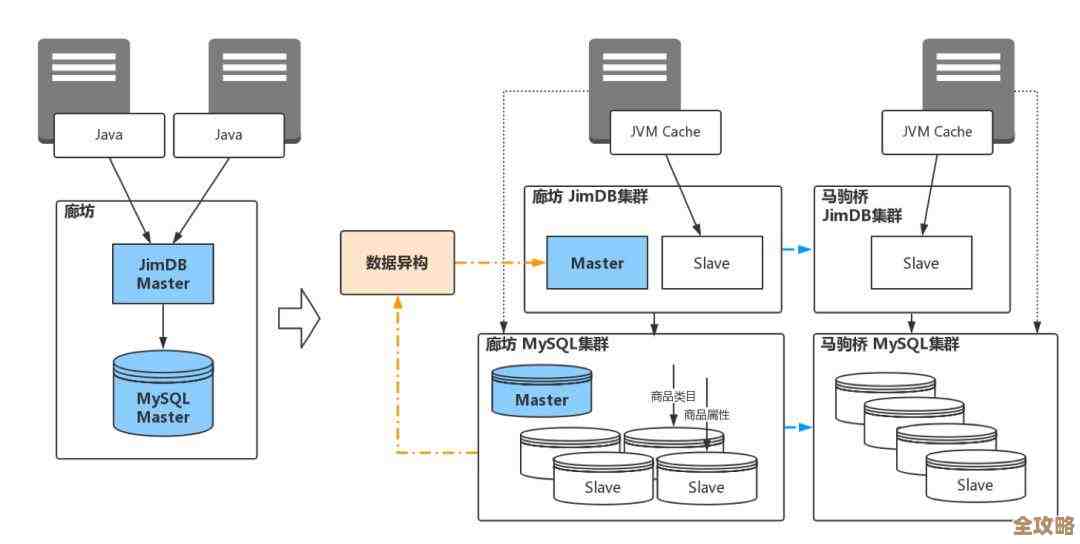

- 使用代理中间件:引入像Codis、Twemproxy或者Redis Cluster(它本身具有分片功能,但也可以配合读写分离)这样的代理层,由代理来负责负载均衡,可以更智能地将请求分发到健康的、负载较低的从节点上。

- 客户端分片:在客户端实现更复杂的负载均衡策略,比如根据Key的哈希值或者节点的实时负载情况来选择从节点。

-

主节点故障切换的坑

- 现象:当主节点宕机时,虽然可以通过哨兵(Sentinel)或者集群模式自动选举出一个新的主节点,但在切换过程中,系统会有短暂的不可用,如果应用端没有及时感知到新的主节点地址,可能会导致写操作失败。

- 优化点:

- 高可用架构:必须搭配Sentinel或Redis Cluster来实现自动故障转移,避免手动操作带来的长时间服务中断。

- 客户端适配:确保你的Redis客户端支持故障自动发现和重连,好的客户端能够从Sentinel获取最新的主从节点信息,并自动切换连接。

-

读写分离不彻底的坑

- 现象:有些命令看似是“读”,但实际上会触发写操作,最典型的就是带有“读后写”语义的命令,例如

INCR(自增)、LPUSH(列表插入)等,如果误将这些命令发送到从节点,会直接报错,因为从节点默认是只读的。 - 优化点:

- 命令路由清晰:在应用代码或中间件层面,必须严格区分读写命令,所有可能修改数据的命令,必须强制路由到主节点。

- 现象:有些命令看似是“读”,但实际上会触发写操作,最典型的就是带有“读后写”语义的命令,例如

-

资源浪费的坑

- 现象:盲目地增加从节点数量,每个从节点都是完整的数据副本,会消耗与主节点几乎相同的内存,如果数据量很大,成本会急剧上升,从节点过多也会给主节点的同步流量带来压力。

- 优化点:

- 按需扩展:根据实际的QPS监控和性能测试结果来逐步增加从节点,避免过度配置,通常建议从1-2个从节点开始,根据压力情况再考虑扩容。

总结一下,Redis读写分离是提升读性能的有效手段,但它引入了数据一致性的核心挑战,要想高性能地使用它,关键在于:第一,业务上能接受短暂不一致;第二,架构上要做好负载均衡和高可用;第三,运维上要持续监控主从延迟和节点负载,它不是一种“配置好就一劳永逸”的方案,而是一个需要持续监控和调优的动态过程。

本文由钊智敏于2026-01-05发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/75092.html