说实话,SQL Server里那四亿多条数据我到底是怎么搞定的?

- 问答

- 2026-01-05 01:24:44

- 26

说实话,SQL Server里那四亿多条数据我到底是怎么搞定的?

这事儿说来话长,当时真是头皮发麻,我不是什么数据库专家,就是一边查一边干,摸着石头过河,你让我讲那些特别专业的术语,我也说不利索,我就用大白话跟你唠唠我是咋整的。

第一关:不能直接上

最开始,我的想法特简单:不就是导数据嘛,写个程序,一条一条往里插不就完了?结果你猜怎么着?我试了一下,每秒最多也就插个几百条,我拿计算器一按,四亿条?这得跑到猴年马月去,机器不崩,我先崩了,这条路直接pass,太原始了。

后来才知道,像我这种蛮干,在数据库里叫“逐行插入”(来源:常见数据库性能优化建议),事务日志能给你撑爆,速度慢得像蜗牛,得换思路。

第二关:找到“批量”这个法宝

然后我就开始搜啊,问啊,终于搞明白了一个关键点:不能一条一条喂,得一批一批地喂,就像你运沙子,不能一粒一粒拿手捧,得用铲子,一铲子一铲子地往里倒。

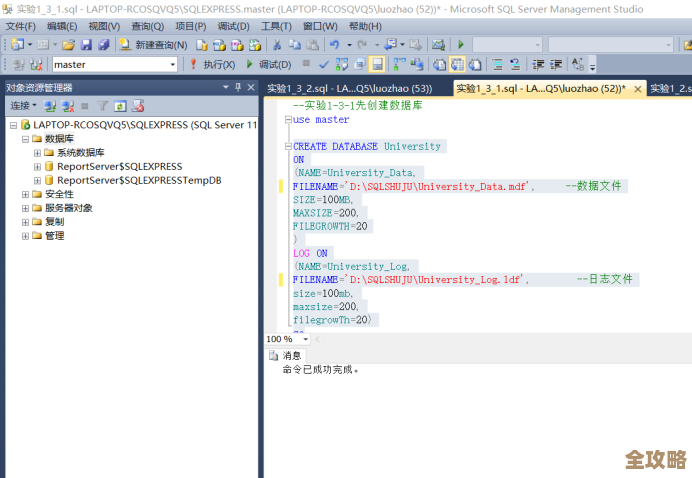

我用的最主要工具就是SQL Server自带的 BCP( Bulk Copy Program,大容量复制程序)(来源:SQL Server官方工具介绍),这玩意儿是专门干这个的,速度飞快,我的步骤大概是:

- 准备干净的数据文件:我把源数据整理成纯文本的CSV格式文件,每个文件大概几百万条数据,这一步很关键,数据格式必须规整,不然BCP会报错,死活导不进去。

- 关掉“碍事”的东西:在导入之前,我对着数据库做了几个“大手术”,我把目标表的索引(就是帮数据库查东西快的那种结构)(来源:数据库索引基础概念)先给删了,因为你一边插数据,它一边要维护索引,特别累赘,速度直接掉一半,我心想,反正数据是新的,等全部倒进去再建索引也不迟。

- 调整恢复模式:我还把数据库的恢复模式从默认的“完整”改成了“大容量日志”(来源:SQL Server数据库恢复模式),简单说,就是让数据库别那么事无巨细地记录每一步操作,先保证导入速度,这么干有点风险,万一中途断电,数据可能恢复起来麻烦点,但我当时顾不了那么多,速度优先。

- 开倒!:然后用BCP命令,指定好文件、数据库表、格式文件,一声令下就开始跑了,看着屏幕上数字哗哗地跳,心里那个爽啊,速度提升了几十倍都不止。

第三关:中途的坑和招儿

事情当然没那么顺利,中间遇到过好几次中断,比如数据文件里有几个怪字符,BCP就卡壳了,这时候不能从头再来,那太傻了,我就写了个小脚本,记录每次导入的成功位置,万一断了,就从断掉的那一行接着来,这叫“断点续传”(来源:常见数据处理方法),是自己琢磨的土办法,但很管用。

还有一次,导着导着硬盘空间报警了!原来是事务日志文件涨得巨大,我赶紧手动备份了一下日志,把它清理出空间,才没酿成大祸,这也让我学了乖,这种大批量操作,真得时刻盯着点系统资源。

第四关:最后的冲刺

等所有数据都倒进一张临时的大表里之后,最危险的时刻过去了,但活儿还没完,现在这张表是个“光板儿”,没有索引,查什么都慢如牛毛。

接下来就是建索引,这可是个重量级操作,也挺耗时间的,我选择在晚上业务最少的时候干,一口气建好主键索引和几个最常用的查询索引,建的时候,数据库也会卡一下,但这是必要的代价。

索引建好那一刻,整个世界都清净了,试着查了一下数据,秒出结果,那种感觉,就像打通了任督二脉。

我的土法炼钢秘籍:

- 核心思想:告别单打独斗,拥抱批量操作。

- 神器:BCP工具,或者类似能批量导入的工具。

- 准备工作:清空索引、调整数据库设置,给导入扫清障碍。

- 过程管理:分而治之,用小文件分批导入,准备好断点续传。

- 收尾工作:数据进库后,再统一创建索引,优化查询速度。

搞定四亿条数据,靠的不是什么高深莫测的黑科技,而是耐心、正确的工具(批量)和一点点规避风险的技巧,最重要的是,别怕,一步一步来,总能啃下来,现在回想起来,虽然过程折腾,但真是涨了不少见识。

本文由瞿欣合于2026-01-05发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/74657.html