KubeEdge边缘节点怎么分组管理的设计和具体实现探讨

- 问答

- 2026-01-04 10:18:59

- 15

KubeEdge边缘节点分组管理的设计和具体实现探讨

(引用来源:KubeEdge官方文档、社区讨论及相关技术博客)

KubeEdge作为将Kubernetes容器编排能力扩展到边缘计算环境的开源系统,其核心挑战之一是如何高效管理分布在各地、数量庞大且可能具有不同特性的边缘节点,直接照搬云端Kubernetes对节点一视同仁的管理方式,在边缘场景下会显得笨重且不灵活,对边缘节点进行逻辑上的分组管理,成为一个非常自然且必要的设计选择,这种分组不是物理上的重新部署,而是通过标签和选择器这类逻辑工具,为节点打上不同的“标签”,然后根据这些标签来实施差异化的管理策略。

为什么需要对边缘节点分组?

边缘节点的环境远比云端数据中心复杂,想象一下,一个智能工厂的部署场景:有的节点安装在振动大、环境温湿度变化剧烈的生产线上,负责收集设备传感器数据(高频率、小数据包);有的节点部署在相对洁净的控制室,负责运行图像识别的AI模型(需要GPU,计算密集);还有的节点可能位于厂区门口的安防系统,负责视频流分析(网络带宽要求高),如果不对这些节点加以区分,运维人员很难精准地将合适的应用部署到合适的节点上,也无法针对不同区域的节点制定不同的配置、监控和故障恢复策略,分组管理的核心目的,就是为了实现这种精细化的运维,提升管理效率和应用的可靠性。

分组管理的核心设计思路:基于标签(Labels)和选择器(Selectors)

KubeEdge继承了Kubernetes的强大能力,其分组管理的基石就是“标签”机制,这就像给每个边缘节点贴上各种便利贴,注明它的“身份特征”,常见的标签可以包括:

- 地理信息:

region=east-factory,zone=assembly-line-1 - 硬件特性:

disk-type=ssd,gpu-model=nvidia-t4 - 业务角色:

app-type=data-collection,app-type=ai-inference - 网络环境:

network=wired,network=cellular-5g - 自定义属性:

project=project-sunshine,owner=team-alpha

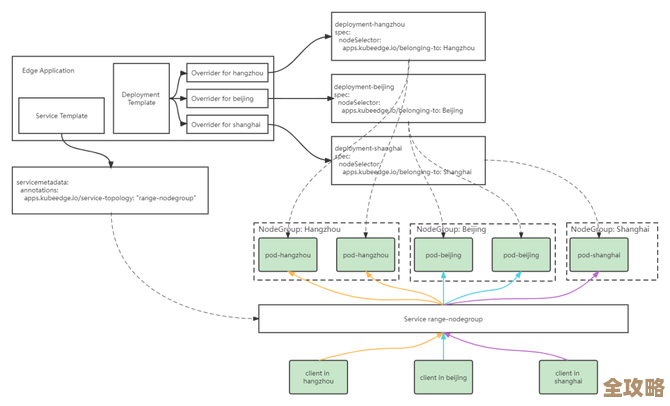

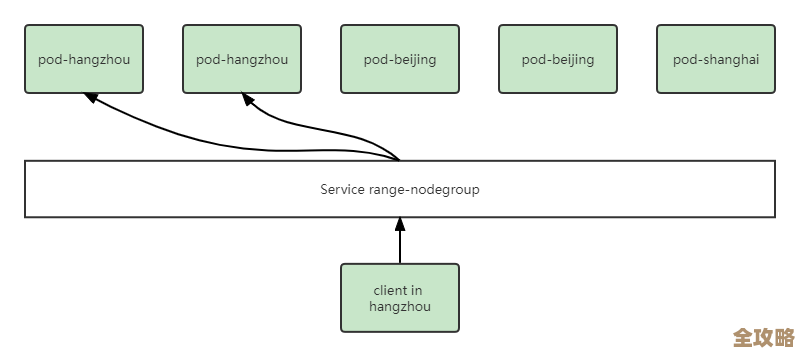

有了标签,如何利用它们进行分组呢?答案是通过“标签选择器”,当用户创建一份部署(Deployment)、一个配置(ConfigMap)或者一个策略(如来自Sedna的边缘AI模型热更新策略)时,可以在配置文件中指定一个选择器,这个选择器会声明:“我只对拥有region=east-factory和app-type=ai-inference这两个标签的节点生效”,KubeEdge的组件(尤其是运行在云端的Controller Manager)会负责匹配标签,并将工作负载或配置精准地下发到符合条件的那一组节点上,这种设计非常灵活,一个节点可以拥有多个标签,从而属于多个逻辑分组,满足了边缘场景下多维度的管理需求。

具体实现方式的探讨

在实际操作中,分组管理主要通过以下几种方式落地:

-

节点标签的添加与管理:

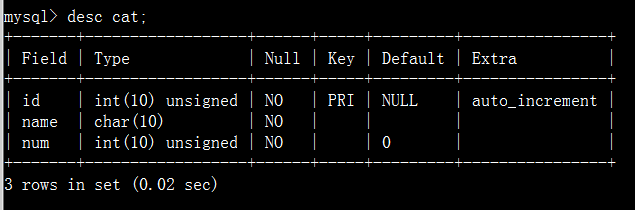

- 云端操作:运维人员可以直接使用Kubernetes的命令行工具

kubectl,为边缘节点资源对象打上标签。kubectl label nodes edge-node-1 region=east-factory,这是最直接的方式,适合节点数量不多或需要临时调整的场景。 - 自动化脚本与工具:当节点成百上千时,手动打标签不现实,可以编写脚本,根据节点的注册信息(如注册时上报的硬件架构、地理位置等)自动为其添加初始标签,社区也有一些工具可以帮助实现标签的批量管理和生命周期管理。

- 通过Device Model/Device(可选):虽然KubeEdge的Device Model主要用于描述设备属性,但在某些部署模式中,设备与节点有强关联关系,可以间接通过设备所属的节点来实现基于设备类型的分组。

- 云端操作:运维人员可以直接使用Kubernetes的命令行工具

-

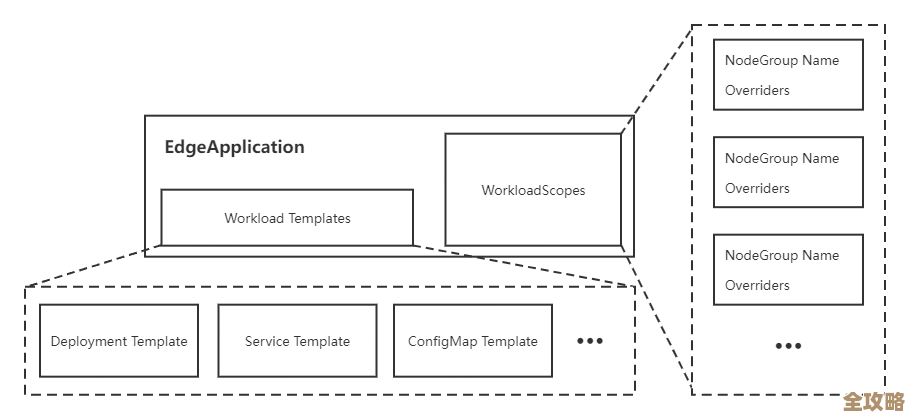

工作负载的分组部署: 在创建Deployment或DaemonSet等 workload 资源时,在

spec.template.spec中通过nodeSelector字段指定目标节点组,一个需要GPU的AI推理应用,其Deployment的配置片段会包含:spec: template: spec: nodeSelector: gpu-model: nvidia-t4 containers: - name: ai-app ...这样,Kubernetes调度器(在KubeEdge中,部分调度决策可以下沉到边缘)就会确保这个Pod只被调度到带有

gpu-model=nvidia-t4标签的节点上。

-

配置信息的分组下发: 边缘节点的配置(如应用程序的配置文件、证书)通常通过ConfigMap或Secret来管理,通过在这些资源上使用标签,并结合Pod的

volumes挂载机制,可以实现配置的按组下发,为不同工厂的节点创建不同的ConfigMap,并分别打上region: east-factory和region: west-factory的标签,在各自的Pod定义中,通过volumeMounts引用对应标签选择器选中的ConfigMap。 -

与KubeEdge高级特性的结合:

- 边缘应用管理:KubeEdge提出了“EdgeApplication”等概念(或在Sedna项目中),其本质就是围绕一组具有特定标签的边缘节点,定义完整的工作负载、配置和依赖关系,实现应用的原子化部署和升级,这本身就是分组管理的高级形态。

- 规则引擎与策略:可以与KubeEdge的消息路由、规则引擎等功能结合,定义一条规则:“将所有带有

app-type=data-collection标签的节点产生的数据,转发到特定的云端服务”,这使得数据流也能基于节点分组进行管理。

实践中的考量与挑战

尽管基于标签的分组方案很灵活,但在实际大规模应用中仍需考虑:

- 标签规划的合理性:标签体系需要在一开始就进行良好的设计,避免后期混乱,标签的键值应简洁、语义明确。

- 权限控制:在多租户环境下,需要结合Kubernetes的RBAC(基于角色的访问控制)机制,限制不同用户或团队只能给节点打特定范围的标签,只能访问和管理特定的节点分组,防止误操作或越权。

- 动态标签的管理:有些节点属性可能是动态变化的,比如网络状态从4G切换到Wi-Fi,如何动态更新这类标签,并触发相应的策略调整,是需要额外组件(如Node Feature Discovery)或自定义控制器来解决的问题。

KubeEdge边缘节点的分组管理并非一个独立的功能,而是巧妙地利用并扩展了Kubernetes原生的标签和选择器机制,将其应用于边缘计算的特殊环境,通过为节点打上丰富的标签,运维人员可以像管理一个个逻辑上的“边缘集群”一样,对庞杂的边缘节点进行精细化的应用部署、配置管理和策略实施,从而真正发挥出边缘计算的优势,随着KubeEdge生态的发展,预计会出现更多围绕节点分组管理的自动化运维工具和最佳实践。

本文由雪和泽于2026-01-04发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/74267.html