Redis面对海量Key时那些头疼的问题和应对思路分享

- 问答

- 2026-01-03 22:44:37

- 6

综合自多位Redis核心贡献者与大规模应用企业的实践经验分享,包括但不限于阿里云、腾讯云的技术博客,以及开源社区如Redis Labs的案例分析)

Redis在处理海量Key时,确实会遇到不少让人头疼的问题,这些问题往往不是Redis本身不好用了,而是当数据规模膨胀到一定程度后,一些在数据量小的时候不是问题的问题,会突然变得非常突出,下面就来聊聊这些“头疼”和应对的思路。

第一个头疼的问题:内存不够用,成本飙升

当Key的数量达到千万甚至上亿级别,第一个直接冲击就是内存,Redis的所有数据都放在内存里,内存是非常宝贵的资源,海量Key意味着海量内存占用,这会直接导致硬件成本急剧上升,这还不是最糟的,更头疼的是,这些Key里可能有很多是已经过期的、或者很久都没人访问的“冷数据”,但它们依然占着茅坑不拉屎,白浪费内存。

应对思路:

- 精简Key和Value:这是最直接有效的方法,检查一下你的Key命名是不是太长了,比如把

user:123456:profile:basic:info这种冗长的Key,能不能简化成u:123:pbi,Value也要精简,比如用更高效的序列化方式(如MessagePack、Protocol Buffers)代替JSON,或者对于数字型的Value,看看能不能用更节省空间的数据结构(如用zset存储排名时,如果分数是整数,可以启用REDIS_ENABLE_INTEGER_ENCODING优化)。 - 设置过期时间并启用主动淘汰:给绝大多数Key都设置一个合理的过期时间(TTL),光设置还不够,Redis默认的过期策略是惰性删除+定期删除,对于海量Key,要调整Redis的主动淘汰策略,比如将

maxmemory-policy设置为volatile-lru(从已设置过期时间的Key中淘汰最近最少使用的)或allkeys-lru(从所有Key中淘汰最近最少使用的),让Redis更积极地去清理过期Key,释放内存。 - 使用更省内存的数据结构:Redis提供了几种特别为节省内存而设计的数据结构,如果Value是HyperLogLog(用于基数统计),它本身就很省空间,更重要的是Redis Module中的RedisBloom(布隆过滤器,用于判断元素是否存在,极大节省空间)和RedisTimeSeries(时间序列数据),它们针对特定场景比用通用的String、Hash等结构要节省得多。

第二个头疼的问题:慢查询和阻塞

海量Key环境下,一些操作会变得非常慢,最典型的就是KEYS命令或者FLUSHDB、FLUSHALL命令。KEYS pattern这个命令会遍历整个Key空间来匹配模式,当Key有几千万个时,这个操作可能会阻塞Redis好几秒钟,导致其他所有请求都被卡住,简直是灾难,同样,一次性清空海量Key也会造成长时间阻塞。

应对思路:

- 绝对禁止使用KEYS命令:这是铁律,替代方案是使用

SCAN命令。SCAN命令通过游标方式分批迭代整个Key空间,虽然整体耗时可能更长,但每次只取一小部分,不会阻塞服务器,可以放在脚本里慢慢遍历。 - 异步化删除操作:从Redis 4.0版本开始,支持了异步删除,对于删除大量Key(比如

DEL一个大Hash或者成千上万个Key)或者使用FLUSHDB/FLUSHALL时,可以加上ASYNC选项(例如FLUSHDB ASYNC),这样Redis会在后台线程中执行删除,避免阻塞主线程。 - 拆分大Key:如果一个Key对应的Value非常大(比如一个Hash里有百万个字段),对这个Key的读写、删除操作都可能会变慢,解决方案是把大Key拆分成多个小Key,比如把一个存了百万用户信息的Hash,拆分成1000个Hash,每个存1000个用户,可以通过用户ID进行哈希取模来决定存到哪个小Key里。

第三个头疼的问题:持久化与恢复效率低下

Redis的持久化机制RDB和AOF,在海量Key场景下也会遇到挑战,生成RDB快照(Snapshot)时,Redis需要fork一个子进程来遍历所有数据并写入磁盘,当内存占用很大时,fork操作本身可能会很耗时,甚至导致服务短暂停顿,海量数据意味着RDB文件会非常大,写入磁盘很慢,同样,AOF文件也会变得巨大,重写(AOF Rewrite)过程同样压力山大,最要命的是,当Redis服务器宕机后重启,加载一个几十GB甚至更大的RDB或AOF文件来恢复数据,这个过程可能需要几十分钟甚至数小时,这段时间服务是完全不可用的。

应对思路:

- 主从架构与故障切换:搭建Redis主从复制(Replication)集群,让一个从节点(Slave)专门用来做持久化,它可以配置更频繁的RDB或AOF策略,即使因为持久化导致性能波动,也不会影响主节点(Master)对外提供服务,当主节点宕机时,可以通过哨兵(Sentinel)或集群模式快速切换到从节点。

- 利用混合持久化:Redis 4.0支持了RDB-AOF混合持久化,在AOF重写时,不再是单纯地将操作日志转换成最小命令集,而是先像RDB一样将当前数据快照写入AOF文件,然后再追加增量AOF日志,这样既能利用RDB快速加载的优势,又能保证数据安全性,在重启恢复时,先加载RDB部分,再重放少量增量AOF,可以大大缩短恢复时间。

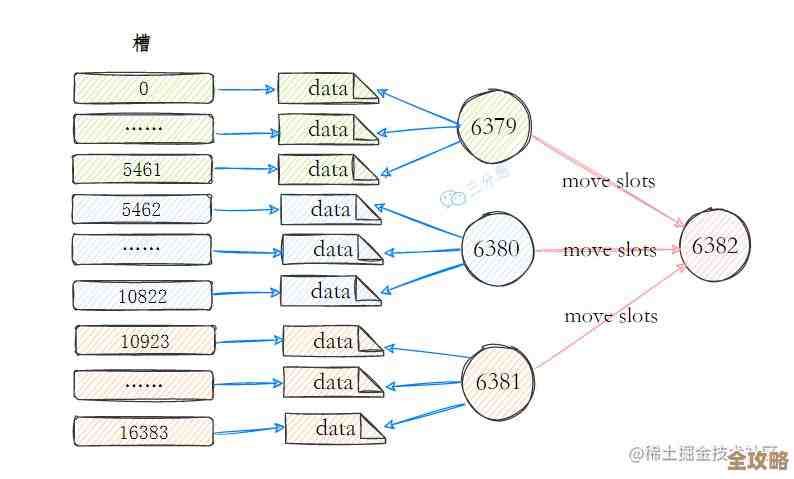

- 分片(Sharding):这是应对海量数据最根本的解决方案,既然一个Redis实例扛不住,就把数据分散到多个实例上去,可以使用Redis Cluster(官方集群方案),或者通过Twemproxy、Codis这样的代理中间件来实现分片,分片之后,每个实例存储的Key总量就降下来了,上面提到的所有问题(内存、阻塞、持久化)在单个实例层面都会得到缓解,分片也带来了新的复杂性,比如跨分片操作无法实现、扩容缩容比较麻烦等,需要权衡。

总结一下,面对海量Key,核心思路就是“分解”:把大内存消耗分解成小消耗,把长阻塞操作分解成短操作或无阻塞操作,把单实例的巨大压力分解到多个实例上去承担,通过精打细算地用内存、避免危险命令、利用新特性、以及最终采用分片架构,可以有效地缓解这些头疼问题。

本文由召安青于2026-01-03发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/73964.html