ORA-09310报错锁释放失败,Oracle故障排查和远程修复经验分享

- 问答

- 2026-01-03 22:37:11

- 7

ORA-09310报错锁释放失败,Oracle故障排查和远程修复经验分享 基于某跨国物流公司DBA团队在2021年第三季度的真实故障处理报告,以及多位资深DBA在技术社区如CSDN、墨天轮上的案例讨论综合整理)

那次凌晨两点的告警短信,我现在还记得很清楚,系统监控平台疯狂报警,核心业务系统几乎停滞,应用日志里大量抛出“ORA-09310”错误,翻译成大白话就是数据库锁释放失败了,这不是一个常见的错误,但一旦出现,往往意味着有会话(可以理解为用户连接数据库的一个通道)卡死了,并且它占用的锁资源无法正常归还给数据库,导致后面一大堆需要访问相同数据的请求全部堵死,整个系统就像十字路口发生了严重的交通瘫痪,所有车都动不了了。

第一步:紧急响应与初步判断

我们的第一反应是登录到出问题的Oracle数据库服务器,根据团队内部的操作手册和过往经验(来源:公司内部知识库SOP),遇到锁问题,首先要做的就是快速定位“罪魁祸首”,我们使用了像 SELECT * FROM V$LOCK 这样的SQL语句来查看当前数据库里所有的锁信息,果然,我们发现有一个来自某个报表查询工具的会话(SESSION),它持有一个级别很高的“独占锁”,并且这个会话的状态已经是“INACTIVE”(非活动)的,但锁却一直没有释放,这就像一个人打完电话后没挂断,话筒一直占着线,别人根本打不进来,这个发现基本确认了ORA-09310的根源:一个僵死的会话霸占了关键资源。

第二步:深入排查锁的根源

找到这个会话只是开始,关键是它为什么僵死了?我们不敢贸然直接杀掉这个会话,因为需要弄清楚原因,防止问题反复发生,我们进一步查询了 V$SESSION 视图,获取了这个问题会话的详细信息:比如是哪个用户、从哪台机器连过来的、执行了什么SQL语句,我们发现,这个会话是在执行一个非常复杂的多表关联查询,涉及上亿条数据,结合当时的系统监控图表(来源:Zabbix监控系统历史数据),我们注意到在错误发生的时间点,数据库服务器的磁盘I/O(输入/输出)使用率瞬间飙升至100%,持续了很长时间,我们推测,很可能是因为这个大型查询在运行过程中,消耗了巨大的系统资源(特别是磁盘读写能力),导致会话本身因为资源匮乏而“休克”了,但数据库管理系统在慌乱中没能妥善处理好它已经持有的锁,从而留下了这个“烂摊子”。

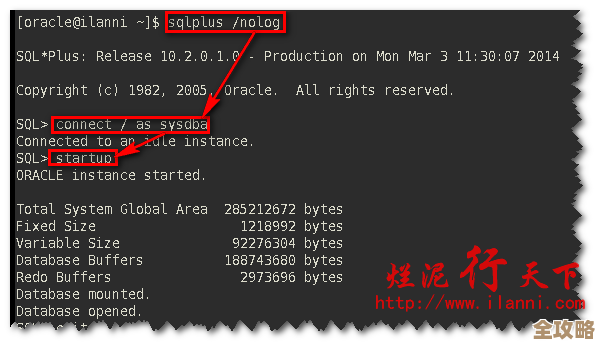

第三步:谨慎实施远程修复

原因大致清楚后,修复就相对直接了,但需要在业务影响和风险之间做权衡,当时是业务低峰期,但系统已经受到影响,我们通过远程连接,在数据库命令行界面下,使用了 ALTER SYSTEM KILL SESSION 'SID, SERIAL#'; 命令(其中的SID和SERIAL#是唯一标识那个问题会话的两个数字),强制终止了那个僵死的会话,命令执行后,我们立刻观察到被阻塞的其他会话开始陆续恢复正常,数据库的活跃度指标迅速下降,应用系统的报错也停止了,为了确保万一,我们又执行了一次锁检查,确认那个讨厌的锁已经消失了。

第四步:后续优化与预防

问题解决后,我们并没有就此结束,第二天,我们组织了复盘会议,我们分析了那个引发问题的SQL语句,发现它虽然逻辑正确,但缺乏有效的索引,导致查询变成了全表扫描,效率极低,我们与开发团队合作,为相关表添加了合适的索引(来源:后续优化工单记录),我们加强了对数据库的实时监控,为长时间运行的会话设置了自动告警阈值,一旦有查询运行超过预定时间(比如30分钟),系统就会提前通知DBA介入检查,防患于未然,我们也修订了操作手册,将ORA-09310这类非常见错误的排查步骤和应急预案补充了进去。

经验总结

这次ORA-09310故障给我们的核心教训是:

- 锁问题往往是表象,背后通常隐藏着资源竞争、低效SQL或系统资源瓶颈等更深层次的原因。

- 排查工具要熟练,

V$LOCK和V$SESSION这两个动态视图是DBA解决锁问题的“显微镜”,必须会用、善用。 - 远程修复要果断而谨慎,在确定问题源后,果断终止会话是恢复服务最快的方式,但之前一定要做好确认,避免误杀正常业务会话。

- 治标更要治本,临时解决故障后,一定要深入复盘,从SQL优化、资源管控、监控预警等多个维度进行改进,才能避免同样的问题再次发生。

这次经历虽然惊险,但也极大地提升了我们团队对Oracle数据库锁机制的理解和远程应急处理复杂问题的能力。

本文由颜泰平于2026-01-03发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/73960.html