Redis缓存实战里那些成功的案例和应用经验分享,聊聊怎么用才更有效

- 问答

- 2025-12-30 09:56:12

- 1

说到Redis用得好,我印象最深的是之前看过一个电商网站的案例分享,他们当时遇到的最大难题就是“秒杀”。(来源:某电商技术博客案例总结)一到搞活动,比如新品首发或者限时抢购,海量的用户瞬间涌进来点击“立即购买”,数据库根本扛不住,页面直接卡死,甚至整个服务器都差点宕机。

他们最开始的想法很简单,就是把商品信息缓存到Redis里,但发现效果不好,因为关键不在于“读”商品详情,而在于“写”库存,每次下单,都要去数据库里查一次库存,再减掉一件,这个流程太慢了,后来他们换了个思路,把核心逻辑全搬到Redis上,具体做法是:在活动开始前,提前把秒杀商品的库存数量,比如1000件,直接加载到Redis的一个键值对里,用户点击抢购时,系统不直接走数据库,而是用Redis的原子操作DECR(递减)去扣减这个库存值。(来源:基于上述电商案例的技术实现细节)这个操作是Redis单线程执行的,能保证绝对不会出现超卖,也就是不会出现库存减到负数的情况,如果DECR之后的结果大于等于0,说明抢购成功,再把后续的生成订单等稍微慢一点的操作放到消息队列里异步处理,如果DECR结果小于0,就直接返回“已售罄”,这样一来,绝大部分的压力都被Redis轻松消化掉了,数据库几乎没感觉到什么冲击,这个案例给我的启发是,用Redis不能只停留在简单的缓存数据,而是要把它当成一个高性能的“内存计算引擎”,用它原子操作的特性去解决核心的并发竞争问题。

另一个让我觉得挺巧妙的用法,是在一个社交APP里看到的,用来处理用户动态“点赞”。(来源:某社交媒体平台架构分享)点赞这个动作非常频繁,而且一个用户对同一条动态只能赞一次,需要判断是否已赞,如果每次点赞都直接更新数据库,数据库的写入压力会非常大,尤其是对于明星用户发的一条热门动态,可能瞬间就有几十万次点赞请求。

他们的解决方案是,为每一条动态在Redis里用一个集合(Set)来存储所有点赞用户的ID,当用户点击点赞按钮时,应用只需要执行一条SADD命令,尝试将这个用户的ID添加到这个动态对应的集合中。(来源:同上社交平台分享的技术要点)Redis的集合特性保证了元素的唯一性,所以同一个用户重复点赞,集合里也只会有一条记录,天然防重复,判断用户是否点过赞,也只需要一条SISMEMBER命令查询这个集合,速度极快,他们并不需要实时地把每一次点赞都同步到数据库,而是通过定时任务,比如每隔5分钟,把这个集合里新增的用户ID批量更新到数据库中,这种设计,把一次高频的、实时的写操作,转换成了一次Redis内存的极速写入和一次数据库的批量更新,完美地平衡了性能和数据的持久化需求,这让我学到,利用Redis丰富的数据结构(比如集合、哈希)的特性,可以设计出非常高效和优雅的解决方案,把数据库从沉重的实时压力中解放出来。

还有一个常见的成功经验是关于“热点数据”的处理。(来源:多个技术社区讨论的共识)有些数据会被反复访问,比如网站首页的顶部导航栏信息、一些基础的城市列表等,这些数据特点是不怎么变,但几乎每个用户每次访问都要用到,如果每次都去数据库查,哪怕数据库扛得住,也会产生很多不必要的开销。

通常的做法是,在系统启动时或者第一次访问时,就把这些数据加载到Redis里,并设置一个较长的过期时间,比如24小时,之后所有的请求都直接从Redis读取,这里的一个关键技巧是“防止缓存穿透”。(来源:Redis缓存设计模式的常见讨论)万一有人恶意攻击,频繁请求一个根本不存在的数据ID(比如商品ID是-1),这个请求会因为Redis里没有,而每次都去查数据库,导致数据库压力大增,应对方法很简单,就是即使从数据库没查到这条数据,也在Redis里缓存一个空值(比如缓存一个“NULL”字符串,并设置一个短的过期时间,如5分钟),这样,后续同样的恶意请求在短时间内就会命中Redis里的空值,而不会再去攻击数据库,这个经验说明,用Redis做缓存,不能只是简单地“存了就行”,还得考虑一些边界情况和恶意场景,做一些防御性的设计,这样才能让缓存体系更健壮。

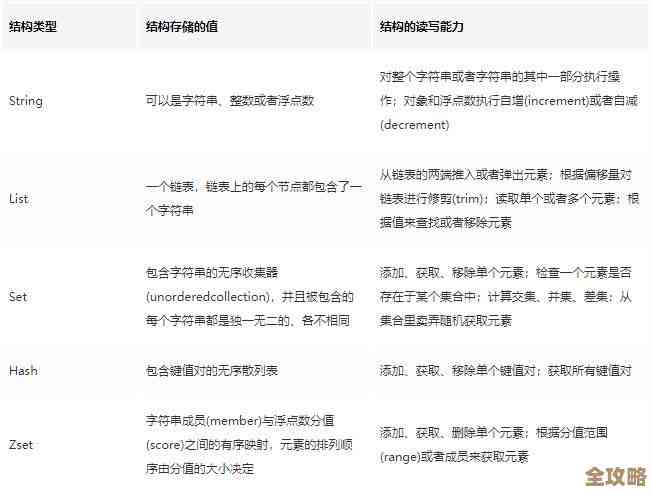

从我看到的这些案例和经验来看,想把Redis用得更有效,关键点在于:第一,要敢于把最热、最核心的数据和逻辑放到Redis中,充分利用其内存速度和原子操作;第二,要善用Redis不同的数据结构(字符串、哈希、列表、集合、有序集合),它们能解决特定场景下的特定问题,而不仅仅是当个简单的键值存储;第三,要有完整的缓存策略思维,包括如何预热、如何更新、如何防止缓存击穿和雪崩,这样才能让Redis真正成为一个稳定可靠的性能加速器。

本文由帖慧艳于2025-12-30发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/71198.html