亚马逊云科技自研芯片Trainuim助力EC2 Trn1实例上线,算力提升明显

- 问答

- 2025-12-28 22:24:06

- 3

(信息主要综合自亚马逊云科技官方新闻发布、技术博客及其高管在社交媒体上的分享)

亚马逊云科技在2022年底做了一件大事,他们把自己设计的、专门用于训练人工智能模型的芯片Trainium,正式用在了新的云计算服务器EC2 Trn1实例上,这意味着,任何公司或个人如果想在云端训练复杂的人工智能模型,比如让AI学会识别图像、理解人类语言、或者进行复杂的科学模拟,现在有了一个全新的、据说更强大的选择。

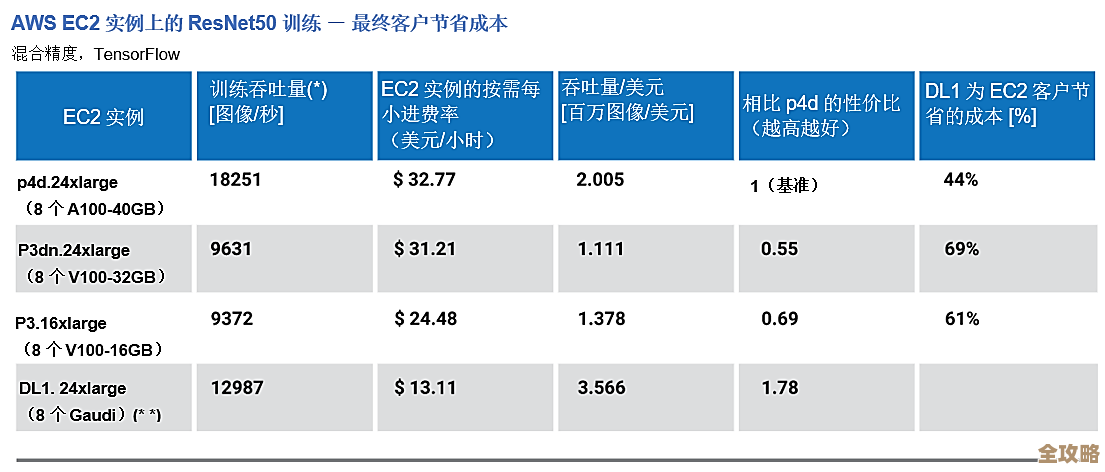

亚马逊云科技自己说,推出Trainium芯片和Trn1实例,是为了解决客户在人工智能训练方面遇到的一个核心难题:成本和速度,随着AI模型变得越来越庞大和复杂,训练它们所需要的计算量呈爆炸式增长,这导致了两个直接后果:一是训练时间被拉得非常长,可能一次训练就要花费几天甚至几周;二是耗费的计算资源成本非常高,给企业带来了沉重的经济负担,亚马逊云科技声称,他们的Trainium芯片就是瞄准了这个痛点,旨在以更低的成本提供更强大的算力。

这个自研的Trainium芯片到底有什么特别之处呢?根据亚马逊云科技官方介绍,它不是一颗通用的处理器,而是专门为深度学习训练任务量身定制的,可以把它想象成一个“专才”,它不像通用CPU(中央处理器)那样什么都能干但可能不精,而是把所有电路设计和资源都优化用于执行矩阵乘法、卷积等AI训练中最常见、最耗时的计算操作,这种专门化的设计,据说能带来极高的计算效率和能源效率,亚马逊云科技提到,与之前基于其他芯片的同类EC2实例相比,Trn1实例在训练流行的自然语言处理和计算机视觉模型时,能够实现高达50%的算力提升,同时还能降低每个训练任务的成本。

除了核心的Trainium芯片,Trn1实例的整体架构也为了高效训练大型模型做了特别优化,亚马逊云科技在其技术博客中详细说明,Trn1实例支持服务器之间超高速的网络互联,这一点对于训练超大规模模型至关重要,因为单个服务器(或芯片)的内存和算力是有限的,必须将模型拆分到成千上万个芯片上同时训练,这些芯片之间需要频繁、高速地交换数据,如果网络速度跟不上,就会形成“瓶颈”,导致大部分芯片闲着等待数据,算力再强的芯片也发挥不出优势,Trn1实例集成了亚马逊自研的EFA(弹性适配器)网络技术,提供了高达800 Gbps的网络带宽,确保了多个Trainium芯片能够高效协同工作,像一个整体一样去训练那些庞大的模型。

亚马逊云科技首席执行官亚当·塞利普斯基在实例上线时曾表示,这标志着云基础设施发展的一个关键转折点,他们正通过自研芯片的创新,为机器学习训练工作负载提供最优异的性价比,他强调,这能帮助更多不同规模的企业更容易地获得先进的AI能力,加速创新。

为了吸引用户尝试这一新实例,亚马逊云科技还推出了配套的软件工具包,名为AWS Neuron SDK,这个工具包的作用是帮助开发者将他们用主流AI框架(如TensorFlow、PyTorch)编写的模型,轻松地部署和运行在Trainium芯片上,尽可能减少代码修改的需要,降低使用的门槛。

一些早期试用Trn1实例的客户也分享了他们的体验,亚马逊云科技提到了一家名为“爱奥尼亚”的生物技术公司,他们利用Trn1实例来加速新药的发现过程,该公司表示,使用Trn1实例后,他们训练用于分子模拟的AI模型的速度显著加快,这使得他们的研究团队能够更快地进行迭代和测试,从而有望缩短药物研发的周期。

亚马逊云科技自研Trainium芯片并推出Trn1实例,是其巩固在云计算和人工智能市场领导地位的重要一步,其核心卖点直指当前AI发展的关键需求:用更少的钱、更短的时间,完成更复杂的AI模型训练,通过硬件(自研芯片)和软件(Neuron SDK)、以及高速网络基础设施的深度结合,亚马逊云科技旨在为开发者和企业提供一个强大且高效的平台,以应对日益增长的人工智能计算挑战。

本文由水靖荷于2025-12-28发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/70283.html