Redis在大数据量处理上的那些事儿,数据多了到底咋办呢

- 问答

- 2025-12-27 15:37:12

- 4

(引用来源:Redis官方文档、多位资深运维工程师的社区分享、高可用架构案例解析)

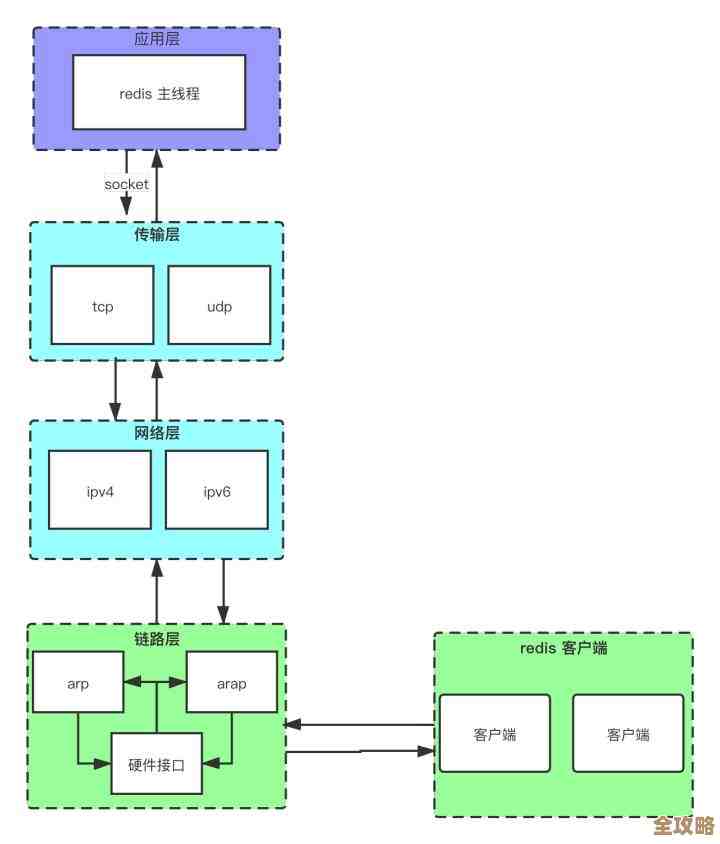

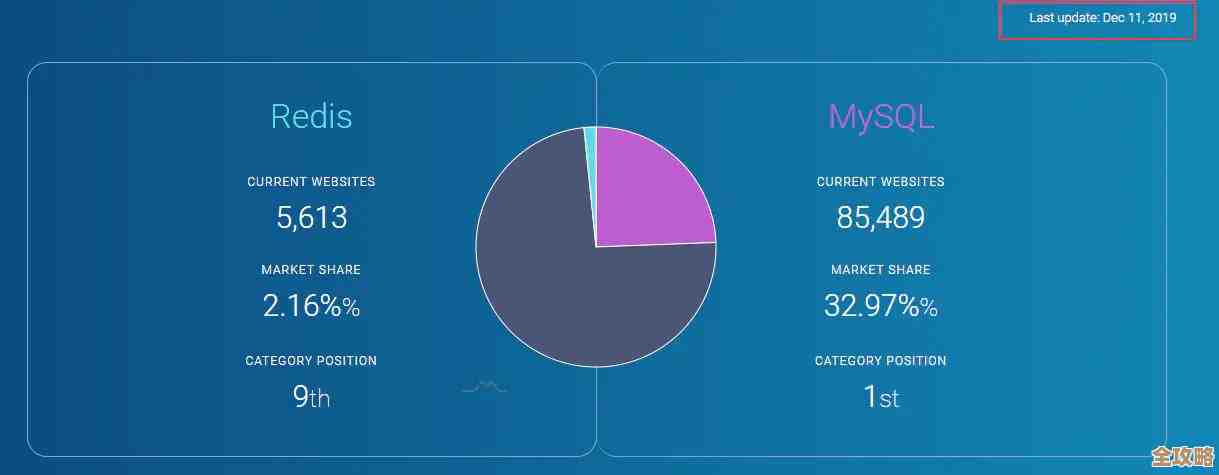

Redis在大数据量处理上的那些事儿,数据多了到底咋办呢?这确实是个让很多用Redis的人头疼的问题,Redis快是快,但它不是魔术师,它的本事都基于一个前提:你得把数据都放在内存里,当你的数据量蹭蹭往上涨,快要撑破内存的时候,或者读写操作多到单台机器快扛不住的时候,麻烦就来了,下面我们就来聊聊,面对这些情况,大家通常是怎么做的。

第一招:从数据本身下手,精打细算

数据多了,最先想到的可能不是加机器,而是看看数据本身有没有“水分”可以挤掉,这就像你搬家,东西太多,先看看有没有旧衣服、旧书可以扔掉一样。

- 设置过期时间(TTL):这是最基本也最有效的一招,很多数据其实是有生命周期的,比如用户的登录会话、短信验证码、临时缓存的计算结果,给这些数据设置一个合理的过期时间,让Redis自动清理,可以省下大量的内存空间,千万别让那些本该“寿终正寝”的数据永远霸占着内存。

- 精简键值对:起键名的时候别太随意,比如存用户信息,你用

user:10001:profile:name可能就比用户10001的姓名这个数据要节省空间,更重要的是值的设计,如果存的是对象,比如用户信息有姓名、年龄、城市等,不要用多个独立的键存,而是用Hash(哈希)结构把它们存到一起,这样Redis管理起来开销更小,还有就是,如果能用数字类型(比如用1、2、3代表状态),就别用字符串(active”, “inactive”)。 - 选择合适的数据结构:Redis提供了好几种数据结构,用对了能省很多事,比如你要统计网站的独立访客,上亿的用户ID如果你用Set(集合)存,内存可能很快就爆了,但如果你用HyperLogLog,可能只需要12KB内存就能完成大概率的去重统计,虽然不100%精确,但很多场景下够用了,再比如,要记录用户最近浏览的10个商品,用List(列表)控制长度,或者用ZSET(有序集合)按时间排序,都很高效。

第二招:升级硬件,简单粗暴

如果数据精简到头了,还是放不下,或者读写压力实在太大,最直接的办法就是“氪金”——升级硬件。

- 加大内存:给服务器插上更大的内存条,这是最立竿见影的方法,但成本也高,而且总会遇到物理上限。

- 使用更快的存储设备:虽然Redis主要操作内存,但持久化(把数据写到硬盘做备份)的时候会用到磁盘,用高性能的SSD硬盘可以大大减少持久化操作对性能的影响。

但硬件升级总有极限,而且成本越来越高,这时候就需要更高级的玩法了。

第三招:分布式架构,化整为零

当单台Redis服务器(我们叫它实例)的能力达到瓶颈时,就必须把数据和请求分散到多台机器上,这就是分布式,主要有两种路子:

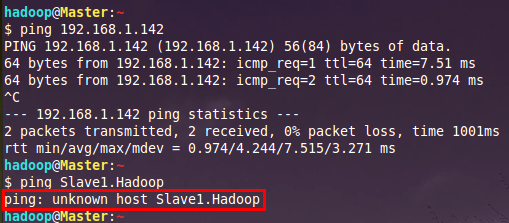

- 读写分离(主从复制):就像公司里老板负责拍板(写数据),然后找一堆秘书(从库)把老板的决定抄送给大家(读数据),你设置一个主库(Master)专门负责接收写操作,然后挂上好几个从库(Slave),主库会把数据同步给从库,这样,所有的读请求都可以分流到从库上去,大大减轻了主库的压力,这个模式还有个好处是提高了可用性,万一主库宕机了,可以选一个从库“扶正”成新的主库,继续服务。

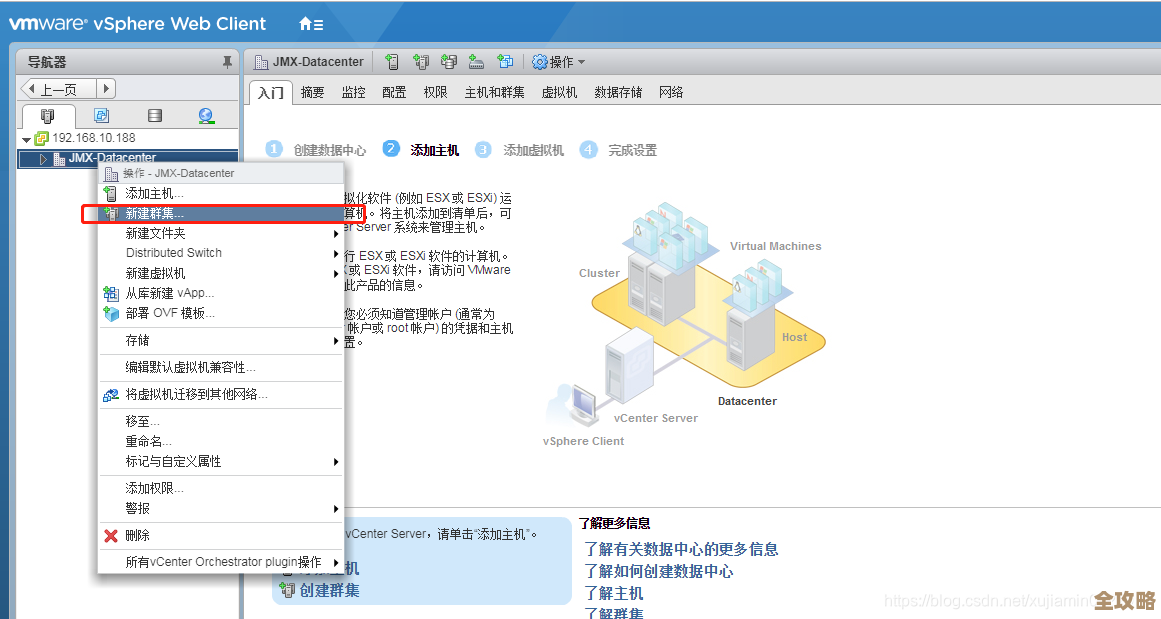

- 分片(Sharding):这是应对海量数据的终极武器,想象一下,一本超级厚的电话簿,一个人查不过来,那就把它撕成几份,分给几个人同时查,Redis分片也是这个道理,你把整个数据集拆分成很多小块(分片),每个分片由不同的Redis实例(甚至可以是不同的服务器)来负责存储和读写,至于怎么分,有很多策略,比如根据键的哈希值取模,或者范围分片等,现在大家通常不会自己手动去搞这么复杂的分片,而是直接使用Redis Cluster(Redis集群),Redis集群自动帮你管理数据分片和在各个节点间的分布,你只要把它当成一个整体的Redis来用就行了,它会自动把请求路由到正确的分片上。

第四招:冷热分离,区别对待

不是所有数据都被频繁访问,比如电商平台,用户最近浏览的商品是“热数据”,需要快速访问;而一年前的订单记录可能就是“冷数据”,偶尔才查一次,把这两种数据混在一起,对昂贵的Redis内存是一种浪费。

- 做法:可以只把最需要速度的“热数据”放在Redis里,那些访问频率很低的“冷数据”,可以定期从Redis里清理出去,然后存到更便宜的存储里,比如MySQL数据库或者云上的对象存储,当用户真的需要访问这些冷数据时,应用层可以先查Redis,查不到再去后端数据库查,虽然慢一点,但毕竟次数少,可以接受,这需要应用代码做一些逻辑判断。

总结一下

数据多了怎么办?不是一个单一答案,而是一个组合拳:

- 先优化:给数据“瘦身”,用好数据结构和过期时间。

- 再扩容:升级硬件,提升单机能力。

- 后分治:用主从复制做读写分离,用集群分片应对海量数据。

- 善取舍:实施冷热数据分离,好钢用在刀刃上。

实际当中,这些方法往往是结合使用的,一个大型应用可能会搭建一个Redis集群,集群里的每个节点本身又是一个主从复制组,并且所有的键都设置了TTL,理解这些策略,就能根据自己项目的实际情况,找到最适合的应对之道。

本文由称怜于2025-12-27发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:https://www.haoid.cn/wenda/69490.html