精通Linux环境:系统优化方法与专业知识点详细剖析

- 游戏动态

- 2025-10-24 12:21:01

- 1

好,咱们聊聊Linux系统优化这事儿吧,其实说“精通”有点吓人,我自己都觉得这词儿太绝对了,哪有什么真正的精通,无非是踩的坑多了,知道哪儿有石头,哪儿是泥潭… 系统优化更是这样,它不像背命令,背熟了就行,它更像是一种…嗯…一种对系统脾气的揣摩,你得知道它在什么情况下会“闹别扭”。

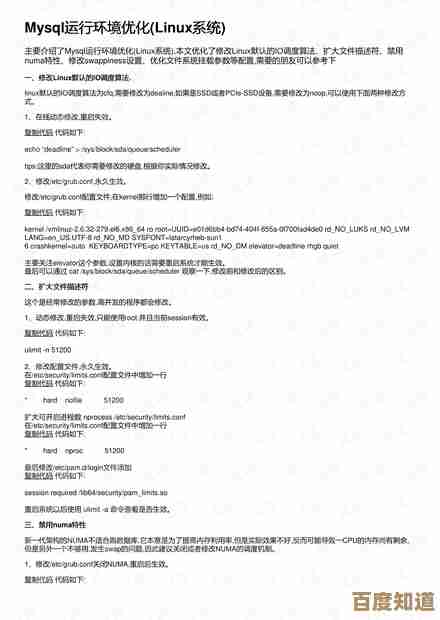

先不说那些高大上的理论,就从最实在的内存管理开始,很多人一看free -h,发现used那么高就慌了,赶紧想着杀进程,其实Linux内核的设计理念就是“不用白不用”,内存闲着也是闲着,它会拿很多来做缓存和buffer,加速磁盘读写,所以真正该看的可能是available那一栏,或者看看/proc/meminfo里的细节,我有次给一台老服务器做优化,那机器跑着个数据库,内存常年95%以上used,老板急得不行,我一看,嚯,缓存占了快一半,其实available还绰绰有余,我就简单调了一下vm.swappiness(这个参数控制内核有多“积极”地把内存数据交换到swap),从默认的60降到10,告诉内核:“没事别老往swap倒腾数据,咱内存还够用”,再加上调整了一下数据库的缓存大小,让它更贴合实际物理内存… 效果立竿见影,磁盘I/O压力一下就下来了,这事儿给我的启发是,优化第一步是理解,而不是蛮干,你得先看懂系统在“想”什么。

然后说到I/O调度器,这个就更有意思了,不同的工作负载,适合的调度器完全不同,比如传统的机械硬盘,用CFQ(Completely Fair Queuing)可能比较公平,但它不一定适合SSD,SSD没有磁头寻道的问题,所以deadline或者noop可能更直接高效,我记得有一次,一个开发环境的虚拟机,IOPS低得令人发指,应用启动慢吞吞的,我一开始以为是磁盘本身不行,后来用iostat一看,队列深度老长老长… 突然想起来这虚拟机用的还是CFQ,我试着换成deadline,好家伙,那种感觉就像…就像便秘突然通畅了,延迟瞬间降了下来,但这种经验没法照搬,你要是换个高并发写入的场景,可能又得重新琢磨,所以你看,优化没有银弹,就是不停地试错、观察。

再说说网络调优吧,这玩意儿水更深,光是一个TCP窗口大小,就能玩出花来,对于高延迟、高带宽的网络(比如跨洋的),默认的TCP窗口可能根本不够用,会导致带宽利用率极低,你得去调整net.ipv4.tcp_rmem和wmem这些参数,但调大了也有风险,万一网络突然抖动,大量的数据包积压在缓冲区,反而会增加延迟,我有个朋友做视频流传输的,他们就为这个参数折腾了好几个星期,反复用tcpping和iperf测试,才找到一个在稳定性和吞吐量之间的平衡点,这个过程很枯燥,但一旦调好了,那种成就感,就跟老中医开对了方子一样。

还有文件系统,ext4, XFS, Btrfs… 各有各的脾气,XFS在处理大文件时很生猛,但万一文件系统真出了点问题,修复工具可比ext4的fsck麻烦多了,Btrfs功能花哨,快照、压缩啥的,但早些年我遇到过写放大问题,差点丢了数据,从此对它有点心理阴影,选什么,真的得看业务场景,你不能听别人说XFS好就无脑上,万一你主要是海量小文件呢?

说到内核参数调优,/etc/sysctl.conf里那一大堆,看着就头大,但说实话,大部分情况下你根本不用动它们,内核开发者们已经做了很好的默认设置,盲目地去网上抄一段“性能优化”参数贴进去,很可能适得其反,我自己的习惯是,遇到具体问题,比如TIME_WAIT连接太多,或者端口不够用了,再去有针对性地查文档,调整像net.ipv4.tcp_max_tw_buckets这样的特定参数,优化,应该是外科手术式的,而不是地毯式轰炸。

最后我想说,工具固然重要,但比工具更重要的是监控和观察的习惯,你得学会用top/htop看实时状态,用vmstat看内存和CPU瓶颈,用iostat看磁盘,用sar看历史趋势… 把这些命令当成你的听诊器、血压仪,系统优化不是一锤子买卖,它是一个持续的过程,你今天调好了,可能明天业务量上来了,瓶颈又换地方了。

别被“精通”两个字吓到,Linux优化这条路,就是不断地遇到问题,然后像侦探一样,根据日志、监控指标这些线索,去推断系统的“病因”,再小心翼翼地“用药”,这个过程里,你会烦躁,会熬夜,会对着一个诡异的性能毛刺百思不得其解,但当你最终找到那个关键点,并看着系统恢复顺畅的时候,那种豁然开朗的感觉,才是真正让人上瘾的东西,它不完美,但很真实。

本文由频妍妍于2025-10-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/yxdt/41505.html