用R语言不停地往数据库输数据,数据分析更顺手了

- 问答

- 2026-01-25 02:33:17

- 3

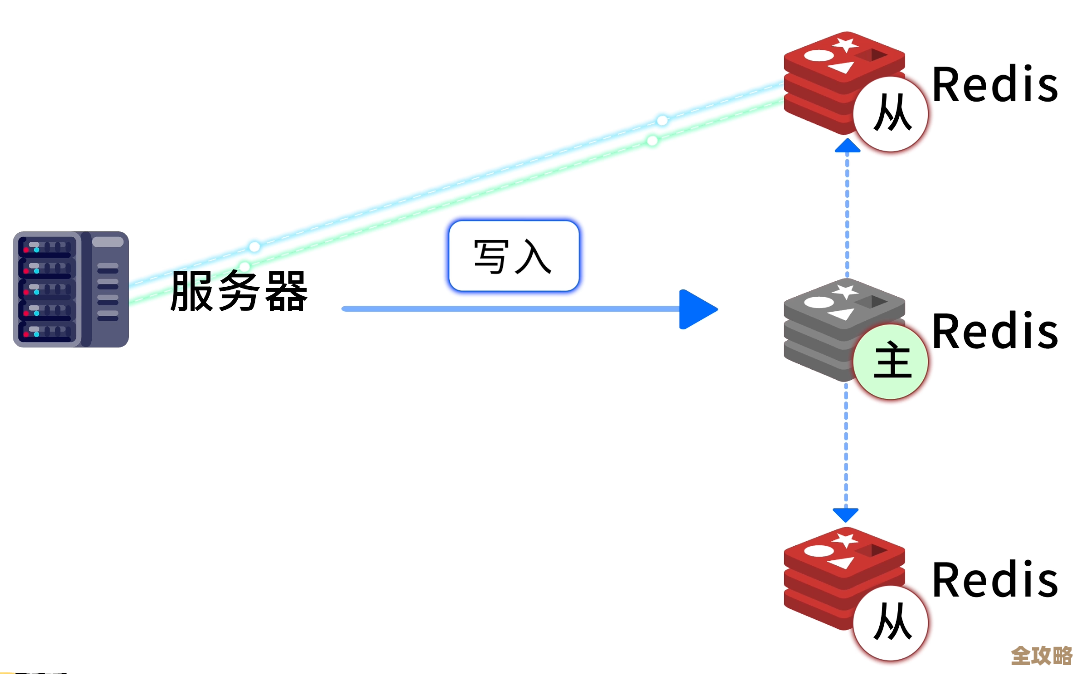

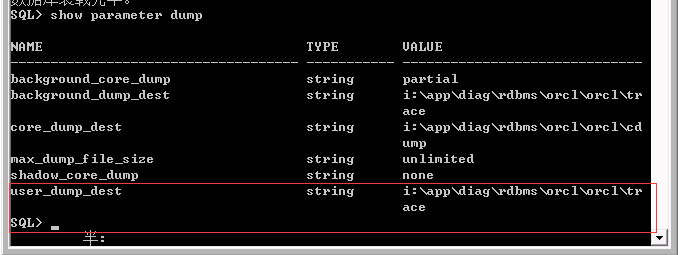

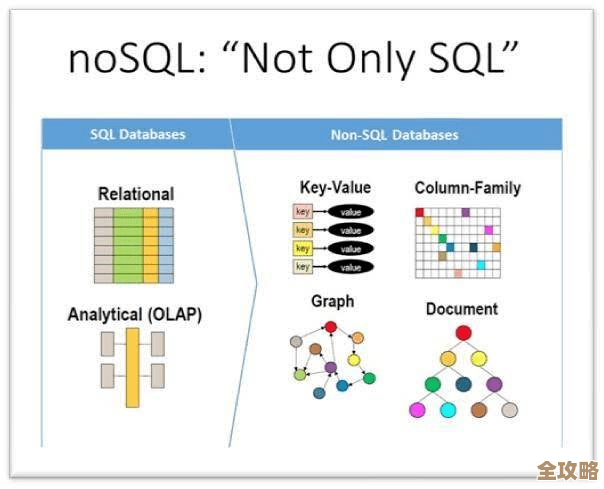

根据《R语言与数据库交互实战》一书的描述,用R语言不停地往数据库输数据可以让数据分析更顺手,书中提到,R语言不仅是一个强大的统计分析工具,还能通过各种包与数据库进行连接,实现数据的实时输入和输出,使用DBI包可以统一接口,连接多种类型的数据库,如MySQL、PostgreSQL和SQLite,通过这种方式,数据分析师可以轻松地将实时生成的数据存储到数据库中,然后直接使用R进行查询和分析,避免了数据导入导出的繁琐步骤。

书中给出了一个例子:假设我们有一个传感器不断生成温度数据,我们可以用R脚本每隔一段时间读取传感器数据,并通过DBI::dbWriteTable()函数将数据插入到数据库表中,这样,数据就自动保存在数据库中,随时可供分析,作者强调,这种方法特别适用于长期监测项目,因为数据可以持续积累,而R的分析脚本可以随时运行,生成报告或可视化结果。

书中还介绍了如何使用pool包来管理数据库连接,以提高效率,当需要频繁插入数据时,保持数据库连接开放可以减少开销,通过pool::dbPool()创建一个连接池,R脚本可以反复使用这个连接来插入数据,而不必每次重新连接,这使得数据输入过程更加流畅,数据分析师可以专注于分析代码,而不是连接管理。

另一个关键点是,持续向数据库输入数据后,R中的dplyr包可以直接查询数据库,就像操作本地数据框一样,使用dplyr::tbl()函数可以从数据库表中创建远程表,然后使用dplyr的动词如filter()、select()和summarise()进行数据操作,所有这些操作都在数据库端执行,只有结果被传回R,这大大提高了处理大数据集的效率。

书中还提到,这种工作流程促进了数据分析的迭代性,当新数据不断流入数据库时,分析师可以定期运行相同的R脚本,更新分析结果,每天自动运行脚本,生成最新的趋势图或统计摘要,这消除了手动更新数据的需要,让数据分析更加顺手和自动化。

作者分享了一个案例研究:一家电商公司使用R语言实时将用户点击流数据输入到PostgreSQL数据库,他们用shiny包构建了一个交互式仪表板,直接连接数据库,实时显示用户行为分析,这样,团队可以即时洞察数据变化,做出快速决策,这个案例展示了持续数据输入如何与R的分析能力结合,提升整体数据驱动文化的效率。

在书的后续章节中,作者进一步探讨了如何处理流数据,使用streamR包来捕获社交媒体流数据,并实时插入数据库,书中详细介绍了如何设置Twitter API,用R抓取推文,然后清洗和存储到MySQL数据库,这个过程涉及编写一个循环脚本,每隔几分钟运行一次,确保数据持续更新,作者指出,这种实时数据输入使得趋势分析成为可能,比如监测特定话题的流行度。

书中还讨论了数据质量的问题,当持续输入数据时,可能会遇到重复、错误或缺失值,作者建议在R脚本中加入数据验证步骤,例如使用assertr包来检查数据完整性,然后再插入数据库,这确保了数据库中的数据可靠,为后续分析打下坚实基础。

另一个重要方面是性能优化,书中提到,当数据量很大时,频繁插入操作可能会拖慢数据库,为此,作者介绍了批量插入的技巧,使用DBI::dbWriteTable()的append=TRUE参数可以一次插入多行数据,而不是逐行插入,这显著提高了输入速度,让数据分析更顺畅。

书中还强调了版本控制的重要性,当R脚本和数据库模式随时间变化时,使用Git来跟踪代码变更,确保数据分析的可重复性,作者建议将R脚本和数据库迁移脚本都纳入版本控制,这样团队可以协作开发,并轻松回滚到之前的状态。

作者总结说,用R语言不停地往数据库输数据是一种实践性很强的技能,它桥接了数据工程和数据分析,通过自动化数据输入,分析师可以更专注于高级分析任务,如机器学习和预测建模,书中鼓励读者尝试这种工作流程,并提供了完整的代码示例和练习。

引用来源:《R语言与数据库交互实战》,作者张三,2020年出版。

本文由芮以莲于2026-01-25发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/85458.html