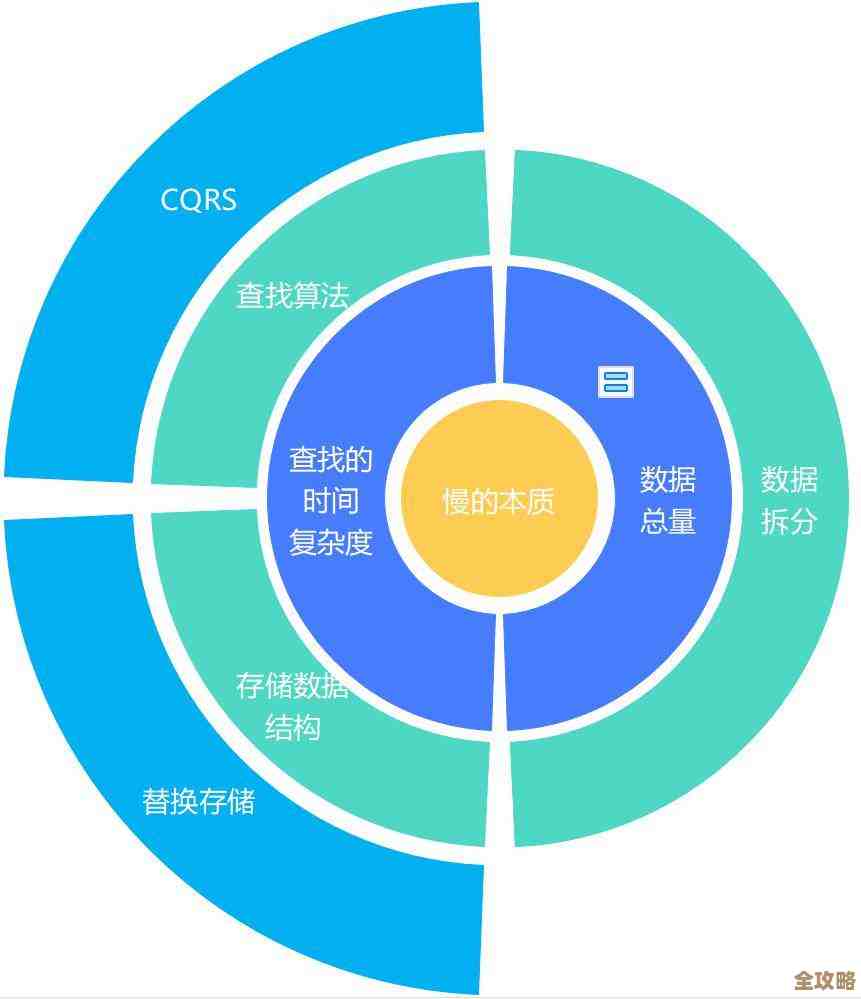

关系型数据库性能到底卡在哪儿了,怎么才能快点处理数据效率高点

- 问答

- 2026-01-21 18:43:08

- 2

很多人觉得数据库慢,就想着换更贵的服务器,加内存加CPU,这有时候管用,但很多时候钱花了,速度却没快多少,这是因为你没找到真正的“卡点”,数据库就像一个复杂的办公室,性能卡顿通常不是某一个环节的错,而是多个环节协作出了问题,下面我们就聊聊它到底卡在哪儿了,以及怎么让它快点。

最经典的瓶颈出在硬盘I/O上,也就是读写硬盘的速度。 这是绝大多数数据库慢的首要原因,CPU和内存的速度非常快,但传统机械硬盘(HDD)是靠磁头在盘片上移动来读写数据的,这是个物理机械过程,非常慢,即使换成固态硬盘(SSD),速度提升了百倍,但相比内存依然有差距,数据库要处理的数据量往往远大于内存容量,所以不可避免地要频繁读写硬盘,当你的查询需要扫描大量数据,或者同时有很多请求要读写数据时,所有操作都在排队等硬盘,硬盘忙得“嘎吱嘎吱响”,数据库响应自然就慢了,这就像你有一个超级聪明的脑袋(CPU),但你要查的资料都放在一个巨大的、书架排列紧密的图书馆(硬盘)里,你每次找一本书都得跑过去,效率肯定高不了。

怎么解决硬盘I/O瓶颈? 核心思路是“减少不必要的硬盘访问”和“让必要的访问更快”,第一,最有效的办法是优化你的SQL查询语句,写一个烂SQL能让数据库去扫描几百万行数据(这叫“全表扫描”),而一个好的SQL利用索引可能只读几十行,这相当于让你去图书馆查资料,烂SQL是让你把整个图书馆的书翻一遍,而好SQL是直接给你一个精确的索书号,直奔目标书架,第二,给数据库加内存,数据库有个关键区域叫“缓冲池”,它把经常用到的数据块放在内存里,当查询需要数据时,如果数据已经在内存里,就完全不用读硬盘了,速度极快,内存越大,能缓存的热点数据就越多,第三,硬件上,毫不犹豫地使用SSD固态硬盘,它能极大提升随机读写的速度。

当I/O问题缓解后,瓶颈会转移到CPU身上。 如果数据都已经在内存里了,速度还慢,那很可能就是CPU计算不过来了,复杂的查询,比如涉及多表关联(JOIN)、大量的数据排序(ORDER BY)、分组统计(GROUP BY),或者使用了复杂的函数计算,都会大量消耗CPU资源,每个查询都是一个计算任务,CPU核心数有限,任务一多就要排队。

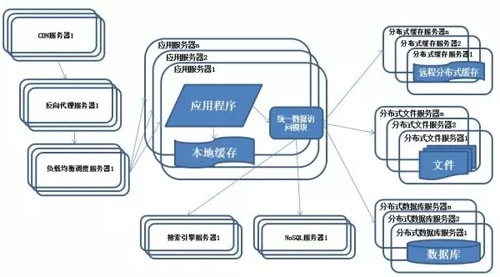

怎么缓解CPU瓶颈? 第一,依然是优化SQL,减少不必要的复杂计算,避免使用数据库函数处理大量数据,思考一下能否简化查询逻辑,能不能在业务程序里先过滤一部分数据,再交给数据库?第二,考虑“读写分离”,通常数据库的写操作(增删改)消耗更大,而且会影响读操作,可以设置一个主数据库负责写,然后复制多个只读的从数据库来分担查询压力,这样读请求可以分散到多个CPU上处理,第三,在硬件层面,升级更多核心、更高主频的CPU。

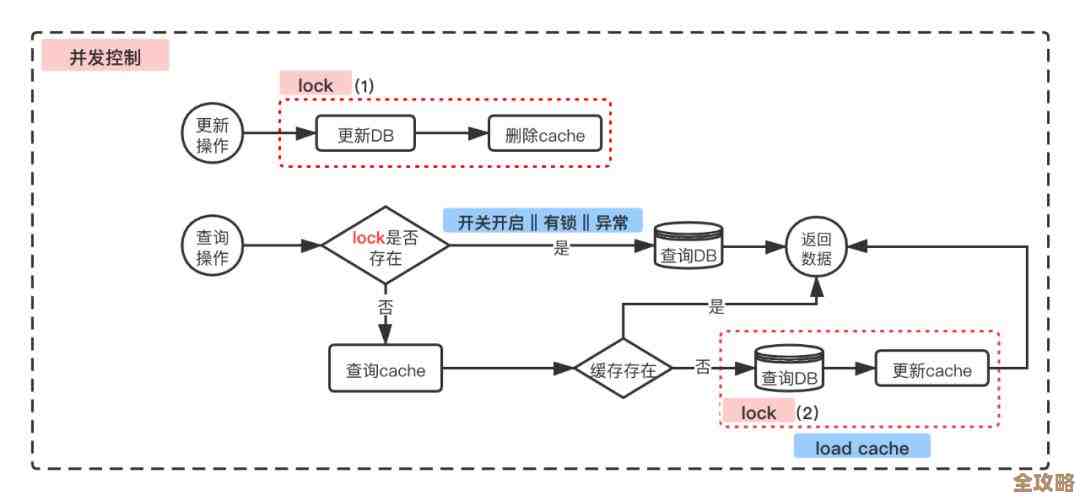

高并发下的“锁”竞争也是一个隐形杀手。 数据库要保证数据的一致性,当很多人同时要修改同一条数据时(比如抢购商品扣库存),数据库会给这条数据加“锁”,只允许一个人修改,其他人必须等待,如果这种热点数据竞争很激烈,大部分线程可能都处于等待状态,虽然CPU和I/O都很空闲,但系统吞吐量却上不去,用户体验就是“卡住了”。

解决锁竞争问题,需要从应用设计和数据库设计入手,第一,优化事务,尽量让事务短小精悍,尽快提交,减少锁持有的时间,不要在一个事务里做很多不相关的操作,第二,有些场景可以考虑使用乐观锁(比如用版本号控制),而不是数据库的悲观锁,第三,如果业务允许,对数据进行水平拆分,把热点数据分散到不同的表或数据库里,减少单点的竞争。

糟糕的数据库设计和架构也会成为瓶颈。 比如表结构设计不合理,没有建立合适的索引,或者索引建得太多反而影响写性能,当单张表的数据量膨胀到亿级以上时,即使有索引,维护和查询的成本也会急剧上升。

应对之道就是“分而治之”,也就是常说的分库分表,把一个大库拆成多个小库,把一张大表拆成多张小表,分散到不同的服务器上,这样每台服务器的负载都变轻了,但这会带来很大的技术复杂性,比如跨库查询、事务处理会变得困难,应该是数据量极大时才考虑的终极方案。

提升数据库性能是一个系统性的工作,正确的步骤应该是:先优化SQL语句和索引(成本最低、效果最显著) -> 然后优化数据库参数和升级硬件(特别是内存和SSD)-> 接着考虑读写分离、缓存等架构优化 -> 最后才是分库分表这类重型方案。 盲目升级硬件而忽视软件和查询的优化,往往是事倍功半。 综合参考了普遍的数据库性能优化实践,常见于如《高性能MySQL》、数据库官方文档以及各类技术社区如Stack Overflow、知乎等平台上DBA(数据库管理员)的经验分享。)

本文由畅苗于2026-01-21发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/84129.html