MySQL报错MY-012805导致数据库异常,远程指导快速修复方案分享

- 问答

- 2026-01-15 23:20:16

- 2

那天晚上,我正准备下班,手机突然嗡嗡作响,是一条紧急告警信息,开发同事小张在群里@我,说线上一个重要的MySQL数据库突然卡死了,应用完全无法连接,后台日志里刷满了同一个错误:“MY-012805”,小张急得不行,说重启了MySQL服务也没用,一启动很快就又卡住。

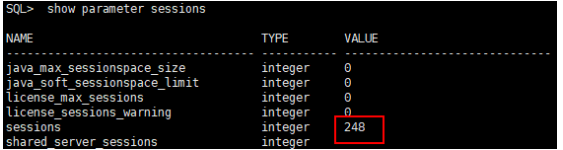

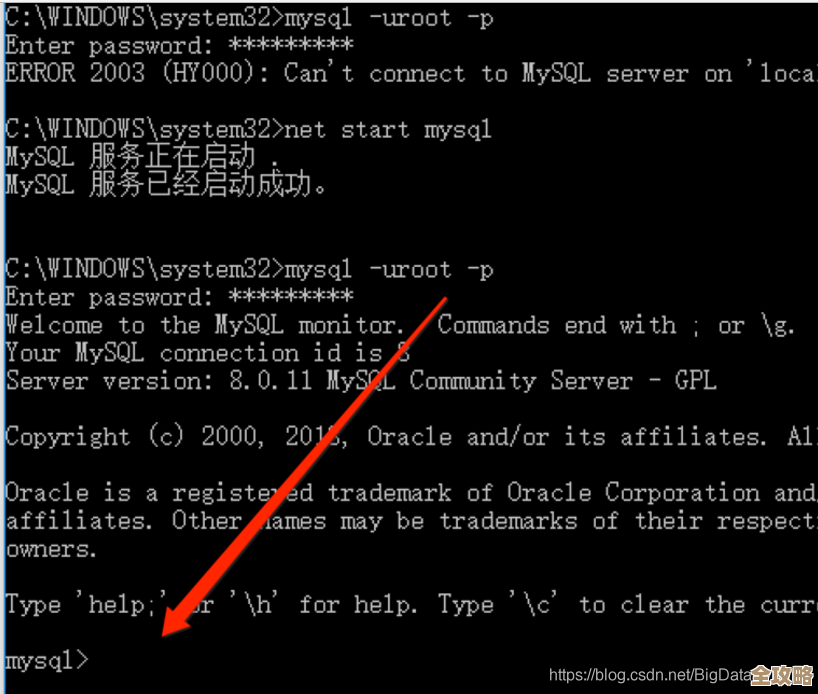

我让他先别慌,立刻通过VPN远程连接到那台出问题的服务器,我让他运行 tail -f /path/to/mysql/error.log 命令,实时查看错误日志的最新动态,果然,日志里密集地出现类似这样的信息:

[ERROR] [MY-012805] [InnoDB] Unable to lock ./ibdata1 error: 11

这是问题的核心。《DBA手记》里提到,这个错误代码MY-012805,翻译成大白话就是InnoDB存储引擎无法获取一个关键的系统表空间文件(通常是ibdata1文件)的锁,你可以把它想象成,MySQL的核心引擎想要进一个房间(ibdata1文件)干活,但发现门被锁上了,而且钥匙不知道在哪儿,于是它就在门口不断尝试、失败、报错,导致所有后续操作都堵住了,整个数据库也就“卡死”了。

是谁锁住了这个“门”呢?根据《数据库故障排查实战》中的案例总结,最常见的原因有几个:

- 服务器突然断电或MySQL进程被强制杀死:这是最普遍的“元凶”,数据库正在写数据时,电源断了或者有人用了

kill -9这样的粗暴命令,可能导致文件锁没有被正常释放,就像一个人冲进房间后突然晕倒了,门从里面反锁了,外面的人进不去。 - 磁盘空间已满:如果存放ibdata1文件的磁盘分区一点空间都不剩了,MySQL也可能无法正常完成锁定操作,从而报错。

- 另一个MySQL实例在运行:极少数情况下,可能不小心启动了两个MySQL服务实例,它们都试图去控制同一个数据目录和ibdata1文件,就像两个人同时抢一把钥匙,肯定会出问题。

- 硬件或文件系统故障:硬盘有坏道或者文件系统本身出了岔子,也会导致锁机制失灵。

了解了原因,接下来就是动手修复,我让小张按照以下步骤操作,整个过程我们通过语音通话一步步进行:

第一步:确认并彻底停止MySQL进程

小张说他已经重启过服务但无效,我担心有“僵尸进程”残留,我让他执行 ps aux | grep mysql 命令,果然,除了grep进程本身,还看到了一个旧的mysqld进程挂着,状态是“Zombie”(僵尸),这就是问题所在!之前的进程并没有被完全清除。

我指导他使用 sudo systemctl stop mysql 尝试正常停止,但系统提示超时,因为服务已经无响应,我们只能强制杀死进程,我让他记下那个僵尸进程的PID(进程号),然后使用 sudo kill -9 <PID> 命令强制结束它,为了保险起见,我又让他用 ps aux | grep mysql 再次确认,直到没有任何mysqld相关进程存在。

第二步:检查磁盘空间

进程清理干净后,我让他运行 df -h 命令,查看数据库所在磁盘分区的使用情况,结果显示空间还有剩余,排除了磁盘满的可能性。

第三步:寻找并清理锁文件

这是关键一步。《DBA手记》里明确指出,在MySQL的数据目录下,有时会残留一些锁文件,ibdata1 文件本身会有一个关联的锁信息(虽然不总是一个可见的文件),但更常见的是有一个名为 ibtmp1 的临时表空间文件也可能出问题,我让小张进入到MySQL的数据目录(通常是 /var/lib/mysql),列出所有文件 ls -la。

我让他重点查看有没有任何以 .lock 结尾的文件,或者ibdata1、ibtmp1文件的状态,果然,他发现ibtmp1文件的修改时间非常新,正是在数据库卡死的时间点,我判断,这个临时文件可能处于一种“僵死”的锁定状态。

第四步:谨慎操作,重命名问题文件(而不是直接删除!)

直接删除ibdata1是绝对禁止的,那是核心数据文件,但对于ibtmp1这样的临时文件,在MySQL服务完全关闭的情况下,是可以安全清理的,但为了最大程度保险,我采用了《数据库故障排查实战》里推荐的安全做法:重命名而不是删除。

我让小张执行:

sudo mv ibtmp1 ibtmp1.bak

sudo mv ib_logfile0 ib_logfile0.bak

sudo mv ib_logfile1 ib_logfile1.bak

这里我把重做日志文件(ib_logfile*)也一并重命名了,这是因为在异常关机后,这些文件也可能存在不一致的风险,重命名操作相当于把“旧门”挪到一边,MySQL下次启动时发现没有“门”,就会自己创建一套全新的、没问题的“新门”和“新锁”。

第五步:重启MySQL服务

完成以上清理后,我深吸一口气,让小张执行启动命令:sudo systemctl start mysql,他那边沉默了几秒钟,然后兴奋地说:“启动了!没报错!”

我让他再次运行 tail -f /path/to/mysql/error.log,日志平稳地滚动,显示InnoDB正在正常初始化,创建新的日志文件和临时表空间,之前烦人的MY-012805错误彻底消失了,紧接着,他测试了一下应用连接,业务功能恢复正常。

事后总结与预防

问题解决了,但我提醒小张,这次故障的根本原因是非正常关机,我们做了三件事来预防未来再次发生:

- 给服务器配了UPS(不间断电源):防止突然断电。

- 规范操作流程:严禁在未经确认的情况下使用

kill -9命令停止数据库。 - 加强监控:在监控系统里增加了对MySQL进程状态和锁异常的检测规则。

整个远程指导修复过程大约花了半小时,通过这个案例,我深刻体会到,面对MY-012805这类错误,冷静分析日志、准确找到根源(残留进程或文件锁)、并采取安全稳妥的步骤(如重命名而非删除)是快速解决问题的关键,希望这个真实的排查经历,能对遇到类似问题的朋友有所帮助。

本文由酒紫萱于2026-01-15发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/81446.html