Redis集群里几个库之间同步的问题和一些探索想法

- 问答

- 2026-01-14 07:24:57

- 3

在Redis集群环境中,数据同步是保证服务高可用和数据一致性的核心环节,这里所说的“几个库之间的同步”,主要指的是Redis Cluster模式下,主节点(master)和其对应的从节点(replica/slave)之间的数据复制,以及在不同场景下可能涉及的多活数据中心之间的同步,这个过程并非总是完美无缺,会遇到一些典型的问题,也引发了许多改进的思考。

主从同步中的典型问题

Redis主从同步的基本原理是,从节点连接到主节点后,主节点会先将当前内存中的数据快照(RDB文件)发送给从节点,然后再持续地将接收到的新的写命令发送给从节点,这个过程看似直接,但隐藏着几个关键问题。

数据不一致的窗口期,在从节点刚刚连接上主节点,或者主从连接因网络问题中断后重连时,主节点需要生成并传输整个数据集的RDB快照,在这个过程中,主节点仍然在正常处理客户端的写请求,这意味着,当从节点接收并加载完RDB文件后,它相对于主节点已经落后了从生成RDB开始到现在的一段时间的数据,主节点会把这部分增量数据缓存在一个叫做“复制缓冲区”(replication buffer)的地方,如果这段时间的写操作非常多,导致复制缓冲区被撑满,主节点会丢弃旧的增量数据,主从同步将无法继续基于增量数据追上,只能触发一次全新的全量同步(重新传RDB文件),这会导致从节点有较长时间的数据落后,甚至可能永远无法达到一致状态,除非重启同步,这是导致客户端在从节点上读到旧数据的主要原因之一。

网络分区带来的脑裂问题,假设一个集群发生了网络分裂,一部分客户端无法连接到主节点A,但可以连接到它的从节点A1,如果这个分裂时间足够长,哨兵(Sentinel)或集群模式本身可能会将A1提升为新的主节点,网络的两边各有一个主节点,都可以接受写操作,当网络恢复后,这两个主节点会尝试同步数据,但Redis默认会保留拥有最新数据的主节点(通过比较复制偏移量等),而将另一个主节点的数据丢弃,这会导致在网络分区期间,写入到旧主节点A上的所有数据全部丢失,对于客户端来说,这部分已确认的写入神秘消失了,这是非常严重的数据一致性问题。

再者是性能与资源开销,主从全量同步是一个资源密集型操作,主节点需要fork一个子进程来生成RDB文件,这个过程在数据量大时会导致CPU和内存的峰值使用(尤其是内存,fork操作涉及写时复制机制,可能瞬间占用大量内存),传输几个GB甚至更大的RDB文件会占用大量网络带宽,可能影响集群的正常服务性能,在高负载的生产环境中,频繁的主从切换或网络抖动引发的全量同步,可能会引发连锁反应,拖垮整个集群。

针对同步问题的一些探索和想法

面对上述问题,社区和业界一直在进行探索和优化。

关于减少全量同步,一个重要的思路是优化复制缓冲区的管理,可以考虑让复制缓冲区变得更大,或者采用更智能的淘汰策略,而不是简单地丢弃旧数据,更根本的探索是尝试实现一种“无盘复制”的增强版,或者类似数据库领域的逻辑日志复制,避免每次全量同步都需要传输巨大的RDB文件,而是能够从某个精确的点开始重放操作日志,但这需要改变Redis底层持久化的设计,实现起来比较复杂。

对于脑裂和数据丢失问题,除了常规的合理配置min-replicas-to-write参数(要求主节点必须有至少N个从节点连接时才接受写操作,增加数据冗余)外,一些探索方向集中在客户端和应用层,可以引入一种“写令牌”或“ fencing token”机制,当客户端向主节点写入时,主节点分配一个单调递增的令牌,客户端在读取数据时,可以携带最后写入的令牌,从节点需要确保数据至少更新到这个令牌版本后才能返回,这可以在一定程度上避免读到网络分区期间的旧主数据,另一种思路是实现最终一致性的冲突解决机制,类似于一些分布式数据库的做法,当发生脑裂合并后,不是简单地丢弃一方数据,而是尝试自动合并或至少标记出冲突让应用层处理,但这与Redis简单数据模型的初衷有所背离。

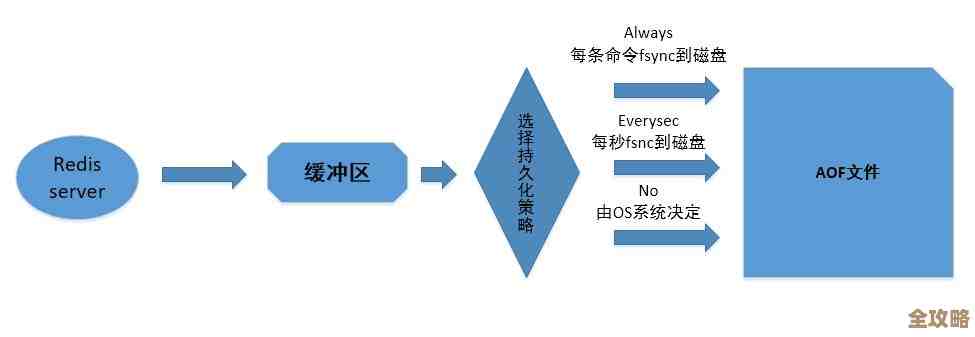

在跨地域多活同步方面,标准的Redis集群并不是为跨广域网的多活设计的,常见的探索是使用外部的数据同步工具,比如利用Redis的复制流(AOF文件或直接解析复制协议),在一个数据中心的主节点和另一个数据中心的主节点之间建立异步复制通道,这种方式可以满足灾难恢复的需求,但同样会带来双向复制的数据冲突问题,一个可行的想法是采用“单元化”架构,即对数据进行分片,并规定特定分片的数据只能由特定地理位置的客户端写入(流量路由),从根源上避免冲突,读取则可以在本地数据中心的从节点进行,实现读操作的异地多活。

监控和自愈也是一个重要的探索领域,通过更精细的监控,不仅要监控主从节点是否连接,还要监控复制延迟的毫秒数、复制缓冲区的大小等关键指标,当发现延迟过大或缓冲区即将满时,可以提前预警或自动进行干预,比如将负载过高的主节点上的部分数据迁移到其他节点,从而防患于未然。

Redis集群的数据同步在提供高性能和可用性的同时,也伴随着一致性、可靠性方面的挑战,解决这些问题没有银弹,往往需要在一致性、可用性、性能和复杂度之间做出权衡,当前的许多探索都围绕着如何让这个权衡的代价更小,让Redis在更复杂的分布式场景下也能稳定可靠地运行。

本文由太叔访天于2026-01-14发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/80418.html