多服务器环境下多个数据库之间实现数据实时同步的技术和挑战探讨

- 问答

- 2026-01-07 00:31:17

- 19

在多服务器环境下,多个数据库之间的数据实时同步是一个复杂但至关重要的需求,这种需求常见于大型互联网应用、金融系统、跨地域运营的企业等场景,其核心目标是确保分布在不同物理位置或逻辑单元上的数据副本,能够在源数据发生变化后的极短时间内保持一致。

实现数据实时同步的主要技术

实现数据实时同步的技术路径多样,选择哪种方案取决于具体的数据库类型、业务容忍度和技术架构,以下是一些主流的技术思路:

-

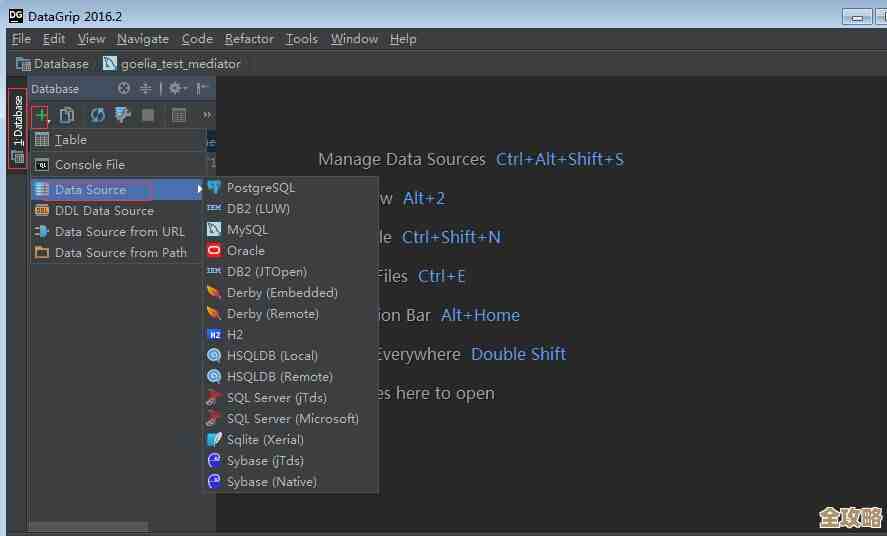

基于数据库日志的捕获与传递(Change Data Capture, CDC) 这是目前最常用且对源数据库性能影响较小的方式,其原理是,几乎所有主流数据库(如MySQL的binlog、PostgreSQL的WAL日志、Oracle的Redo Log)都会将所有的数据变更操作(增、删、改)以日志的形式记录下来,用于崩溃恢复等,CDC工具(如Debezium、Canal)会像一个小“侦探”,持续监控并解析这些日志文件,从中提取出数据变更的详细信息(变更了哪张表、哪行数据、变更前后的值等),将这些变更信息转换成一种通用的数据格式,再发送到消息队列(如Kafka)或直接应用到目标数据库,这种方式避免了直接查询业务数据库表所带来的压力,实现了低延迟的实时同步,根据Percona公司的技术文章所述,CDC是构建实时数据流架构的基石。

-

基于触发器的同步 这是一种相对传统的方法,在源数据库的表上创建触发器(Trigger),当数据发生插入、更新或删除操作时,触发器会自动执行一段预定义的代码,这段代码负责将变更的数据写入一张特殊的“增量表”,或者直接调用某个程序将数据发送到目标数据库,这种方法的优点是实现逻辑直观,与具体业务代码解耦,但其缺点也非常明显:会在源数据库的每次写操作上增加额外的开销,可能严重影响数据库的写入性能,在高并发场景下尤其突出,在现代高负载系统中,这种方式已逐渐被CDC取代。

-

基于应用程序的双写(Dual Write) 这种技术将同步的责任完全交给了应用程序,当业务逻辑需要更新数据时,应用程序会在一个事务(或尝试以事务方式)内,同时向两个或多个数据库执行写操作,这种方法的优势是控制粒度细,应用程序可以决定哪些数据需要同步、如何转换等,非常灵活,但其最大的挑战在于如何保证多个写操作的一致性,如果第一个数据库写入成功,但第二个数据库写入失败,就会导致数据不一致,虽然可以通过分布式事务(如两阶段提交,2PC)来尝试解决,但分布式事务本身非常复杂,会降低系统性能并影响可用性,Martin Fowler在其博客中曾指出,双写模式是“一种已知的、容易导致数据一致性问题的模式”,需要谨慎使用。

-

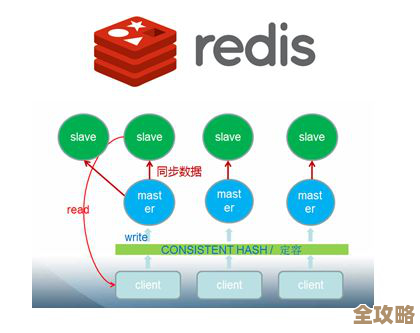

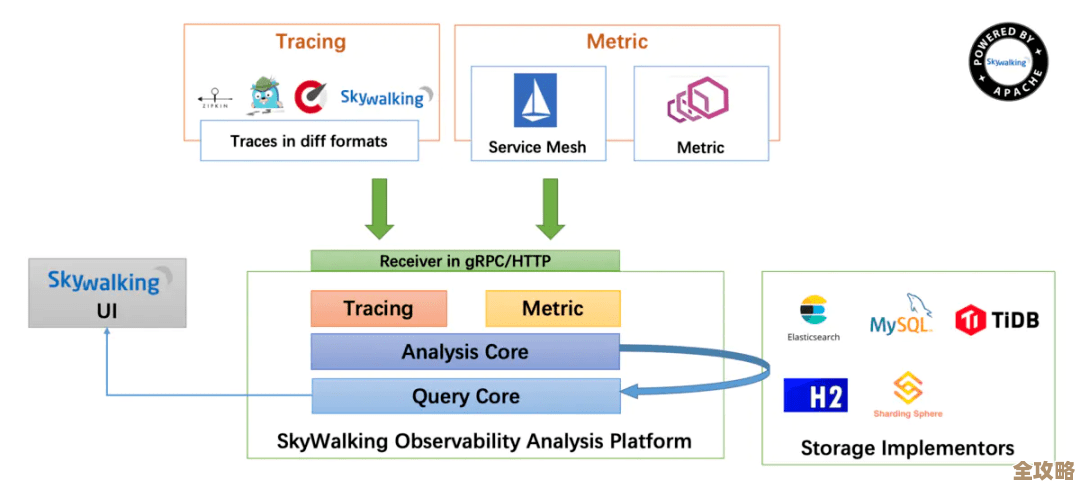

使用数据库中间件或全局数据库 另一种思路是引入一个抽象的中间层,数据库中间件(如ShardingSphere、Vitess)或全球分布式数据库(如TiDB、CockroachDB)在内部集成了数据同步和复制机制,对应用程序来说,它好像只是在操作一个单一的数据库,而中间件或分布式数据库底层则负责将数据自动、透明地同步到多个节点或副本,这种方式极大简化了应用开发的复杂度,但将技术挑战转移到了中间件或数据库本身,对运维团队的技术能力要求较高。

面临的主要挑战与考量

无论采用哪种技术,实现稳健的实时同步都会面临一系列共同的挑战:

-

数据一致性的终极难题 “实时”往往意味着“最终一致性”,即允许数据在极短时间内不同步,但最终会达成一致,而要保证跨数据库的“强一致性”(即任何时候查询所有副本数据都完全一致)极其困难,通常会以牺牲性能和高可用性为代价,在网络分区或节点故障时,如何在一致性和可用性之间做出取舍(即CAP理论中的选择)是系统设计者必须面对的核心问题。

-

同步延迟与性能瓶颈 同步过程本身需要时间:日志解析、网络传输、目标库写入等每个环节都可能产生延迟,在高流量冲击下,如果目标数据库写入速度跟不上源数据库的变更速度,就会造成数据堆积,延迟会越来越大,这不仅影响了数据的“实时性”,还可能拖垮整个同步链路,必须对同步链路的性能进行持续监控和优化。

-

网络不稳定性的影响 多服务器环境,尤其是跨地域的环境,网络是最大的不确定因素,网络抖动、延迟增高甚至中断都会导致同步失败,系统必须具备良好的容错和重试机制,确保在网络恢复后能够从断点继续同步,而不是从头开始,同时要能处理因重试可能带来的数据重复问题(要求目标端有幂等处理能力)。

-

数据冲突的处理 在允许双向同步(多主复制)的架构中,如果两个地理位置的用户几乎同时修改了同一份数据的不同副本,就会产生数据冲突,系统必须有一套可靠的冲突检测和解决机制,例如采用“最后写入获胜”(LWW)、基于时间戳、或由业务规则定制等策略,自动或手动解决冲突,否则数据将陷入混乱。

-

schema变更的管理 当源数据库的表结构需要变更(如增加字段、修改字段类型)时,同步流程很容易被打破,目标数据库必须提前或同时进行兼容的schema变更,否则同步程序可能会因为字段不匹配而报错中断,这要求数据库的变更管理流程必须是严谨的、自动化的。

多数据库实时同步是一项系统工程,没有一劳永逸的解决方案,技术选型需要在数据一致性要求、系统性能、实现复杂度和运维成本之间进行精细的权衡,成功的同步方案往往结合了稳健的技术基础(如CDC)、清晰的架构设计(如通过消息队列解耦)以及完善的运维监控体系。

本文由盘雅霜于2026-01-07发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/75882.html