云原生监控那些事儿,从底层到应用全方位拆解和讲透

- 问答

- 2026-01-01 09:48:51

- 3

主要综合了网络技术社区如InfoQ、博客园,以及开源项目官方文档如Prometheus、Grafana、Jaeger的核心思想,并以通俗语言进行阐述)

云原生监控那些事儿,从底层到应用全方位拆解和讲透

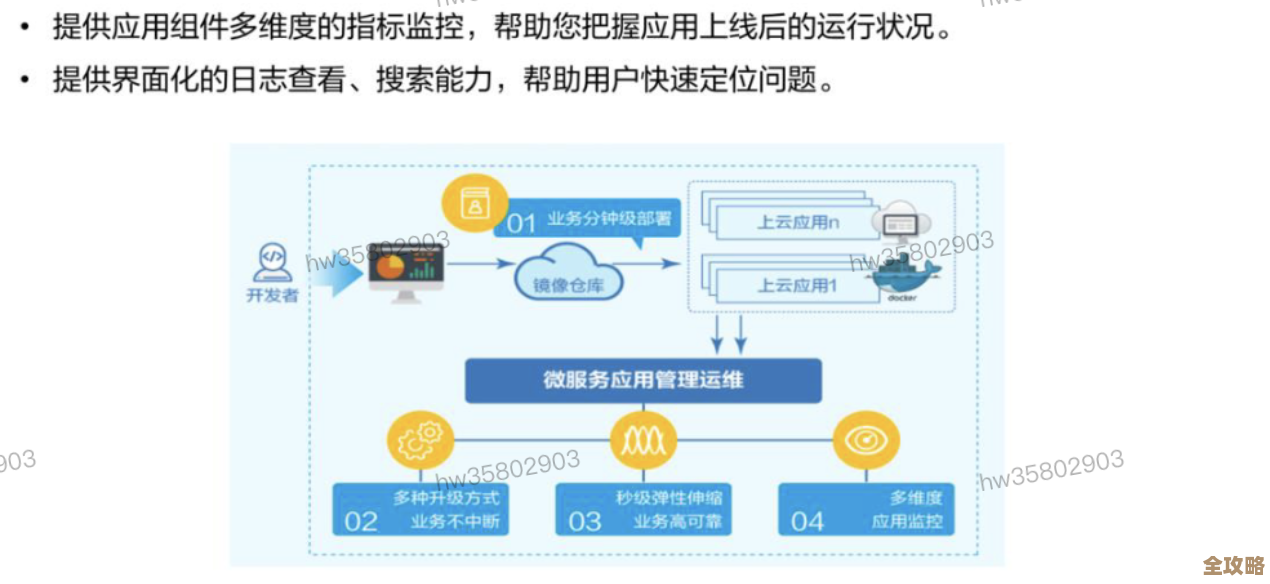

咱们先聊聊为啥云原生监控和以前不一样了,以前咱们可能就管几台大机器,上面跑着几个固定的应用,监控呢,就是看看CPU高不高,内存满不满,顶多再盯着点数据库连接数,但云原生环境变了,一切都“动”起来了,根据InfoQ社区上多位技术专家的观点,容器就像一个个小盒子,今天在这台机器上,明天可能就被搬到另一台机器上了;服务呢,为了应对访问压力,可能会自动变出十个八个副本,忙完了又自动消失几个,这种动态、弹性的特性,让传统的监控手段,比如固定IP地址的监控,完全失效了,云原生监控的第一要义就是:要能适应这种动态和短暂的生命周期。

那怎么监控呢?咱们从最底层开始说。底层基础设施监控,说白了就是看那些“装容器的机器”还健康不健康,这包括物理服务器或者云上的虚拟机,这里要看的指标和传统监控差不多,还是CPU、内存、磁盘空间和IO、网络流量这些,但关键点是,采集这些数据的代理(比如Prometheus的Node Exporter)也得是云原生的,它要能自动发现新加入的机器,也能在机器被销毁时停止监控,这些底层指标告诉我们资源池的整体水位,是稳定性的基础。

再往上走一层,就到了容器层监控,这是云原生监控的核心特色,我们需要知道每个“小盒子”(容器)的运行情况,这个容器现在用了多少CPU和内存?它重启了多少次?(频繁重启可能意味着应用有问题),它的磁盘用得快不快?这些信息通常由容器运行时(比如Docker)和编排平台(比如Kubernetes)本身提供,Prometheus这类监控系统会通过接口去抓取这些数据,通过容器监控,我们能快速定位到是哪个具体的服务实例在消耗异常资源。

光知道容器健康还不够,我们得知道容器里面跑的应用服务本身好不好,这就是应用性能监控,这里要看的东西就细了。

- 黄金指标:这是Google在“SRE手册”里提出的经典概念,包括:流量(每秒请求数)、错误率(请求失败的百分比)、延迟(响应时间),这三个指标简单直接,能最快速度告诉你服务是否正常。

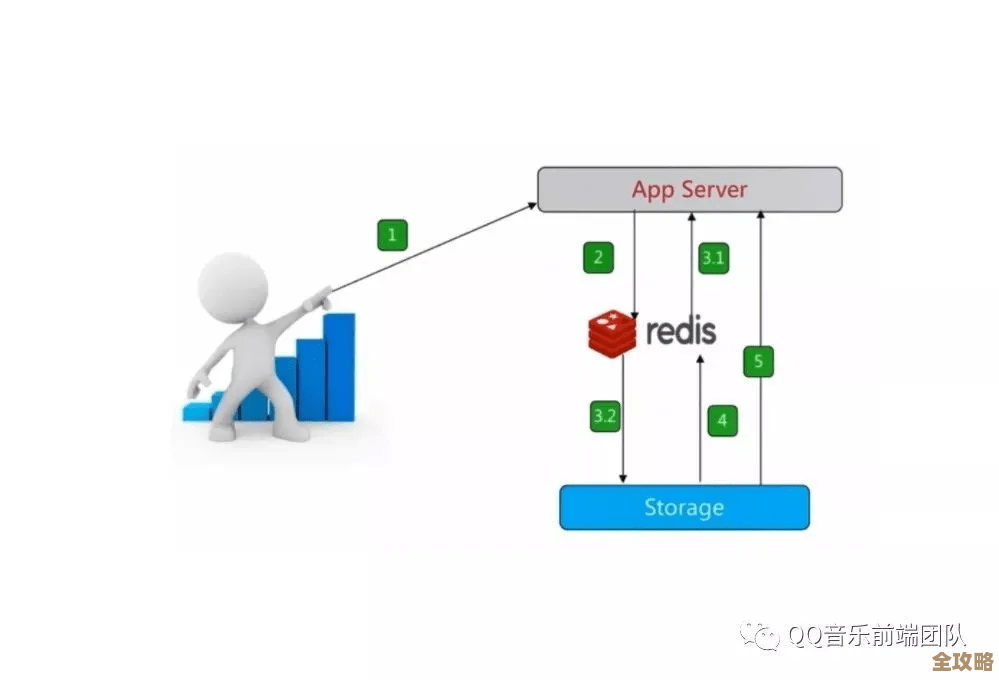

- 应用内部指标:比如一个Java应用,我们可能还想看JVM的内存垃圾回收情况、线程池的状态;一个数据库,我们想看当前的连接数、慢查询的数量,应用需要通过一些客户端库(比如Prometheus的Client Library)主动暴露这些自定义指标。

光有数字还不够,当用户报障说“页面打不开了”,你怎么快速找到问题出在哪儿?这就需要用分布式追踪了,想象一下,用户的一个请求,可能先经过网关,然后调用了用户服务,用户服务又去调用了订单服务,订单服务还查询了数据库,这个请求像一条链子一样穿过了很多个服务,分布式追踪(比如用Jaeger或Zipkin)就是给这个请求分配一个唯一的“追踪ID”,然后在每个经过的地方都打上一个时间点的记录(叫Span),我们就能看到一个完整的“流水账”,一眼看出是哪个服务环节慢了、出错了,这比在成百上千个容器日志里大海捞针要高效得多。

所有这些监控数据采集上来,得有个地方展示和告警,这就是可视化与告警,Grafana是这个领域最流行的工具,它能把Prometheus等数据源的数据变成漂亮的图表和仪表盘,告警规则则设置在Prometheus或专门的告警管理器里,当指标异常(比如错误率超过5%持续2分钟)时,能通过钉钉、短信、邮件等方式通知到人。

云原生监控是一个立体的体系,它从底层的基础设施,到中间的容器平台,再到上层的应用逻辑和用户请求链路,都布满了“传感器”,这些传感器采集的数据相互关联,共同描绘出整个系统真实的健康度和性能表现,其核心思想不再是简单地“看机器”,而是以应用为中心,追踪动态变化,快速定位影响用户体验的根本原因,只有建立起这样一套全方位的监控体系,才能在云原生这种复杂环境下真正做到心中有数,运维不慌。

本文由黎家于2026-01-01发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/72381.html