Redis集群在线迁移怎么高效搞定,实操经验分享和技巧总结

- 问答

- 2025-12-31 18:52:42

- 4

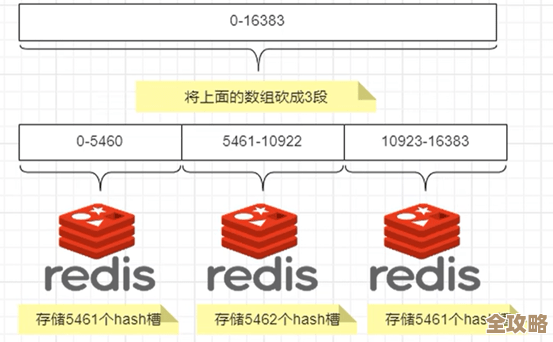

我之前看过一篇来自某技术团队博客的分享,讲的是他们如何在不影响线上业务的情况下,把一个大型Redis集群的数据迁移到另一个新的集群,整个过程他们没用什么特别高深的工具,就是用了Redis自带的命令,但思路很巧妙,我觉得非常实用。

他们的核心方法叫“双写”,顾名思义,就是在一段时间内,把数据同时写到旧集群和新集群里,这听起来简单,但具体怎么做才能高效又不出错,里面有不少细节。

第一步:准备工作,把新集群搭起来 这个没啥好说的,就是按照你的需求,把新的Redis集群搭建好,并且确保网络互通,这里有个小技巧,他们建议在业务低峰期开始操作,这样万一出点问题,影响也小。

第二步:开启“数据同步”和“双写” 这是最关键的一步,他们不是一口气把旧集群的数据全部复制过去,那样数据量太大,耗时久,而且期间旧集群还在不停写新数据,很容易导致两边数据不一致。

他们的做法是先利用Redis的MIGRATE命令,或者更常见的,用一个叫redis-shake的开源工具(这个是阿里云开源的一个工具,很多团队都用它来做数据同步),开始把旧集群的存量数据“悄悄地”同步到新集群,这个同步过程可以慢慢来,因为不影响旧集群对外服务。

在存量数据同步的同时,他们会在应用程序的代码里动手术,也就是修改写数据的逻辑,让每一次写请求,不再是只写旧集群,而是同时写旧集群和新集群,读请求呢?暂时还是全部走旧集群,保证业务稳定,这个代码改动需要发布上线,这就是所谓的“双写”开始了。

第三步:增量数据追平

由于在第二步的存量数据同步过程中,旧集群依然有新的写操作,所以新集群的数据肯定会比旧集群旧一点,等存量数据基本同步完成后,他们会让redis-shake这类工具再跑一次,专门同步一下在存量同步期间产生的增量数据,因为这段时间不长,增量数据量不大,所以这次同步会非常快,这次同步的目的,就是让两个集群的数据几乎完全一致。

第四步:切换读流量 当确认新集群的数据已经和旧集群基本一致后,最稳妥的做法是“灰度切换”读流量,可以先让一小部分用户(比如1%的用户)的读请求走到新集群上,观察一段时间,看看有没有报错,数据对不对,如果一切正常,再慢慢扩大这个比例,比如到10%、50%,最后全部切换到新集群,这个过程可以很灵活,通过配置中心或者负载均衡器的策略来动态调整,不需要重启服务。

第五步:验证和下线旧集群 当所有的读流量都切换到新集群,并且稳定运行了一段时间(比如24小时)后,就可以确认迁移成功了,这时候,再回过头去把应用程序代码里的“双写”逻辑去掉,让程序只写新集群,旧集群就可以放心地下线了。

我总结的几个实用技巧:

- 监控一定要到位:在整个迁移过程中,必须死死盯住两个集群的监控指标,比如CPU、内存、网络IO、延迟等,一旦发现新集群有异常,可以立刻把读流量切回旧集群。

- 密钥(Key)的兼容性:迁移前一定要检查新集群的配置,特别是像

hash-tag这种规则,必须和旧集群保持一致,否则数据分布会出问题,导致找不到数据。 - 做好回滚预案:心里要清楚,万一迁移失败,怎么快速退回去,通常就是关闭双写,把读流量全部切回旧集群,这是最保险的退路。

- 选择合适的工具:像

redis-shake这种工具,对大量数据的迁移效率很高,而且支持断点续传,比单纯用Redis命令更省心,这是那篇博客里强烈推荐的。 - 在测试环境充分演练:这么重要的操作,千万别直接在生产环境干,一定要在测试环境模拟好几遍,把流程跑通,预估出每个阶段大概要花多长时间,可能会遇到什么坑。

这个方法的核心思想就是“平滑”二字,通过双写和灰度切换,把一个大风险的操作,分解成多个可观察、可回滚的小步骤,最大程度保证线上业务的稳定,虽然比那种停服迁移的方式周期长一点,但对于需要7x24小时服务的系统来说,是非常值得的。

本文由畅苗于2025-12-31发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/72016.html