用Redis做负载均衡测试,看看性能到底咋样能撑住多少请求

- 问答

- 2025-12-24 01:32:14

- 2

首先需要明确一点,我们通常不会说“用Redis做负载均衡”,这个说法本身有点外行,容易引起误解,Redis本身不是一个像Nginx或HAProxy那样的负载均衡器软件,更准确的说法是,“在负载均衡的场景下,使用Redis作为共享数据存储,测试整个系统的性能,看看Redis能撑住多少请求”,这是很多互联网公司实际在做的事情,比如用Redis存用户会话、缓存热门数据、或者做秒杀系统的库存计数。

要测试Redis的性能,看看它到底能撑住多少请求,不能光靠猜,得动手做实验,这里说的测试,简单来讲,就是模拟成千上万的用户同时访问Redis,然后看它在什么情况下开始变慢、什么情况下会撑不住。

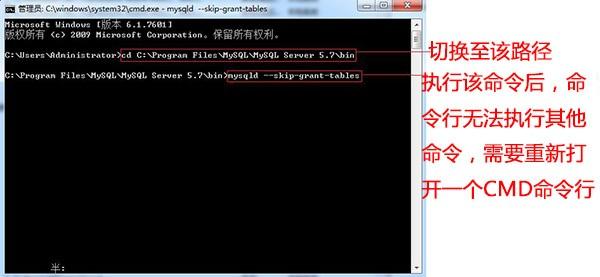

第一步:搭建测试环境 这就像修个赛道去测试赛车性能,你需要准备至少两台电脑:一台当“运动员”(Redis服务器),另一台当“发令员和计时员”(测试机器),为了让结果真实,最好用云服务器,避免自己老旧的笔记本电脑成为瓶颈,Redis服务器要有足够的内存和好的CPU,测试机器最好有多个核心,因为测试工具会开很多线程来模拟大量用户。

第二步:选择测试工具

最常用的“计时员”工具叫redis-benchmark,它是Redis官方自带的,开箱即用,用起来很简单,在命令行里输入像redis-benchmark -h your_redis_ip -p 6379 -c 100 -n 100000这样的命令就行了,这里-c 100表示模拟100个用户同时连接,-n 100000表示总共发10万次请求,这个工具能测试SET(存数据)、GET(取数据)等不同命令的速度。

但redis-benchmark比较简单,想要更复杂、更真实的测试,可以用memtier_benchmark(Redis官方推荐)或者YCSB(雅虎开源的通用压测工具),这些工具可以模拟更复杂的访问模式,比如读写混合、按照特定规律访问不同key等。

第三步:设计测试场景 这是最关键的一步,因为不同的使用方式,Redis的表现天差地别,你不能只测最简单的“SET一个很小的字符串”,那得出的数字会高得离谱,但不代表你的业务能撑住,需要模拟真实业务:

- 数据大小:你业务里存的数据是多大?是几十字节的用户令牌,还是几KB的文章摘要?分别测试不同数据大小(如1KB, 10KB)下的性能。

- 读写比例:你的应用是读多写少(比如新闻网站,90%的读,10%的写),还是写多读少(比如日志收集)?设置不同的读写比例(如1:9, 5:5)进行测试。

- Key的分布:是所有的请求都集中在少数几个热门key上(秒杀商品A”),还是均匀地访问海量key?这能测试出Redis在“热点数据”和“海量数据”下的表现。

- 使用复杂数据结构:如果你用了Redis的Hash(哈希)、Sorted Set(有序集合)等复杂结构,也要专门测试这些命令的性能。

第四步:运行测试并观察结果 运行压测命令后,你会得到一堆数字,最重要的几个指标是:

- QPS:每秒处理了多少个请求,比如GET命令可能达到10万QPS,而做复杂计算的命令可能只有1万QPS。

- 延迟:处理每个请求花了多少时间,通常看平均延迟、以及P99延迟(最慢的那1%的请求的延迟),P99延迟对用户体验至关重要,比如虽然平均延迟才1毫秒,但P99延迟可能高达100毫秒,意味着每100个请求里就有一个用户会觉得卡。

- CPU和内存使用率:在压测过程中,用

top等命令盯着Redis服务器的CPU和内存,看看是CPU先跑到100%成了瓶颈,还是内存先不够用。

第五步:分析“撑不住”的表现和优化 当请求量越来越大,Redis总会“撑不住”,迹象包括:

- QPS上不去了:无论你怎么增加并发用户数,QPS就像碰到天花板一样不再增长。

- 延迟急剧上升:请求开始排队,响应时间从几毫秒飙升到几百毫秒甚至秒级。

- 出现错误:开始出现连接超时、连接被拒绝等错误。

这时候,你就找到了当前配置下的性能瓶颈,然后就可以想办法优化:

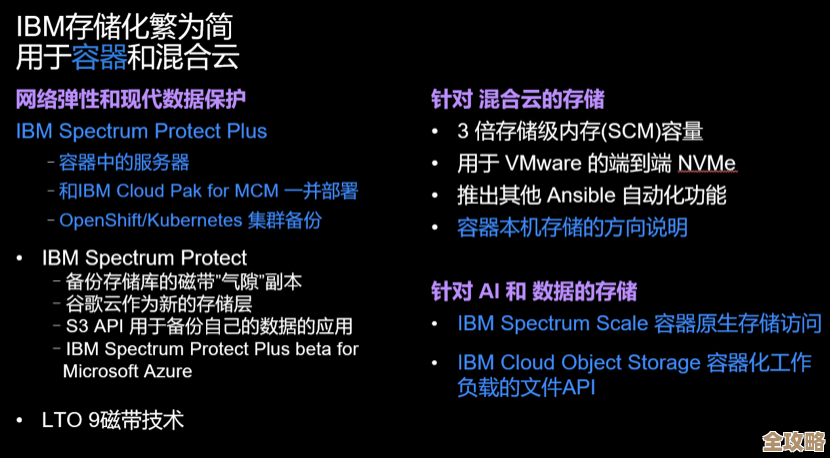

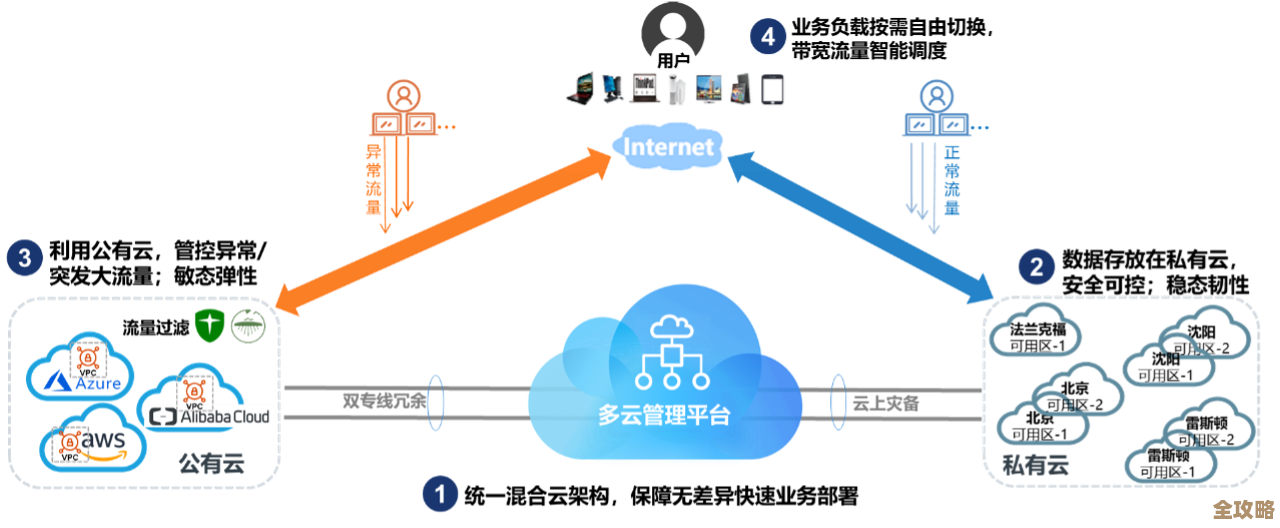

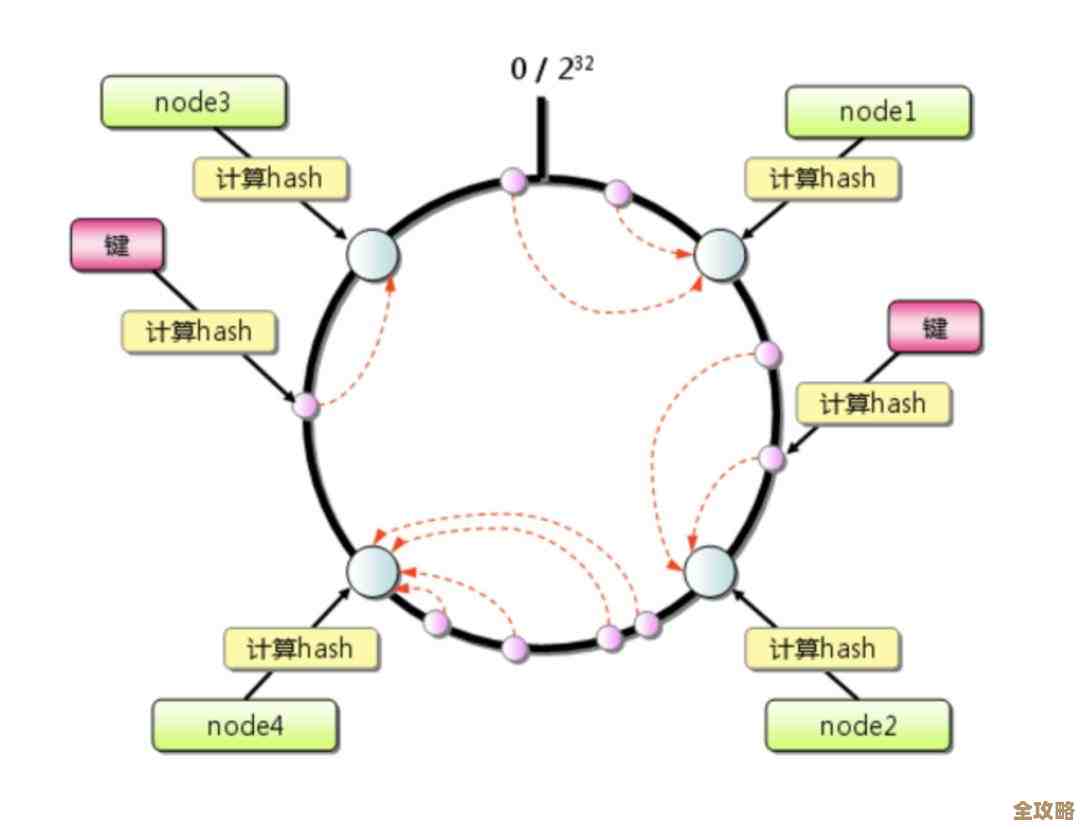

- 如果CPU是瓶颈:可以考虑使用Redis的集群模式,把数据分片到多台机器上,分散CPU压力,这就是一种横向扩展。

- 如果网络是瓶颈:可以检查服务器网络带宽,或者优化命令,比如使用

MGET(批量获取)代替多次GET。 - 如果内存是瓶颈:可以设置合理的数据过期时间,或者使用更节省内存的数据结构。

回到“Redis能撑住多少请求”这个问题,答案是:“看情况,没有一个固定数字”,根据Redis官方文档的示例和业界普遍的实践经验,在一个配置得当的单机Redis上,处理简单的KV操作,达到每秒数万甚至十几万的QPS是很常见的,但如果业务逻辑复杂、数据量大、读写模式苛刻,这个数字会大幅下降。 最靠谱的方法就是根据你自己业务的实际情况,搭建一个模拟环境,用上面说的步骤自己去压测,你才能得到对你而言最真实、最有价值的“性能天花板”数据,并知道当业务增长时,该从何处着手优化。

本文由召安青于2025-12-24发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://www.haoid.cn/wenda/67256.html